近期,北京大学联合科研团队推出了一款名为LLaVA-o1的多模态开源模型,该模型被誉为首个具备自发、系统性推理能力的视觉语言模型,与GPT-o1不相上下。

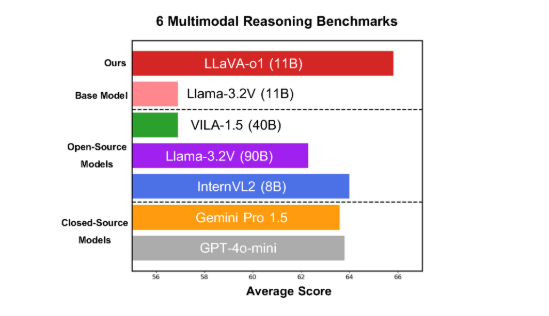

LLaVA-o1在六项具有挑战性的多模态基准测试中取得了卓越成绩,其11B参数版本在竞争中脱颖而出,超越了Gemini-1.5-pro、GPT-4o-mini以及Llama-3.2-90B-Vision-Instruct等模型。

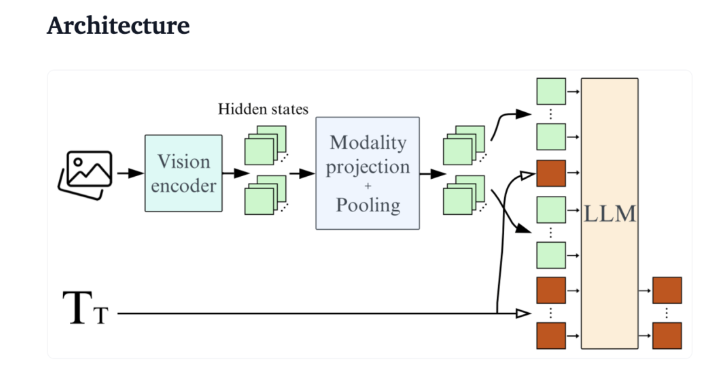

LLaVA-o1基于Llama-3.2-Vision模型,引入了“慢思考”推理机制,能够自主进行更复杂的推理,超越了传统的思维链提示方法。

在多模态推理基准测试中,LLaVA-o1的表现比其基础模型提高了8.9%。该模型的独特之处在于其推理过程分为四个阶段:总结、视觉解释、逻辑推理和结论生成。相较于传统模型简单的推理过程,LLaVA-o1通过结构化的多步骤推理,确保了更精确的输出。

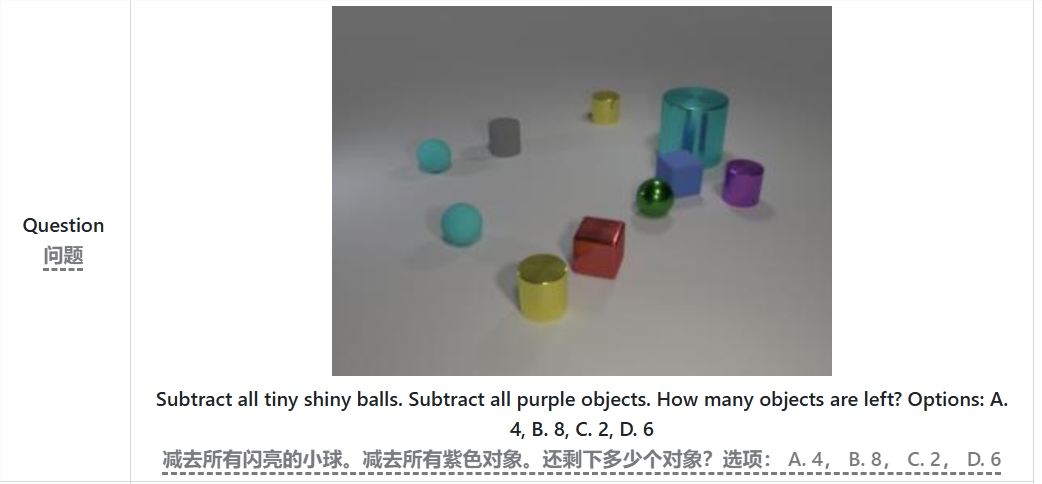

例如,在处理“减去所有的小亮球和紫色物体,剩下多少个物体?”的问题时,LLaVA-o1会先总结问题,再从图像中提取信息,进行逐步推理,最终给出答案。这种分阶段的方法提高了模型的系统推理能力,使其在应对复杂问题时更为高效。

值得一提的是,LLaVA-o1在推理过程中采用了阶段级光束搜索方法。该方法允许模型在每个推理阶段生成多个候选答案,并选择最佳答案继续下一阶段推理,从而显著提升了整体推理质量。通过监督微调和合理训练数据,LLaVA-o1在与大型或闭源模型的对比中表现优异。

北大团队的研究成果不仅推动了多模态AI的发展,还为视觉语言理解模型提供了新的研究思路和方法。团队表示,LLaVA-o1的代码、预训练权重和数据集将全面开源,期待更多研究者和开发者共同探索和应用这一创新模型。

论文链接:https://arxiv.org/abs/2411.10440

GitHub链接:https://github.com/PKU-YuanGroup/LLaVA-o1

重点摘要:

🌟 LLaVA-o1是北京大学等团队发布的全新多模态推理模型,具备“慢思考”推理能力。

📈 该模型在多模态推理基准测试中性能超越基础模型8.9%。

🔍 LLaVA-o1通过结构化的多步骤推理,确保准确性,并将于近期开源。

暂无评论