自 OpenAI 在 2023 年推出函数调用(Function Calling)功能以来,业界一直在探索如何构建一个繁荣的 AI 智能体(Agent)和工具使用生态系统。随着基础模型不断强大,智能体与外部工具、数据和 API 交互的能力却逐渐变得碎片化。开发者必须为智能体的每个运行和集成系统实现特定的业务逻辑。

显然,执行、数据获取和工具调用需要一个标准接口。API 是互联网的第一个伟大统一者,为软件通信创造了共享语言,但 AI 模型缺乏类似物。

(adsbygoogle=window.adsbygoogle||[]).push({});

模型上下文协议(Model Context Protocol, MCP),于 2024 年 11 月推出,作为一种潜在的解决方案,在开发者和 AI 社区中引起了广泛关注。本文将探讨 MCP 是什么,它如何改变 AI 与工具的交互方式,开发者已经用它构建了什么,以及仍需解决的挑战。

什么是 MCP?

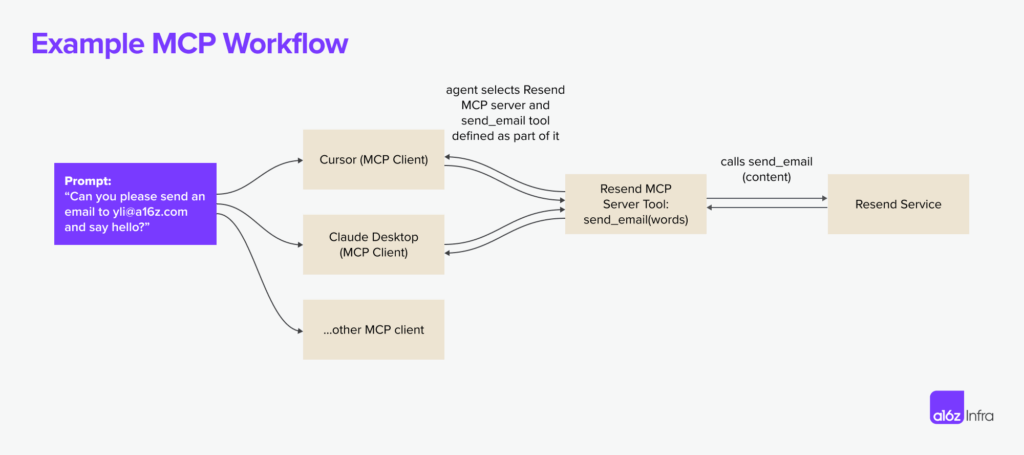

MCP 是一个开放协议,允许系统以一种跨集成通用的方式向 AI 模型提供上下文。该协议定义了 AI 模型如何调用外部工具、获取数据以及与服务交互。以下图展示了 Resend MCP 服务器如何与多个 MCP 客户端协同工作。

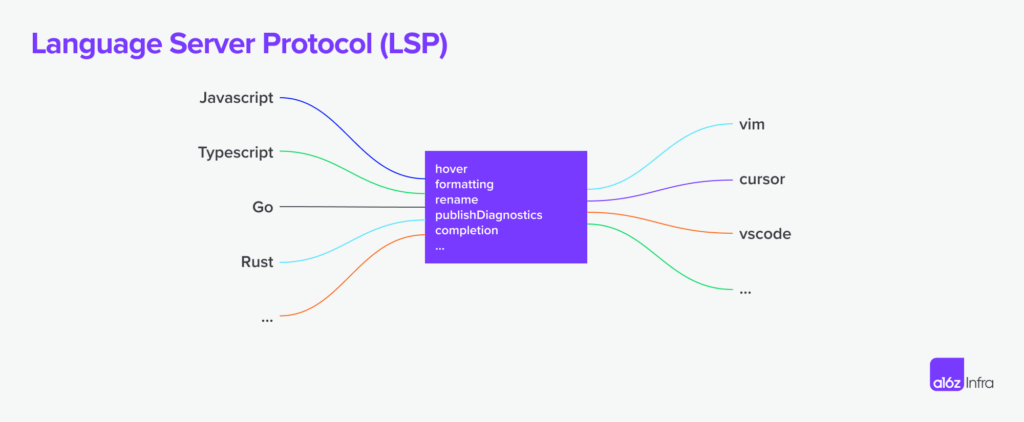

这个想法并不新鲜;MCP 从语言服务器协议(Language Server Protocol, LSP)中汲取了灵感。在 LSP 中,当用户在编辑器中输入时,客户端会查询语言服务器以获取自动完成建议或诊断信息。LSP 的成功在于它解耦了语言特性(如自动补全、错误检查)的实现与编辑器本身,使得一种语言服务器可以服务于多种编辑器,极大地提高了开发效率和生态系统的活力。

MCP 相较于 LSP 的扩展之处在于其以智能体为中心的执行模型。LSP 主要是响应式的(根据用户输入响应来自 IDE 的请求),而 MCP 则设计用于支持自主的 AI 工作流。基于上下文,AI 智能体可以决定使用哪些工具、以何种顺序使用,以及如何将它们链接起来以完成任务。这一点是关键区别:LSP 辅助人类开发者,而 MCP 旨在让 AI 智能体更自主地行动。MCP 还引入了“人在回路”(human-in-the-loop)能力,允许人类提供额外数据和批准执行,增加了可控性。

<img decoding="async" class="aligncenter size-full wp-image-29493" title="QR Galaxy:生成美观二维码的在线工具-3" src="https://www.aisharenet.com/wp-content/uploads/2025/03/5e

暂无评论