人工智能技术的迅猛发展,催生了视觉语言模型(VLMs)的革新。这些模型能够同步处理视觉与文本信息,广泛应用于图像描述、视觉问答、光学字符识别以及多模态内容分析等领域。

VLMs在自主系统开发、人机交互提升和文档处理工具的高效化方面起到了关键作用,成功缩小了视觉与文本数据之间的鸿沟。然而,面对高分辨率视觉数据和多样化的文本输入,仍面临诸多挑战。

现有研究虽已部分克服这些局限,但大多数模型采用的静态视觉编码器在应对高分辨率和不同尺寸输入时适应性不足。此外,预训练语言模型与视觉编码器的结合往往效率不高,因为它们未针对多模态任务进行优化。尽管有些模型采用了稀疏计算技术以简化复杂度,但在不同数据集上的准确性仍有待提高。同时,训练数据集的多样性和任务特异性不足,也限制了模型的表现,例如在专业任务如图表解读或密集文档分析中表现不佳。

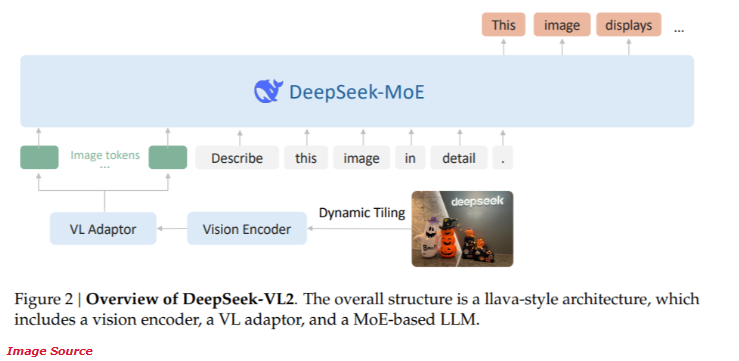

近期,DeepSeek-AI推出了DeepSeek-VL2系列开源混合专家(MoE)视觉语言模型。该系列模型融合了先进技术,包括动态视觉编码切片、多头潜在注意机制以及DeepSeek-MoE框架。

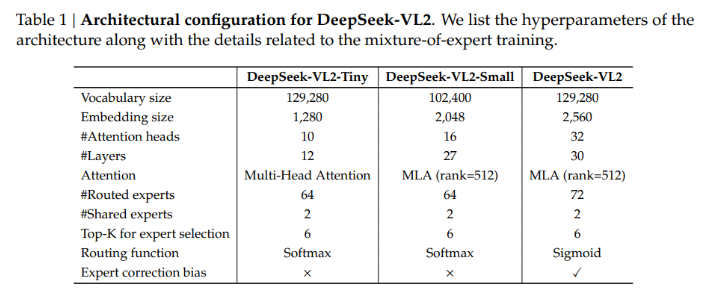

DeepSeek-VL2系列提供以下三种参数配置:

- DeepSeek-VL2-Tiny:拥有33.7亿参数(10亿激活参数)

- DeepSeek-VL2-Small:拥有161亿参数(28亿激活参数)

- DeepSeek-VL2:拥有275亿参数(45亿激活参数)

这种灵活性确保了模型能够满足不同应用需求和计算预算。

DeepSeek-VL2的架构旨在提高性能,同时降低计算需求。动态切片技术确保了高分辨率图像处理的关键细节不丢失,非常适合文档分析和视觉定位任务。多头潜在注意机制使得模型在处理大量文本数据时更为高效,降低了与密集语言输入相关的计算成本。DeepSeek-VL2的训练覆盖了多样化的多模态数据集,使其在光学字符识别、视觉问答和图表解读等多种任务中表现优异。

性能测试显示,Small配置在光学字符识别任务中达到了92.3%的准确率,远超现有模型。在视觉定位基准测试中,该模型的精准度较前代产品提高了15%。

同时,DeepSeek-VL2在保持先进准确率的基础上,计算资源需求降低了30%。这些成果证明了该模型在高分辨率图像与文本处理方面的卓越性能。

项目地址:https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

重点提示:

🌟 DeepSeek-VL2系列提供多种参数配置,满足不同应用需求。

💡 动态切片技术提升了高分辨率图像处理的效率,适用于复杂文档分析。

🔍 模型在光学字符识别和视觉定位任务上表现卓越,准确率显著提升。

暂无评论