近年来,机器学习模型在视觉和语言任务中的需求不断上升。然而,大多数模型需要消耗大量计算资源,无法高效地在个人设备上运行。特别是对于笔记本电脑、消费级 GPU 和移动设备等小型设备,这些视觉语言任务的处理面临着严峻的挑战。

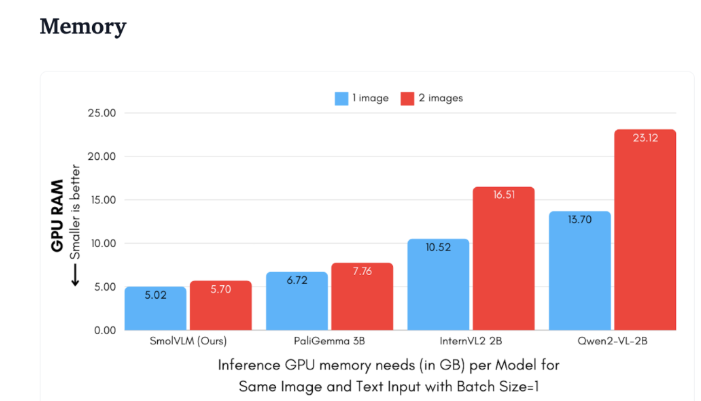

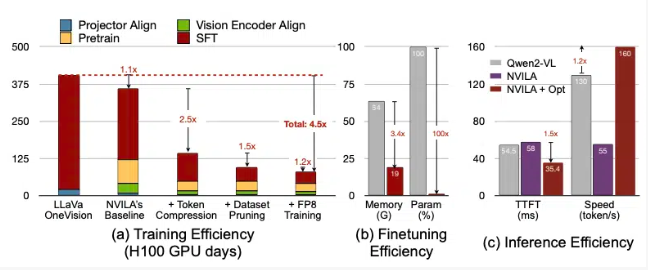

以 Qwen2-VL 为例,尽管其性能优秀,但硬件需求较高,限制了其在实时应用中的可用性。因此,开发轻量化模型以在较低资源条件下运行,成为了一个重要的需求。

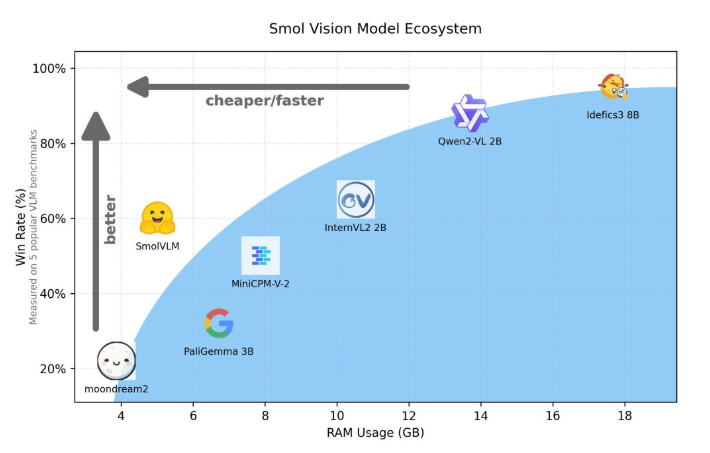

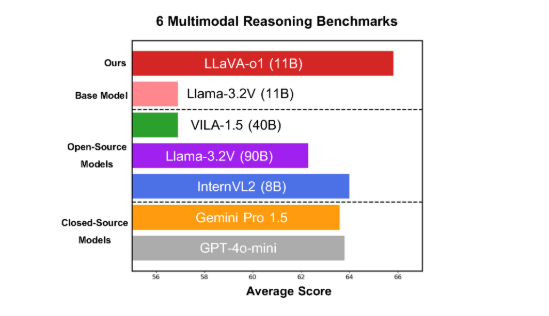

近期,Hugging Face 发布了 SmolVLM,这是一款面向设备端推理而设计的2B 参数视觉语言模型。SmolVLM 在 GPU 内存利用和令牌生成速度上超越了其他同类模型,展现了其在小型设备(如笔记本电脑或消费级 GPU)上的高效性能,而又没有牺牲效果。该模型在性能和效率之间找到了卓越的平衡,成功解决了以往同类模型面临的许多问题。

与 Qwen2-VL2B 相比,SmolVLM 的令牌生成速度提高了7.5到16倍,这得益于其优化的架构,使轻量级推理成为可能。这一显著提升不仅带来了实用性,还极大改善了用户体验。

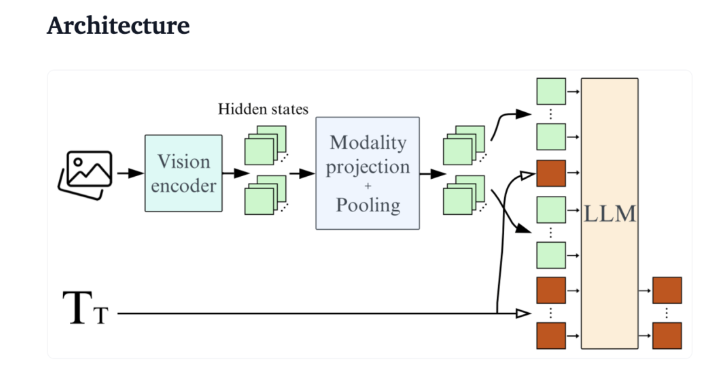

从技术角度看,SmolVLM 拥有优化的架构,支持高效的设备端推理。用户可以在 Google Colab 上轻松进行微调,这大大降低了试验和开发的门槛。

因其内存占用小,SmolVLM 能够在之前无法承载同类模型的设备上顺畅运行。在对50帧 YouTube 视频进行测试时,其得分达27.14%,而在资源消耗方面优于两款更为消耗资源的模型,显示出其强大的适应能力和灵活性。

SmolVLM 在视觉语言模型领域具备重要的里程碑意义,其推出使得复杂的视觉语言任务能够在日常设备上顺利运行,填补了当前 AI 工具中的一项重要空白。

不仅在速度和效率上表现优异,SmolVLM 还为开发者和研究者提供了一个强大的工具,以进行视觉语言处理,无需投入高昂硬件费用。随着 AI 技术的日益普及,像 SmolVLM 这样的模型将使机器学习能力更加触手可及。

demo:https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

划重点:

🌟 SmolVLM 是 Hugging Face 推出的专为设备端推理设计的2B 参数视觉语言模型,运行高效且无需高端硬件。

⚡ 其令牌生成速度为同类模型的7.5到16倍,极大提升了用户体验和应用效率。

📊 测试表明,SmolVLM 展现出强大的适应能力,即便在没有视频数据训练的情况下也能取得令人满意的成绩。

暂无评论