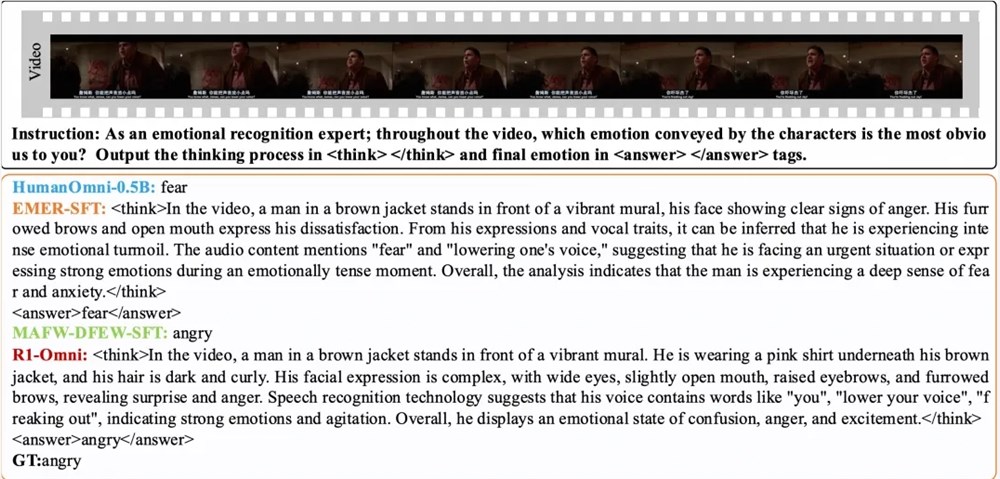

3月11日,通义实验室团队宣布其开源的R1-Omni模型,这一创新全模态模型在多模态情感识别任务领域取得了显著进展。该模型融合了强化学习与可验证奖励(RLVR)技术,旨在增强模型在多模态情感识别任务中的推理能力与泛化性能。

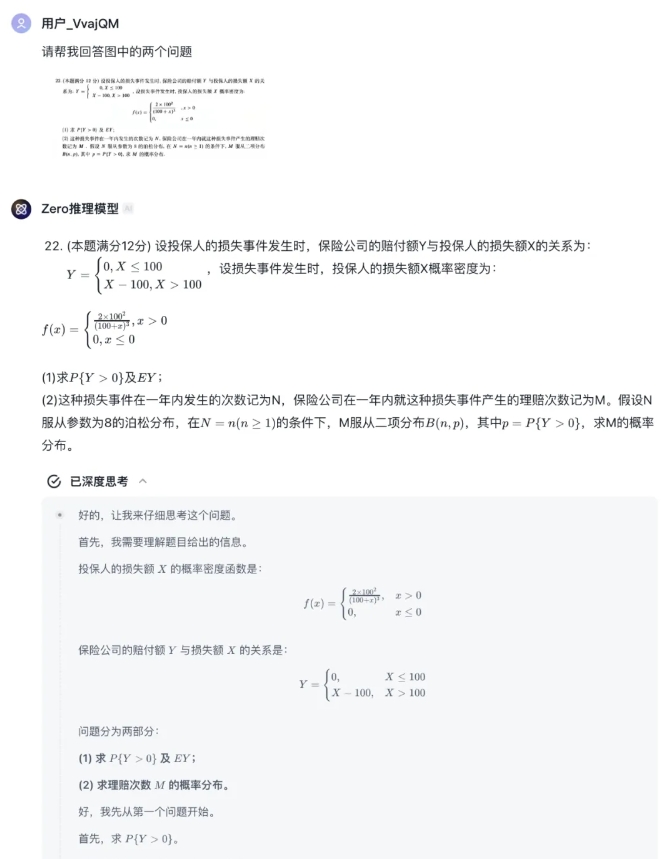

R1-Omni的训练过程分为两个阶段。在初阶的冷启动阶段,团队运用了包含580条视频数据的综合数据集进行细致的微调。这些数据来源于Explainable Multimodal Emotion Reasoning(EMER)数据集与HumanOmni数据集。该阶段旨在为模型构建初步的推理基础,确保其具备必要的多模态情感识别能力,为后续的RLVR阶段打下坚实的基础,并保证训练的顺利进行。

在RLVR阶段,模型通过强化学习与可验证奖励机制进行了进一步的优化。策略模型与奖励函数是该阶段的核心。策略模型负责处理由视频帧与音频流构成的多模态输入数据,并生成包含详细推理过程的候选响应,展示了模型如何整合视觉与听觉信息以得出预测。奖励函数则借鉴了DeepSeek R1的设计,分为精确率奖励与格式奖励,共同构成最终奖励,旨在激励模型产生正确的预测,同时确保输出的结构化与格式正确。

实验结果显示,R1-Omni在分布相同的测试集DFEW和MAFW上,与原始基线模型相比,平均性能提升了超过35%;在未加权平均召回率(UAR)上,与有监督微调(SFT)模型相比,提升了10%以上。在分布不同的测试集RAVDESS上,其加权平均召回率(WAR)和UAR均提升了超过13%,显示了其出色的泛化能力。此外,R1-Omni的透明性也显著提高,通过RLVR方法,音频和视频信息在模型中的作用变得更加清晰,可以明确展示各模态信息在特定情绪判断中的关键作用,为理解模型决策过程和未来的研究提供了重要参考。

论文链接:

https://arxiv.org/abs/2503.05379

Github链接:

https://github.com/HumanMLLM/R1-Omni

模型链接:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B

暂无评论