近期,数据智能领域的领军企业Databricks推出了一项革命性的大语言模型微调技术——TAO(Test-time Adaptive Optimization)。这项技术的问世,为开源模型的发展注入了新的活力。TAO利用无标注数据和强化学习,不仅显著降低了企业成本,而且在多个基准测试中实现了令人瞩目的成绩。

据科技媒体NeoWin报道,经过TAO微调的Llama3.370B模型在金融文档问答和SQL生成等任务上,表现优于传统标注微调方法,甚至与OpenAI的顶级闭源模型相媲美。这一成就标志着开源模型在商业AI产品竞争中的又一次重大突破。

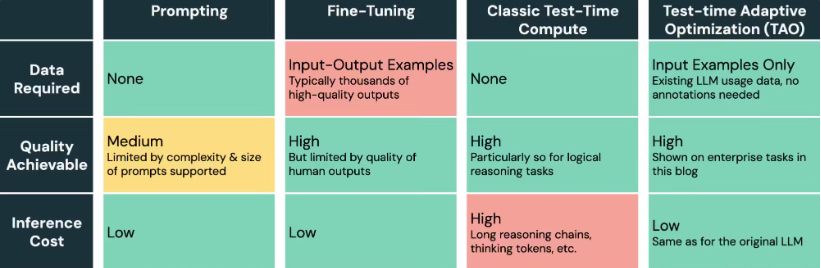

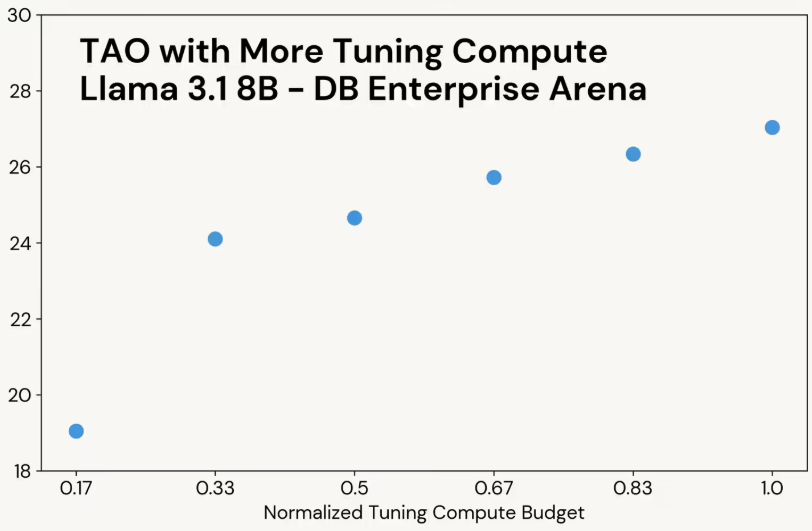

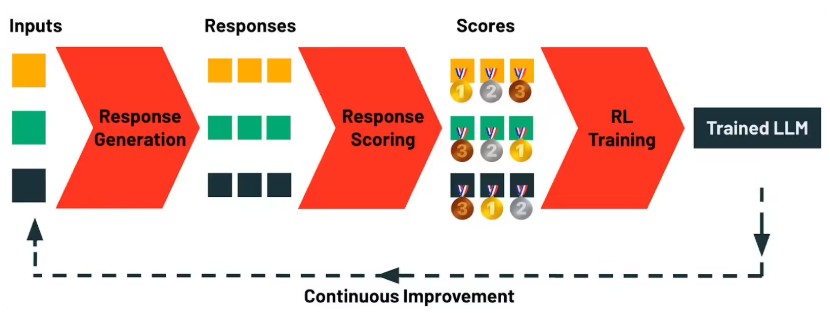

TAO技术的核心是其独特的“测试时计算”理念,能够自动探索任务的多样性,并结合强化学习优化模型,从而避免传统微调的人工标注成本。在多个企业基准测试中,TAO微调的Llama模型表现出色:

- 在FinanceBench基准测试中,该模型在7200道SEC文档问答中取得了85.1的高分,超越了传统标注微调(81.1)和OpenAI的o3-mini(82.2)。

- 在BIRD-SQL测试中,TAO微调的Llama模型得分为56.1,接近GPT-4o的58.1,远超传统标注微调(54.9)。

- 在DB Enterprise Arena中,TAO模型得分为47.2,尽管略低于GPT-4o的53.8,但依然显示出强大的竞争力。

TAO技术为开源模型的持续进化打开了新的大门。随着用户使用量的增加,模型将通过反馈数据进行自我优化。目前,Databricks已在Llama模型上启动了私测,企业可通过申请加入这一创新体验。

这一新技术的推出,不仅是开源AI领域的一次创新突破,也是对大语言模型未来发展的重大指引。随着更多企业的参与,TAO微调方法有望进一步推动开源模型的性能提升,让开源AI在商业化应用中发挥更大的潜力。

暂无评论