OpenAI 推出了一种创新的 AI 安全策略,旨在通过调整 AI 系统处理安全规则的方式,增强其安全性。该 o 系列模型不再仅依赖于示例学习来辨别好坏行为,而是能够理解和积极应用特定的安全准则。

OpenAI 的研究以一个案例为例,当用户试图通过加密文本获取非法活动指示时,模型成功解码信息,却拒绝了请求,并明确引用了即将违反的安全规则。这一逐步推理过程揭示了模型如何有效遵循安全准则。

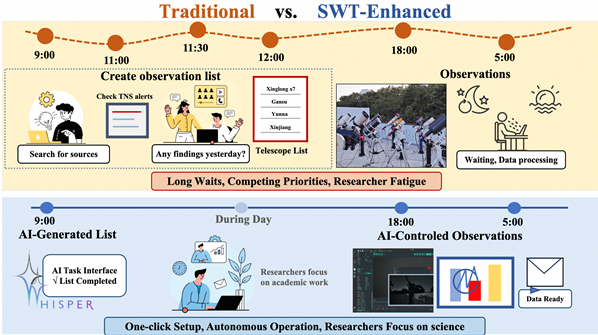

o1 模型的训练分为三个阶段。首先,模型学习提供帮助的方式。其次,通过监督学习,模型研究特定的安全指南。最后,模型通过强化学习来实践和应用这些规则,这一阶段帮助模型真正理解并内化这些安全指南。

在 OpenAI 的测试中,新推出的 o1 模型在安全性方面显著优于 GPT-4o、Claude3.5Sonnet 和 Gemini1.5Pro 等主流系统。测试内容包括模型如何拒绝有害请求并允许适当请求通过,结果显示 o1 模型在准确性和抵御越狱尝试方面均取得了最高分。

OpenAI 联合创始人沃伊切赫・扎伦巴在社交平台上表示,他对这种“深思熟虑的对齐”工作感到自豪,认为这种推理模型可以以全新的方式实现对齐,特别是在发展人工通用智能(AGI)时,确保系统与人类价值观保持一致是一项重大挑战。

尽管 OpenAI 声称取得进展,但“解放者普林尼”黑客展示了即使是新的 o1 和 o1-Pro 模型也能突破安全指南。普林尼成功让模型生成成人内容,甚至分享制作莫洛托夫鸡尾酒的指示,尽管系统最初拒绝了这些请求。这些事件凸显了控制

暂无评论