科技竞争激烈,中国AI初创企业DeepSeek近日默默更新了其V3基座模型,新版本DeepSeek-V3-0324已上线Hugging Face平台,备受开发者关注。尽管更新低调,但模型在代码能力上的提升迅速引起了热烈讨论。

DeepSeek-AI开源了DeepSeekV3更新版本,版本号0324,于2025年3月24日上传至HuggingFace,采用MIT协议开源。

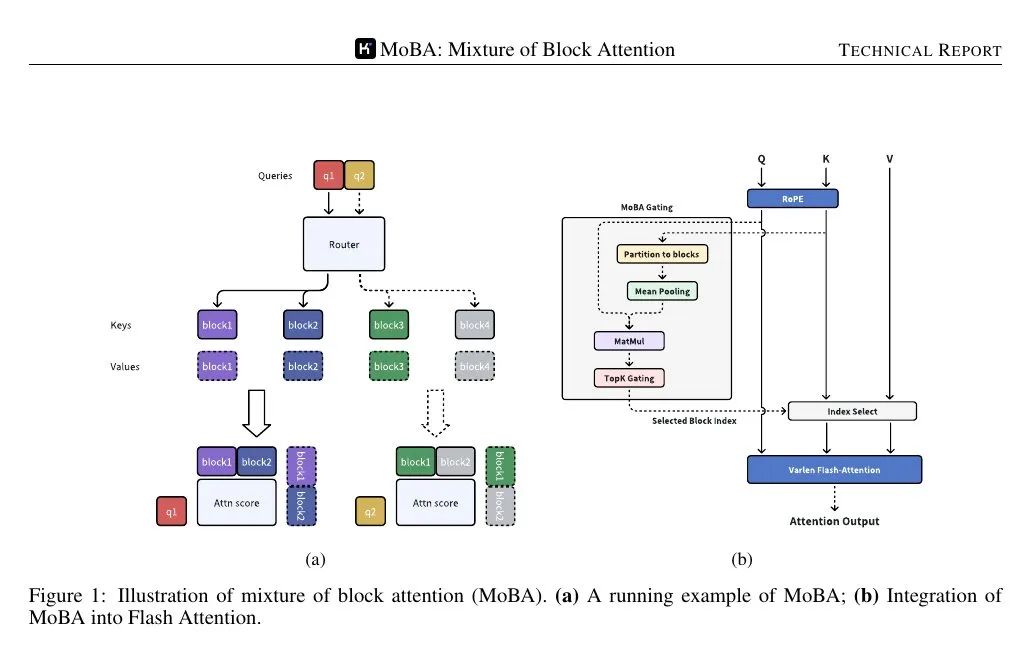

模型配置显示,DeepSeekV3-0324为MoE大模型,包含256个路由专家和1个共享专家,每个token使用8个专家进行推理。DeepSeekV3-0324通过RoPE可扩展至最高163840上下文长度(160K),词汇表大小为129280个,并集成LoRA机制,支持轻量级微调。

与2024年12月26日发布的DeepSeekV3相比,参数未变,更新可能为持续训练或后训练结果。

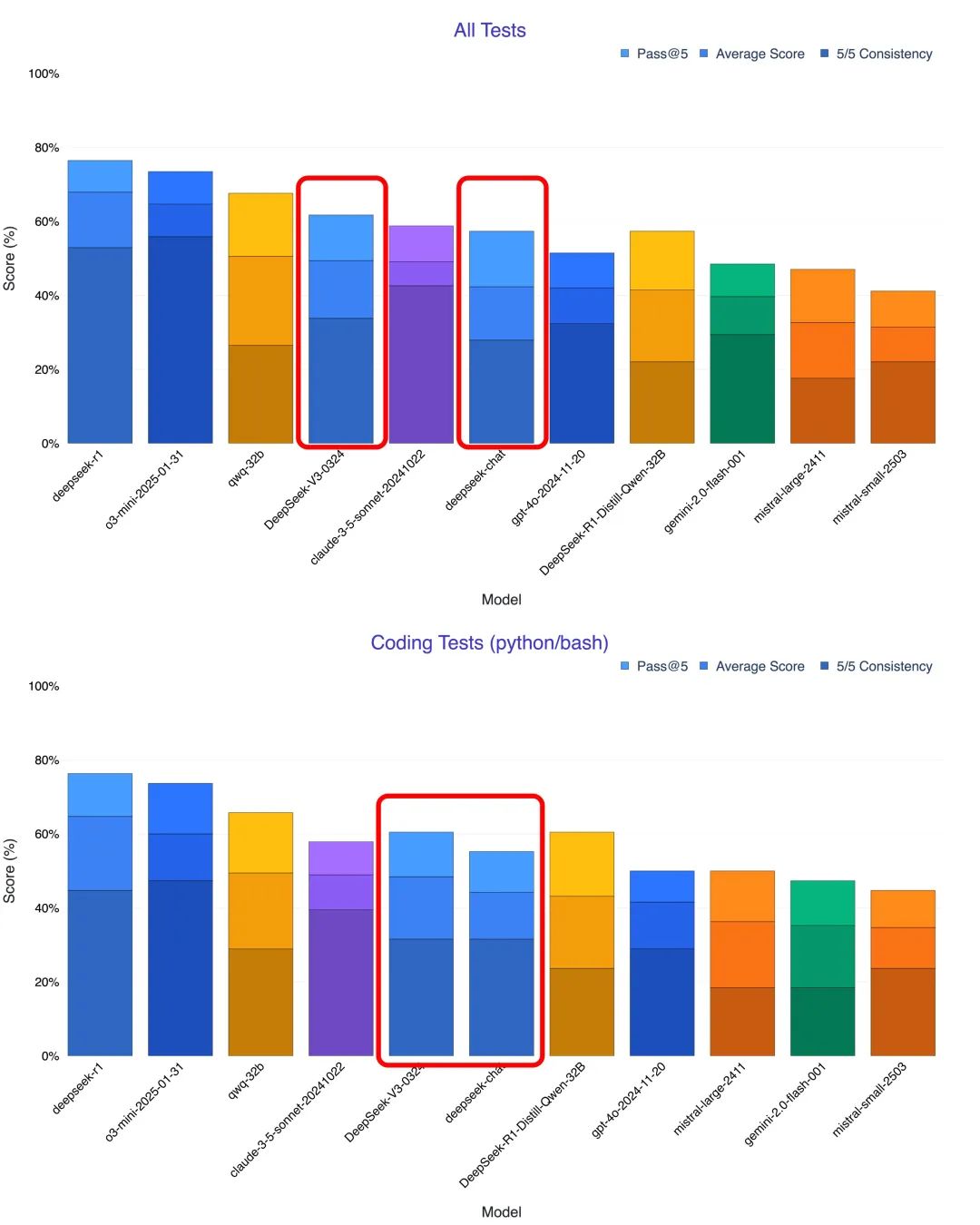

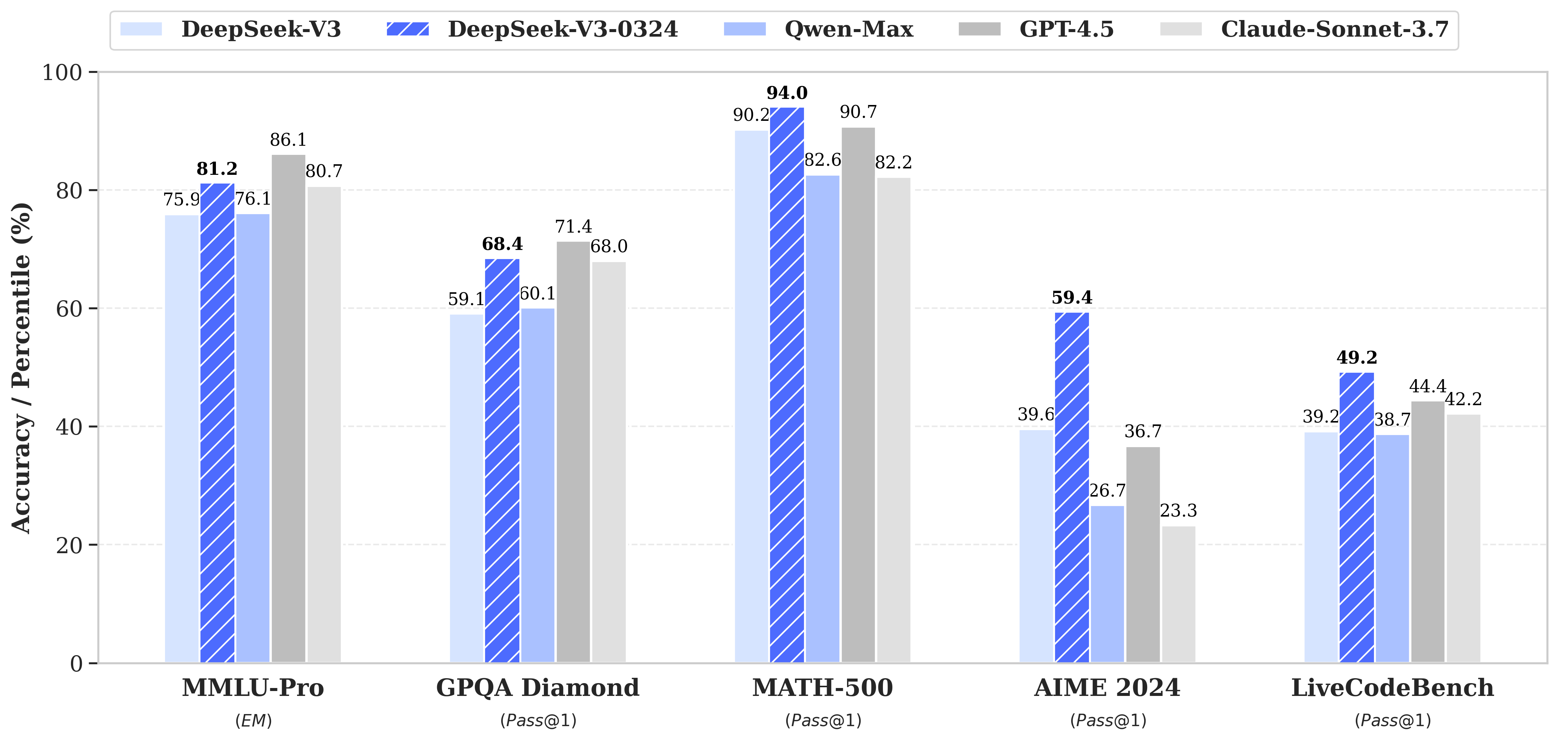

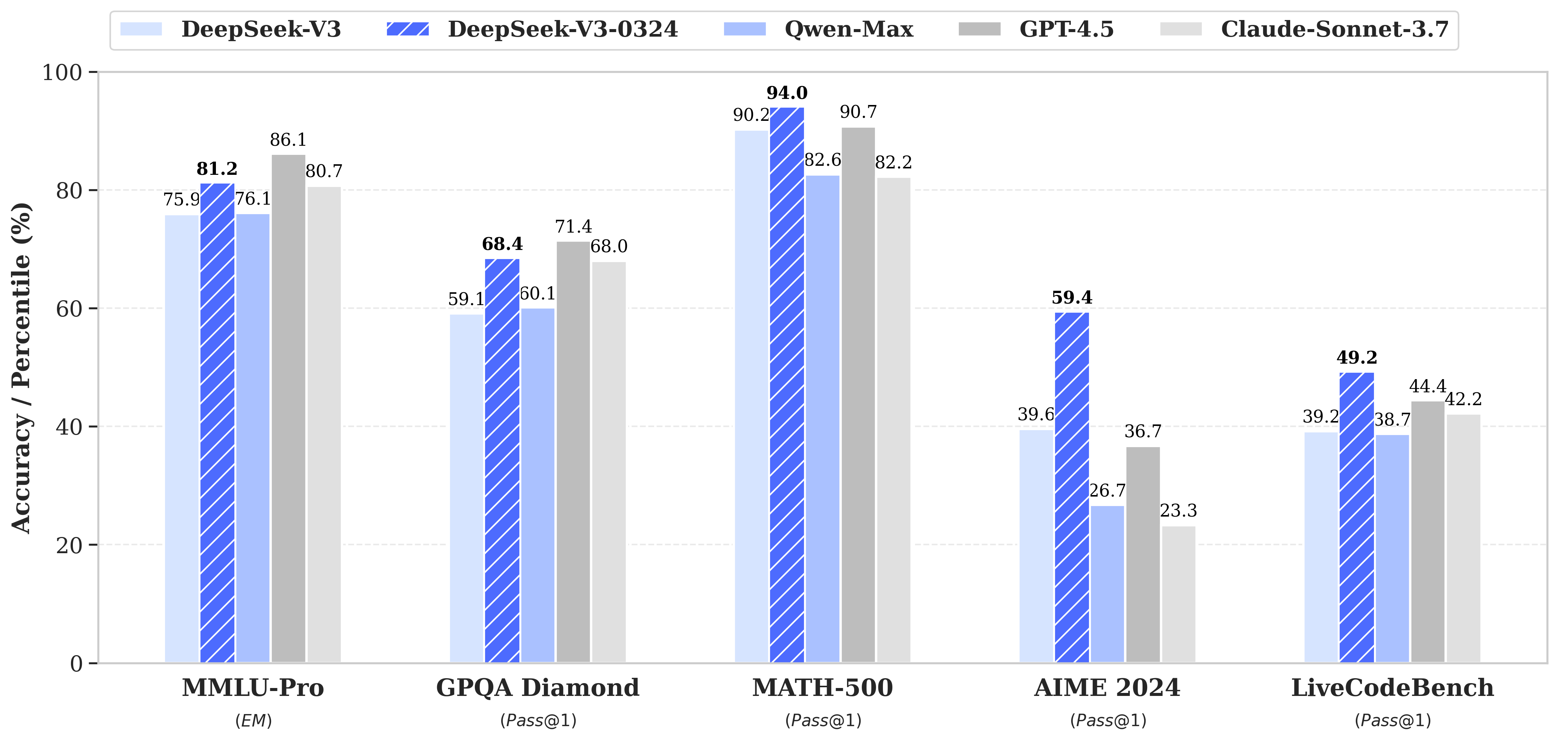

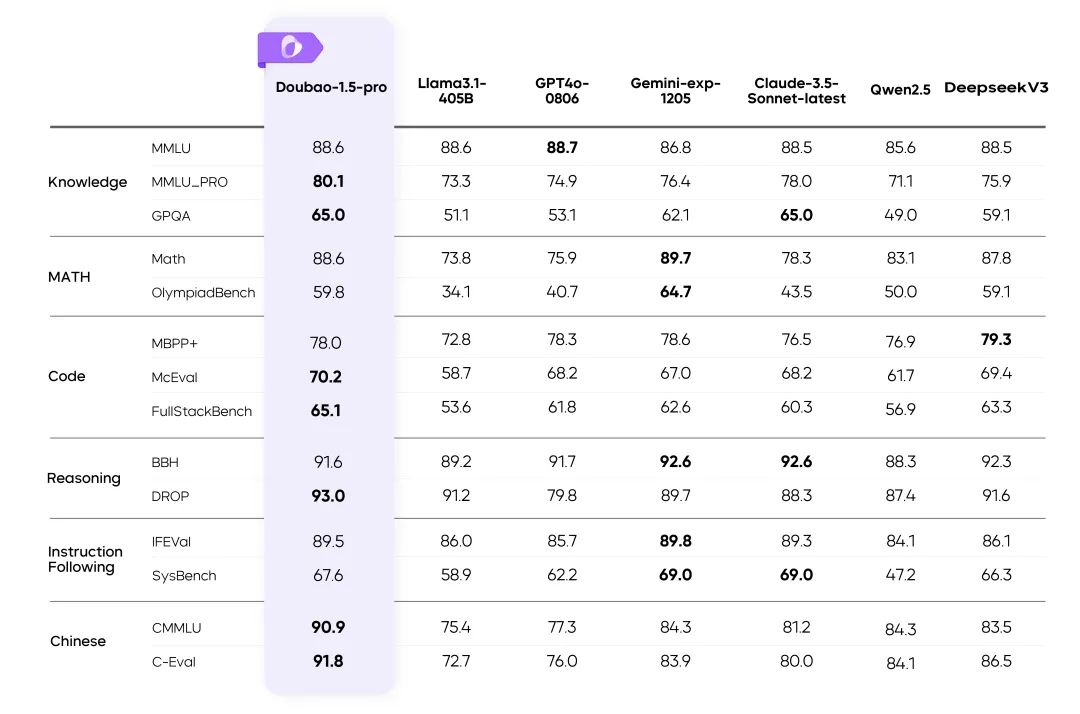

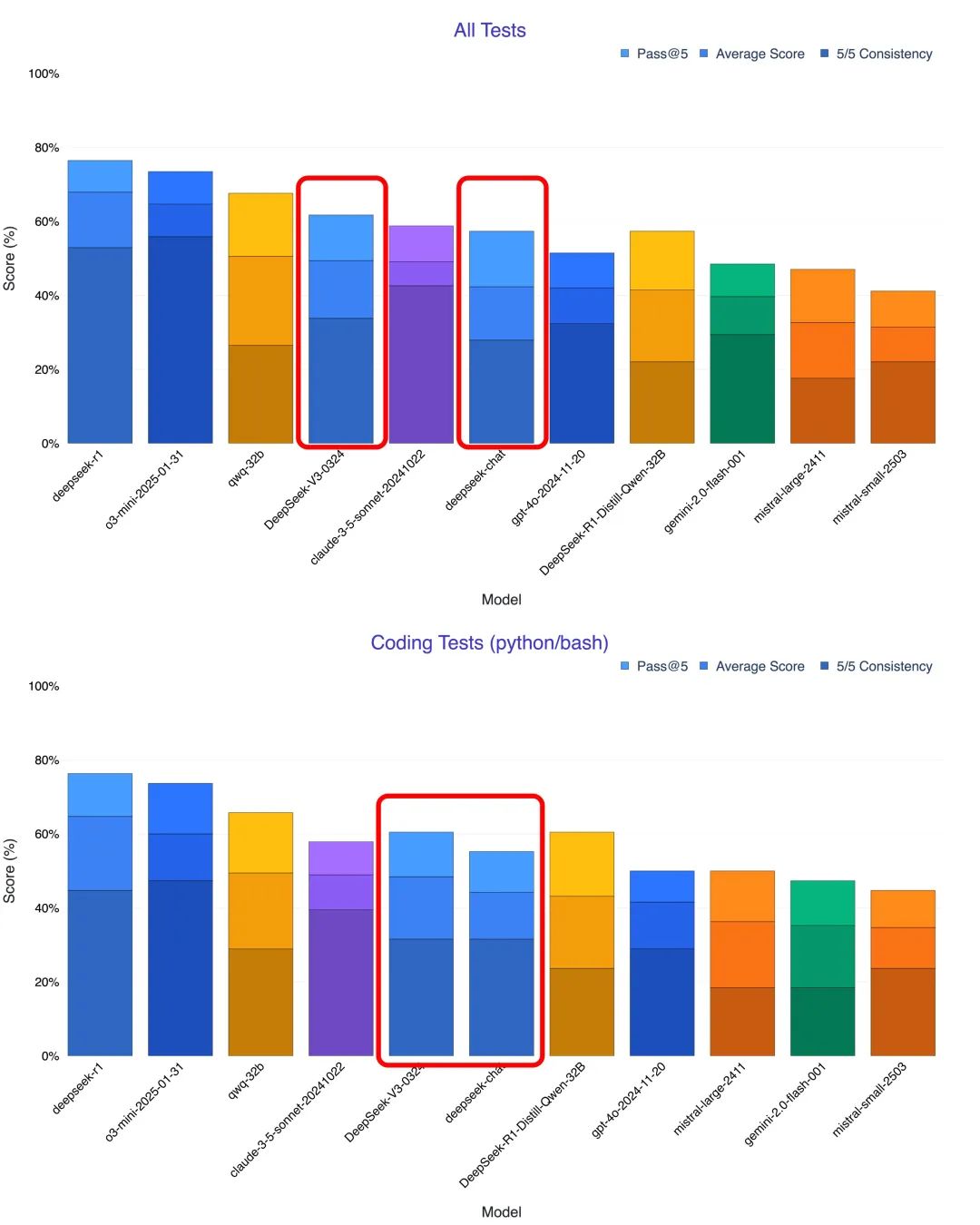

代码能力突飞猛进,直逼闭源标杆。用户和测试者指出,DeepSeek-V3-0324在代码生成和理解能力上显著提升,甚至超越Claude 3.5和3.7 Sonnet。@KuittinenPetri博主认为,DeepSeek-V3-0324可轻松免费创建HTML5, CSS和前端代码,对Anthropic和OpenAI构成挑战。

多场景实测展现强大编程潜力。DeepSeek-V3-0324在文字转可视化网页、3D动画、UI组件设计、物理世界模拟和AI游戏生成等方面表现出色,尤其在生成HTML5+CSS+前端代码方面,比R1更胜一筹。

DeepSeek-V3-0324采用混合专家模型架构,参数规模6850亿,采用辅助损失免费的负载均衡策略,提高模型性能和训练效率,并采用节点受限的路由机制,减少通信成本。

DeepSeek-V3-0324延续宽松的MIT开源协议,API价格极具竞争力,比OpenAI o1-pro便宜至少50倍,比Claude 3.7便宜至少十分之一。

DeepSeek-V3-0324在多个关键方面展现改进,推理能力提升,前端Web开发能力增强,中文写作能力提升,中文搜索能力提升,Function Calling功能改进。

DeepSeek-V3-0324的低调更新,在科技界引起了广泛关注。它不仅展现出强大的编程能力,更预示着AI编程普惠时代的到来。随着更多第三方平台接入DeepSeek新版V3,AI编程能力将惠及更多开发者和用户,推动AI生态发展。

暂无评论