Google的DeepMind团队近期推出了一项名为“可微缓存增强”的突破性技术,旨在提升大型语言模型(LLMs)的推理效能,同时避免大幅提升计算成本。在自然语言处理、数学运算和逻辑推理等众多领域,LLMs已成为解决复杂问题的核心工具。随着技术的不断发展,研究人员正努力提高这些模型的数据处理能力,以生成更精确、更贴合上下文的回答。然而,随着模型复杂度的提升,如何在有限的计算资源下保持高效运行成为一大挑战。

一个显著的问题是,现有的大型语言模型往往难以在不同任务间进行有效的推理,或执行超出其预训练架构的计算。为了提升模型性能,研究人员通常会在任务处理过程中生成中间步骤,但这往往会导致延迟增加和计算效率降低。这一限制严重影响了模型执行复杂推理任务的能力,尤其是那些需要长距离依赖关系或高精度预测的任务。

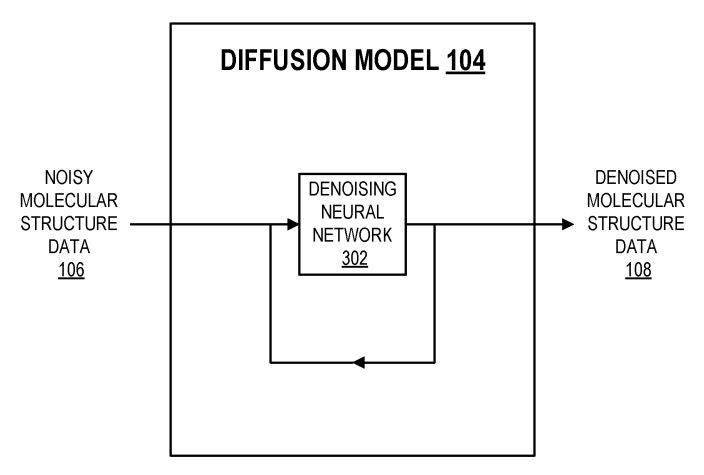

“可微缓存增强”技术通过引入一个训练有素的协处理器,以潜在嵌入的方式强化LLMs的键值(kv)缓存,从而丰富模型的内部记忆。这一方法的关键在于,保持基础LLMs不变,同时异步训练协处理器。通过这种方式,研究团队成功地在不牺牲计算效率的前提下,显著提升了模型性能。

整个处理流程分为三个关键阶段:首先,冻结的LLMs从输入序列中生成kv缓存;接着,协处理器利用可训练软令牌处理这些kv缓存,生成潜在嵌入;最后,增强的kv缓存被反馈回LLMs,以生成更丰富的输出。这一创新方法不仅简化了模型处理复杂任务的过程,还提高了其准确性和效率。

在Gemma-2 2B模型上的测试结果显示,“可微缓存增强”技术在多个基准测试中均取得了显著成果。例如,在GSM8K数据集上,准确率提高了10.05%;在MMLU基准测试中,性能提升了4.70%。该方法还显著降低了模型在多个标记位置的困惑度,进一步证明了其有效性。

DeepMind的这一研究成果为大型语言模型的推理能力增强提供了新的视角和解决方案。通过引入外部协处理器来增强kv缓存,研究团队在保持计算效率的同时,实现了模型性能的显著提升,为LLMs处理更复杂、更具挑战性的任务奠定了坚实基础。

暂无评论