最近,谷歌DeepMind团队推出了一项名为FACTS Grounding的新基准测试,目的是提高大型语言模型(LLMs)的事实准确度,增强用户对模型的信任,并扩大其应用范围。该测试重点在于检测LLMs是否能够依据提供的资料精确回答问题,同时防止出现“幻觉”现象,即编造信息。

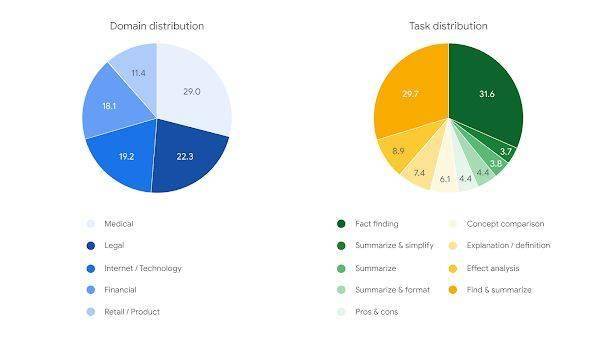

在数据集方面,FACTS Grounding数据集精心准备了1719个案例,覆盖金融、科技、零售、医疗和法律等多个行业。每个案例包括一篇文档、一条要求LLM根据文档执行的指令以及相应的提示词。文档长度不一,最长可达20000字,确保了数据集的丰富性和多样性。用户请求的类型包括摘要、问答生成和改写等,但不包含需要创造力、数学或复杂推理的任务。

数据集巧妙地分为860个“公共”案例和859个“私有”案例。目前,公共数据集已对外开放,供研究人员和开发者进行评估。私有数据集则用于排行榜评分,这一设计旨在避免基准测试污染和排行榜作弊,确保评估的公正性和准确性。

在评估方法上,FACTS Grounding基准测试采用了Gemini 1.5 Pro、GPT-4o和Claude 3.5 Sonnet这三款先进模型作为评委,共同评判答案的完整性、事实准确性和文档支持度。这种多模型评估体系能更全面、客观地评价LLMs在事实准确性方面的表现。

评估流程分为两个阶段。首先,评委们会判断回应是否满足资格,即是否充分满足了用户请求。然后,他们会评估回应的事实准确性,即是否完全依据提供的文档,未产生“幻觉”。最终,根据模型在所有案例上的平均得分,计算出每个LLM在FACTS Grounding基准测试中的表现。

特别值得一提的是,在FACTS Grounding基准测试中,谷歌的Gemini模型在事实准确的文本生成方面表现卓越,获得了最高分。这一成绩不仅展示了Gemini模型在事实准确性方面的优异表现,也证明了FACTS Grounding基准测试的有效性和可靠性。

暂无评论