近期,VLM-R1项目的成功面世,为该领域带来了新的希望。这一项目是DeepSeek团队将R1方法成功迁移至视觉语言模型的结果,标志着AI对视觉内容的理解将迈入一个全新的阶段。

VLM-R1的创意来源于去年DeepSeek开源的R1方法,该方法运用了GRPO(Generative Reward Processing Optimization)强化学习技术,在纯文本处理领域取得了显著成效。如今,VLM-R1团队成功地将这一技术应用于视觉语言模型,为多模态AI研究开辟了新的路径。

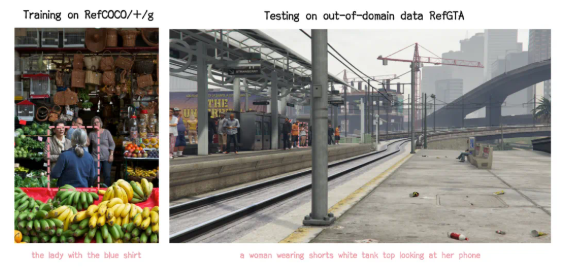

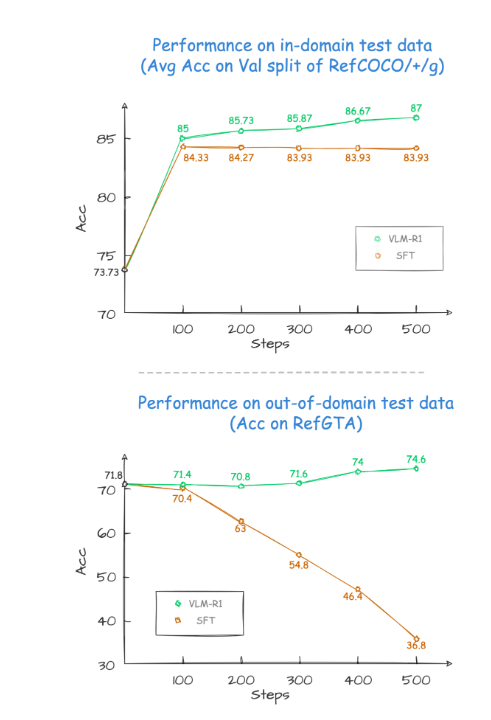

在项目验证结果中,VLM-R1的表现令人瞩目。首先,R1方法在复杂场景下表现出极高的稳定性,这对于实际应用至关重要。其次,该模型在泛化能力方面表现出色。在对比实验中,传统的SFT(Supervised Fine-Tuning)模型在领域外的测试数据上,随着训练步数的增加,性能逐渐下降,而R1模型则能在训练过程中持续提升。这表明,R1方法使模型真正掌握了理解视觉内容的能力,而不仅仅是依赖记忆。

此外,VLM-R1项目的上手难度极低,团队为开发者提供了完整的训练和评估流程,让开发者能够快速上手。在一次实际案例中,模型被要求从一张丰盛美食图片中找出蛋白质含量最高的食物,不仅回答准确,还在图片中精准框选出蛋白质含量最高的鸡蛋饼,展示了其出色的视觉理解和推理能力。

VLM-R1的成功推出不仅证明了R1方法的通用性,也为多模态模型的训练提供了新的思路,预示着一种全新的视觉语言模型训练潮流的到来。更令人振奋的是,该项目完全开源,感兴趣的开发者可以在GitHub上找到相关资料。

总之,VLM-R1的问世为视觉语言模型的研究注入了新的活力,我们期待更多开发者加入其中,共同推动多模态AI技术的持续进步。

暂无评论