“MoE”技术结合“前所未有的大规模生产环境下的 Lightning Attention”以及“从框架到CUDA层面的软件和工程重构”,将带来怎样的成果?

答案是,一个能够与顶级模型比肩、上下文长度提升至400万token级别的新模型。

(adsbygoogle=window.adsbygoogle||[]).push({});

1月15日,大模型公司MiniMax正式推出了这款备受期待的新模型系列:MiniMax-01,它包括基础语言大模型MiniMax-Text-01以及集成了轻量级ViT模型的视觉多模态大模型MiniMax-VL-01。

MiniMax-01是一个总参数达到4560亿的MoE(混合专家)模型,由32个Experts组成。在多个主流评测集上,其综合能力与GPT-4o和Claude 3.5 sonnet相当,同时上下文长度是顶尖模型的20-32倍,且随着输入长度增加,性能衰减最慢,实现真正的400万token上下文。

- 基础语言大模型MiniMax-Text-01,视觉多模态大模型MiniMax-VL-01

- 全新的Lightning Attention架构,平方变线性,大幅降低推理成本

- 重磅开源,文本模型参数高达4560亿,32个专家

- 超长400万字长上下文,性能追平顶尖海外模型

- 模型、代码、技术报告全部发布,诚意满满

目前网页体验和API已上线,可在线体验和商用,详情见文章最后。

新技术:Lightning attention

这次模型最令人惊喜的是全新的线性注意力架构。

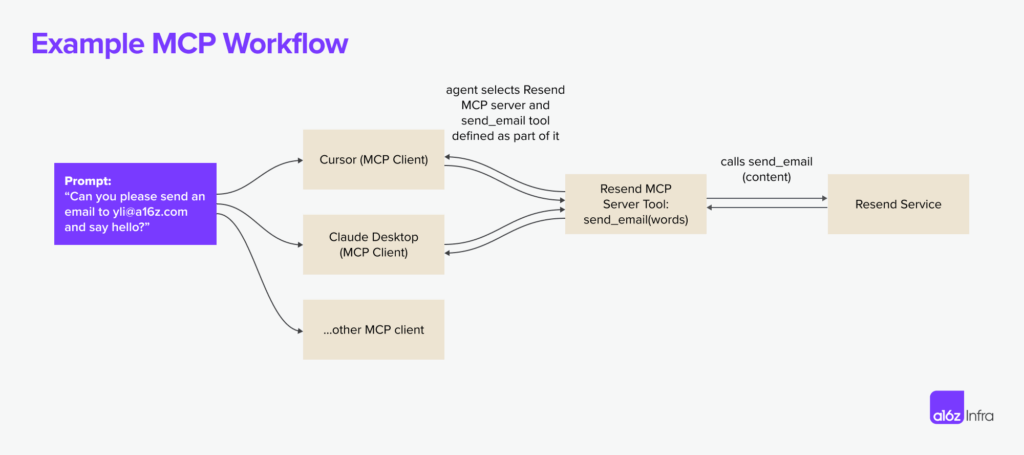

众所周知,在实际的AI应用中,长文本至关重要,无论是角色聊天、AI Coding还是Agent完成任务,都离不开长文本。

虽然大模型一直在降价,但使用时上下文越长,速度越慢,价格越高。

这个问题的根源在于Transformer架构具有二次计算复杂度。随着上下文增加,推理的算力消耗呈指数上升。

而这次MiniMax的新模型采用了Lightning attention机制,一种线性注意力机制,能够大幅降低长文本的计算量和推理时间。

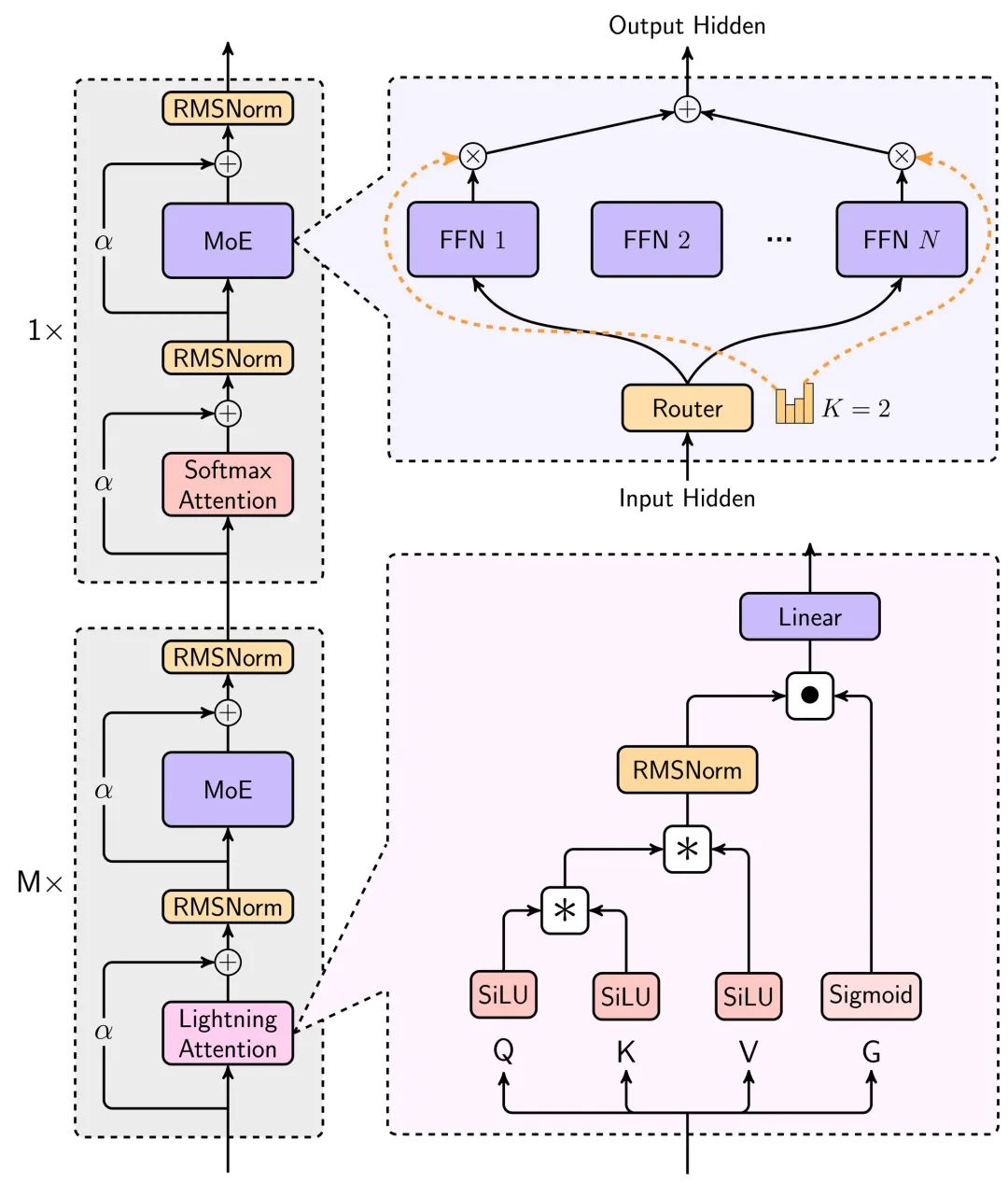

在技术报告中,可以看到这次模型的主要架构图。

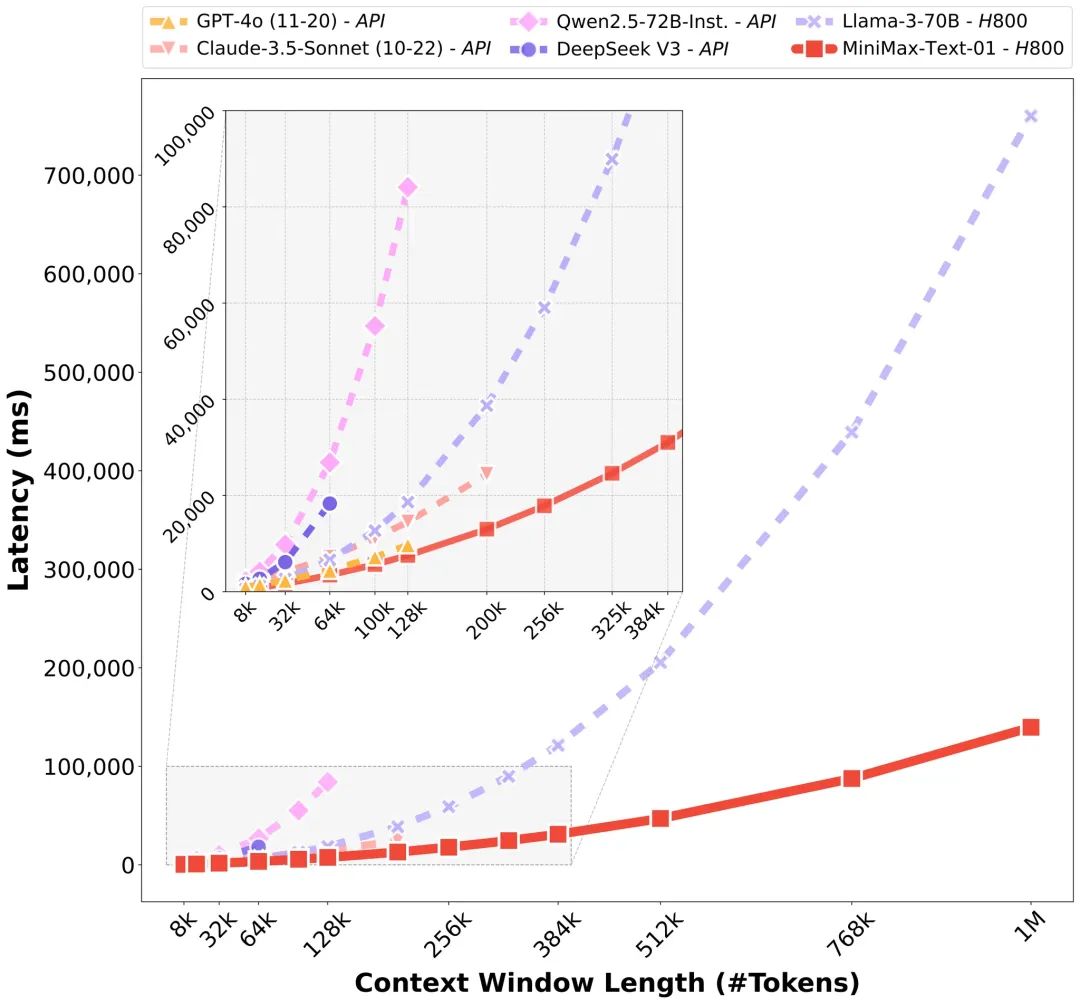

这个架构对模型推理资源消耗的降幅非常巨大,通过下面的长文本推理时间对比图可以看出,在上下文持续上升时,使用了线性注意力让推理时间接近线性地缓慢增加,而非指数级别增加。

更详细的介绍可参见文末的技术报告。

计算量降低了,价格下来了,性能也不能损失,长文本才算真正可用。

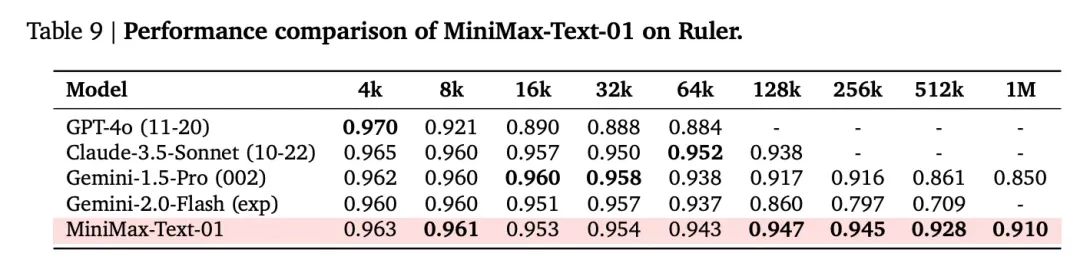

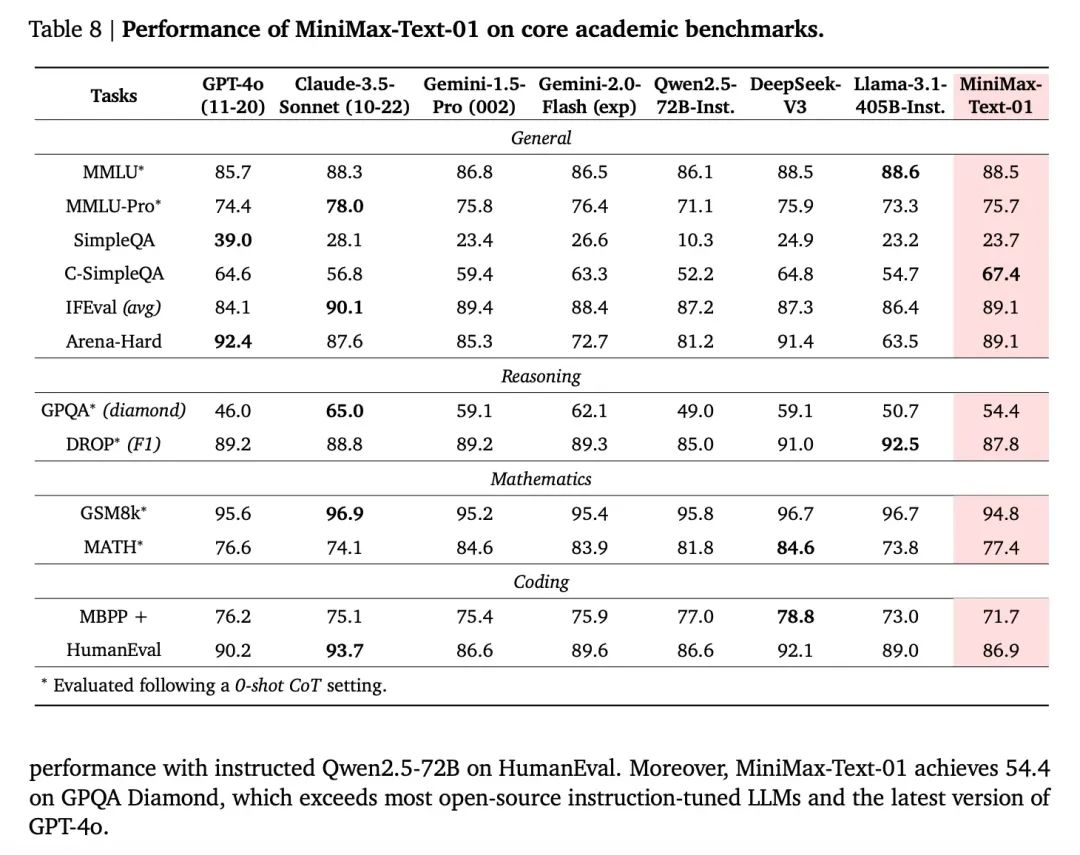

下文是Text-1在超长文本评测集的性能表现,在512K的长度以上的区间,性能竟然超过了Gemini 2.0 Flash。

技术报告中的另一个非常有趣的点是,随着上下文的提升,模型的In-Context Learning能力逐渐增强,这对AI写作以及需要长记忆的任务都有巨大的帮助。

总的来说,Lightning attention机制的应用,让大模型的长文本可用性大幅提升,价格也有机会再下降一个量级,未来非常值得期待。

模型性能,追平一线

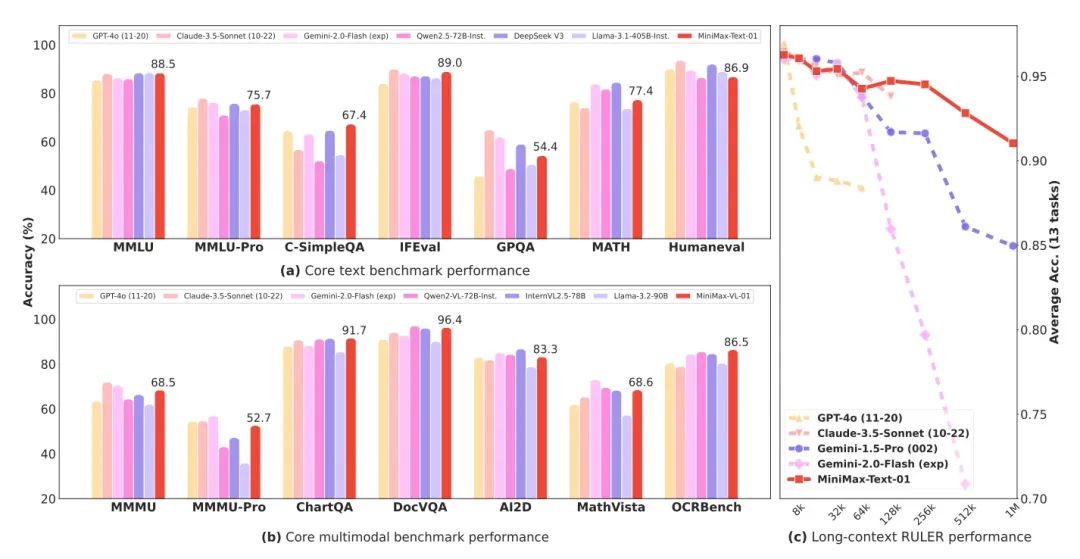

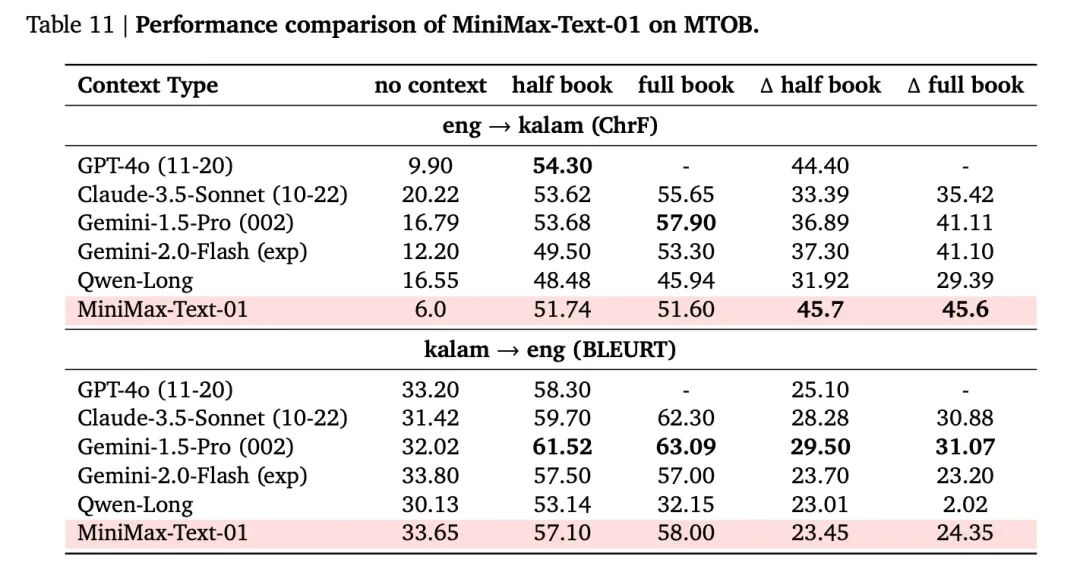

模型性能指标方面,作为开源模型,在许多指标上已经追上了最佳海外闭源模型。

并且由于模型有海螺平台反馈进行优化迭代,用户真实场景的使用体验也有保证。

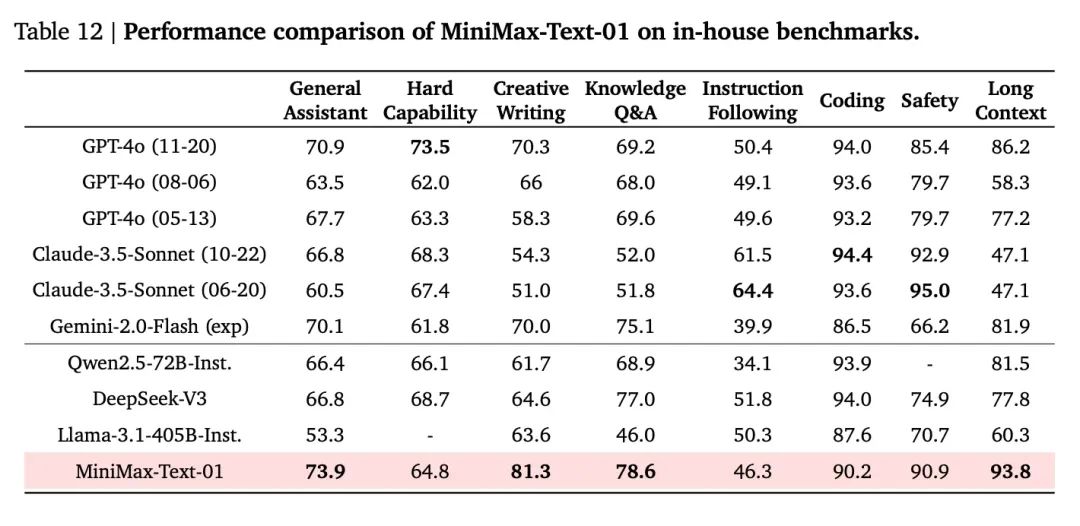

官方利用真实的用户使用场景构建了一个测试集,可以看出在真实场景的表现也很亮眼,特别突出的场景是三个:创意写作、知识问答、长文本。

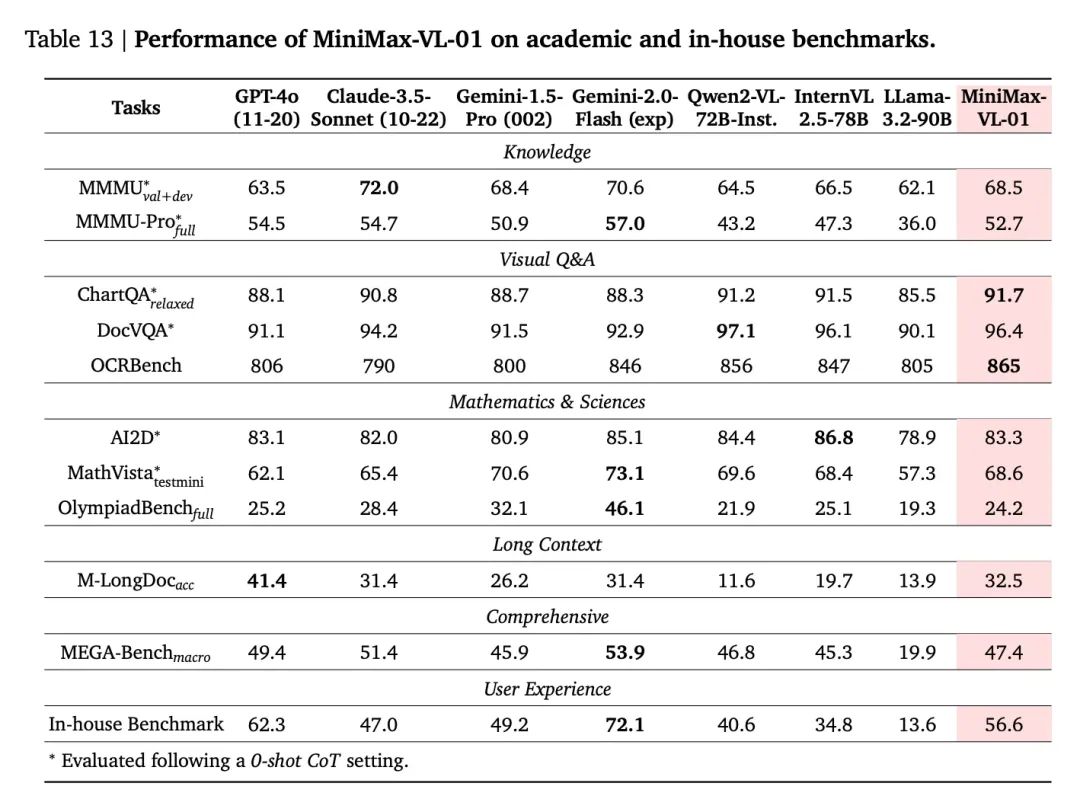

另外,视觉理解模型MiniMax-VL-01表现,基本在每个指标上都追平或超过了海外顶级模型,特别是实用的OCR和图表场景。

下个Transformer时刻

当模型的代际迭代不再迅猛,上下文长度和逻辑推理成为两个最重点方向。

在上下文方面,此前Gemini一度是最长的那个。而且,DeepMind的CEO Demsi Hassabis也曾透露,在Google内部,Gemini模型已经在实验中实现过1000万token的长度,并且相信最终会“抵达无限长度”,但阻止Gemini现在就这么做的,是它对应的成本。在最近的一个访谈里他表示,Deepmind目前已经有新的方法来解决这个成本难题。

所以,谁能先把上下文长度提高,同时把成本打下来,谁可能就会占得先机。从MiniMax-01展示的效果来看,它的效率确实获得了质的提升。

在这篇详尽的技术报告里,从一个数据可以看出对于硬件的使用效率——在推理上,MiniMax在H20 GPU上的MFU达到了75%。这是一个相当高的数字。

MFU(Machine FLOPs Utilization,机器浮点利用率)指的是模型在运行过程中对硬件计算能力(FLOPs,即每秒浮点运算次数)的实际利用率。简单来说,MFU描述了一个模型是否充分发挥了硬件性能。高利用率必将带来成本上的优势。

MiniMax 01无疑是近来死气沉沉的“撞墙论”中,难得令人惊喜的模型之一。另一个最近引发广泛讨论的是DeepSeek V3。如上面所说,今天两个重要的方向,一个在推理,一个在更长上下文,Deepseek V3和MiniMax-01各自代表了其中一个。

有意思的是,从技术路线上,某种程度上两者都是在对奠定今天繁荣基础的Transformer里最核心的注意力机制做优化,而且是大胆的重构,软硬件一体的重构。DeepSeek V3被形容把Nvidia的卡榨干了,而MiniMax能够实现如此高的推理MFU,很关键的也是他们直接对训练框架和硬件做优化。

根据MiniMax的报告,他们直接自己从零开始一步步深度开发了一个适合线性注意力的CUDA内核,并为此开发了各种配套的框架,来优化GPU资源的利用效率。两家公司都通过更紧密的软硬结合能力实现了目标。

另一个有意思的观察是,这两家出彩的公司,都是在ChatGPT出现之前就已经投入到大模型技术研发里去的公司,这两个模型惊艳之处也都不在于过去习惯看到的“追赶GPT4”的模式,而是根据自己对技术演进的判断,做出的重投入、甚至有些赌注意味的创新,在一系列持续的扎实工作后,交出的答卷。

而且这答卷也都不只是对自己的,它们都在试图证明某些曾停留在实验室的概念,在大规模部署到实际场景里后也可以有它承诺的效果,并借此让更多人继续优化下去。

这不免让人联想到Transformer出现的时候。

当初Attention机制也已经在实验室走红,但争议依然不断,是相信它的潜力的Google真正堆上了算力和资源,把它从理论实验,做成了大规模部署实现出来的真东西。接下来才有了人们蜂拥而上,沿着被证明的路线走到今天的繁荣。

当时的Transformer把注意力机制堆了更多层,用上了更多的算力,今天的MiniMax-01则在尝试彻底改造旧的注意力机制,一切都有些似曾相识。甚至当时Google的研究员为了强调注意力机制而起的那个著名的论文标题“Attention is all you need”也非常适合被MiniMax借鉴:线性注意力is all you need ——

“模型目前仍有1/8 保留了普通softmax 注意力。我们正在研究更有效的架构,最终完全去掉softmax 注意力,从而有可能在不出现计算过载的前提下实现无限制上下文窗口。”

模型价格

输入:1元/百万token

输出:8元/百万token

基本上闭眼用。

模型资源

代码:https://github.com/MiniMax-AI/MiniMax-01

模型:https://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

技术报告:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

网页端:https://hailuo.ai

API: https://www.minimaxi.com/

暂无评论