随着企业广泛采用大型语言模型(LLMs),如何提高模型的知识精确度并减少幻觉问题,已经成为一个关键的挑战。Meta AI的研究团队在最新论文中提出了“可扩展记忆层”,这或许为解决这一难题提供了新的思路。

可扩展记忆层的核心理念是在不增加推理计算资源的前提下,向LLMs中增加更多参数,以此增强其学习能力。这种架构特别适用于那些需要存储大量事实知识但希望保持推理速度的应用场景。

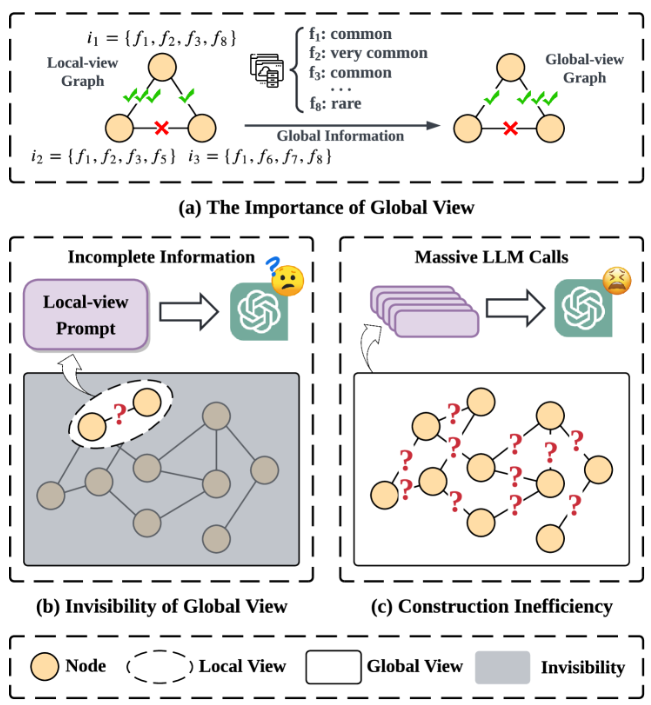

传统的语言模型采用“密集层”来编码大量信息。在密集层中,所有参数在推理时几乎同时被激活,能够学习复杂的函数,但这需要额外的计算和能源。对于简单的事实知识,使用具有关联记忆架构的简单层则更为高效和易于理解,这正是记忆层的作用。记忆层通过简单的稀疏激活和键值查找机制来编码和检索知识。尽管稀疏层在内存占用上高于密集层,但由于其仅使用少量参数,因此提高了计算效率。

尽管记忆层已经存在多年,但在现代深度学习架构中应用较少,主要原因是它们并未针对当前的硬件加速器进行优化。目前前沿的LLMs通常采用某种形式的“专家混合”架构,这与记忆层有相似之处。专家混合模型由多个专门化的小型专家组件构成,通过路由机制在推理时激活特定的专家。

为了克服记忆层在计算上轻便但内存占用大的挑战,Meta的研究人员提出了多项改进措施,使其在大规模应用中成为可能。他们为记忆层实现了并行化,能够在多个GPU上存储数百万个键值对,同时不会减慢模型的运行速度。此外,他们还开发了特定的CUDA内核来处理高内存带宽操作,并实现了参数共享机制,允许多个记忆层共享一组内存参数。

通过对Llama模型的修改,研究人员将一个或多个密集层替换为共享记忆层,对记忆增强模型进行了测试。他们的研究发现,记忆模型在多个任务中表现出色,尤其是在需要事实知识的任务上,性能明显优于密集基线,甚至能与使用2到4倍计算资源的模型相媲美。

论文入口:https://arxiv.org/abs/2412.09764

划重点:

🧠 可扩展记忆层能够在不增加计算资源的情况下提升语言模型的学习能力。

💡 研究发现,记忆层在多个任务上表现优异,尤其是在需要事实知识的情况下。

🚀 Meta的研究人员呼吁将记忆层整合进下一代AI架构中,以减少遗忘和幻觉现象。

暂无评论