近年来,大型语言模型(LLMs)的迅猛发展,使得自然语言处理领域迎来了翻天覆地的变革。这些技术已广泛应用于代码助手、搜索引擎和个人AI助手等领域,展现出惊人的能力。然而,传统的“下一个token预测”模式在处理复杂推理和长期任务时,模型需要经过大量训练才能掌握深层次的概念理解,具有一定的局限性。

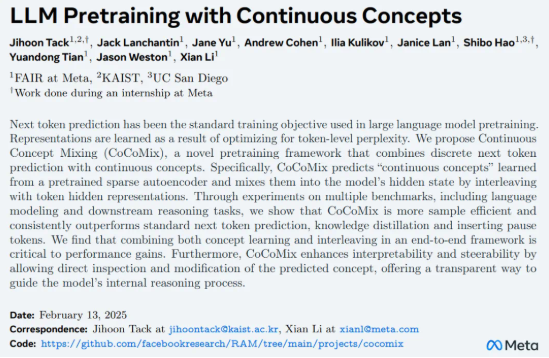

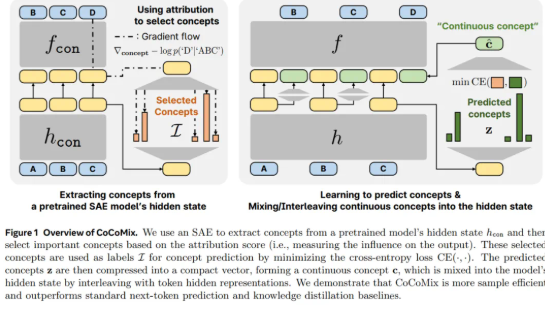

为了解决这一难题,Meta等机构的研究者提出了一种名为“连续概念混合”(CoCoMix)的创新预训练框架。该方法在保留下一个token预测优势的同时,引入了通过稀疏自编码器(SAE)学习到的连续概念,从而提高了模型的学习效率和性能。具体而言,CoCoMix通过选择最具影响力的概念,将其与token的隐藏表示交错结合,创造了一种全新的学习机制。

在实际应用中,研究者对CoCoMix进行了广泛评估,涵盖了多个语言建模基准和不同规模的模型。结果显示,CoCoMix在训练token数量减少21.5%的情况下,仍能保持与传统token预测相当的性能。这一发现令人振奋,尤其在从小模型中提取概念用于指导大模型的弱到强监督场景中,CoCoMix表现出了显著的改进。

此外,CoCoMix的可解释性和可操控性也是其重要特征之一。研究者通过观察模型在预测过程中的表现,可以清楚地了解模型重点关注哪些概念,并通过调整概念的大小来操控模型的输出结果。这一特性为模型分析和优化提供了新的视角。

总体而言,CoCoMix不仅是对现有语言模型训练方式的一次创新,也是Meta在引领大模型发展趋势方面的一次重要尝试。随着技术的不断进步,这一框架有望成为未来自然语言处理领域的关键工具,推动AI向更智能的方向发展。

项目地址:[https://github.com/facebookresearch/RAM/tree/main/projects/cocomix](https://github.com/facebookresearch/RAM/tree/main/projects/cocomix)

近年来,大型语言模型(LLMs)的迅猛发展,使得自然语言处理领域迎来了翻天覆地的变革。这些技术已广泛应用于代码助手、搜索引擎和个人AI助手等领域,展现出惊人的能力。然而,传统的“下一个token预测”模式在处理复杂推理和长期任务时,模型需要经过大量训练才能掌握深层次的概念理解,具有一定的局限性。

为了解决这一难题,Meta等机构的研究者提出了一种名为“连续概念混合”(CoCoMix)的创新预训练框架。该方法在保留下一个token预测优势的同时,引入了通过稀疏自编码器(SAE)学习到的连续概念,从而提高了模型的学习效率和性能。具体而言,CoCoMix通过选择最具影响力的概念,将其与token的隐藏表示交错结合,创造了一种全新的学习机制。

在实际应用中,研究者对CoCoMix进行了广泛评估,涵盖了多个语言建模基准和不同规模的模型。结果显示,CoCoMix在训练token数量减少21.5%的情况下,仍能保持与传统token预测相当的性能。这一发现令人振奋,尤其在从小模型中提取概念用于指导大模型的弱到强监督场景中,CoCoMix表现出了显著的改进。

此外,CoCoMix的可解释性和可操控性也是其重要特征之一。研究者通过观察模型在预测过程中的表现,可以清楚地了解模型重点关注哪些概念,并通过调整概念的大小来操控模型的输出结果。这一特性为模型分析和优化提供了新的视角。

总体而言,CoCoMix不仅是对现有语言模型训练方式的一次创新,也是Meta在引领大模型发展趋势方面的一次重要尝试。随着技术的不断进步,这一框架有望成为未来自然语言处理领域的关键工具,推动AI向更智能的方向发展。

项目地址:[https://github.com/facebookresearch/RAM/tree/main/projects/cocomix](https://github.com/facebookresearch/RAM/tree/main/projects/cocomix)

暂无评论