近年来,自然语言处理(NLP)领域因大型语言模型(LLMs)的显著进展而焕发生机,这些模型广泛应用于文本生成、摘要和问答等多个场景。然而,LLMs采用的逐字预测的token级处理方法,在理解上下文方面存在难题,常常导致输出结果不一致。此外,将LLMs扩展到多语言和多模态应用时,所需计算成本和数据量也相对较高。为此,Meta AI提出了一种创新方法——大概念模型(LCMs)。

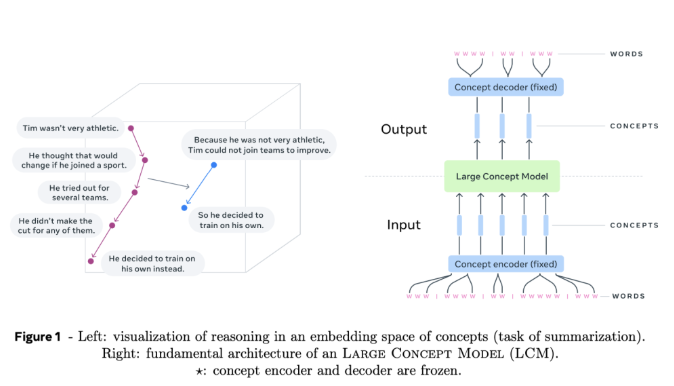

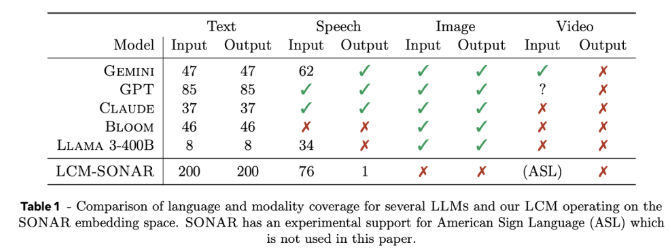

大概念模型(LCMs)标志着对传统LLM架构的重大变革。它们引入了两项创新技术:首先,LCMs采用高维嵌入空间进行建模,而非依赖离散的tokens。这一嵌入空间被称为SONAR,旨在支持200多种语言和多种模态,包括文本和语音,实现了语言和模态无关的处理能力。其次,LCMs设计允许在语义层面上无缝切换,从而在不同语言和模态之间实现了强大的零样本泛化能力。

LCMs的核心包含概念编码器和解码器,这些组件将输入句子映射到SONAR的嵌入空间,并将嵌入解码回自然语言或其他模态。这种冻结设计确保了组件的模块化,便于在不重新训练整个模型的情况下添加新语言或模态。

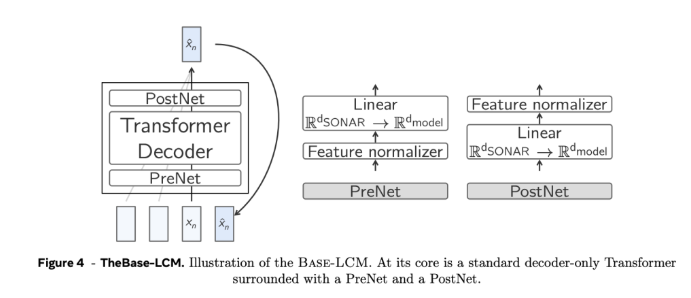

在技术细节上,LCMs采用了层次化架构,模拟人类推理过程,提高了处理长篇内容的一致性,同时实现了在不影响整体上下文的情况下进行局部编辑。通过采用扩散模型,LCMs在生成过程中表现出色,这些模型基于前面的嵌入预测下一个SONAR嵌入。实验中,单塔和双塔两种架构都被采用,其中双塔架构在上下文编码和去噪方面分离处理,提升了效率。

实验结果表明,基于扩散的双塔LCM在多项任务中展现了竞争力,尤其在多语言摘要任务中,LCMs在零样本情况下的表现优于基准模型,证明了其强大的适应能力。同时,LCMs在处理短序列时也展现了高效性和准确性,相关度量指标的显著提升验证了这一点。

Meta AI的大概念模型为传统token级语言模型提供了一种充满前景的替代方案,通过高维概念嵌入和模态无关的处理,克服了现有方法的某些关键局限。随着对这一架构的深入研究,LCMs有望重新定义语言模型的能力,为AI驱动的沟通提供更具可扩展性和适应性的解决方案。

项目入口:https://github.com/facebookresearch/large_concept_model

划重点:

🌟 LCMs在高维嵌入空间中进行建模,支持200多种语言和多模态。

💡 LCMs采用层次化架构,增强长篇内容的一致性和局部编辑能力。

🚀 研究成果显示,LCMs在多语言摘要等任务中表现卓越,具备出色的零样本泛化能力。

暂无评论