近年来,大语言模型(LLM)的广泛应用使其在复杂推理和问题解决中扮演重要角色。特别是,受OpenAI的o1架构启发的o1-like模型,凭借其独特的人类思维和逐步推理能力脱颖而出。但这类模型也存在一个显著问题,即“过度思考”。

所谓过度思考,是指模型在处理简单问题时,会消耗过多计算资源,甚至在推理过程中重复不必要的步骤。例如,在解决“2+3”这样的简单算术题时,o1-like模型可能会生成过于详细的推理,使用的token数量远超传统LLM,这不仅增加了计算成本,也限制了其在资源受限场景下的应用。

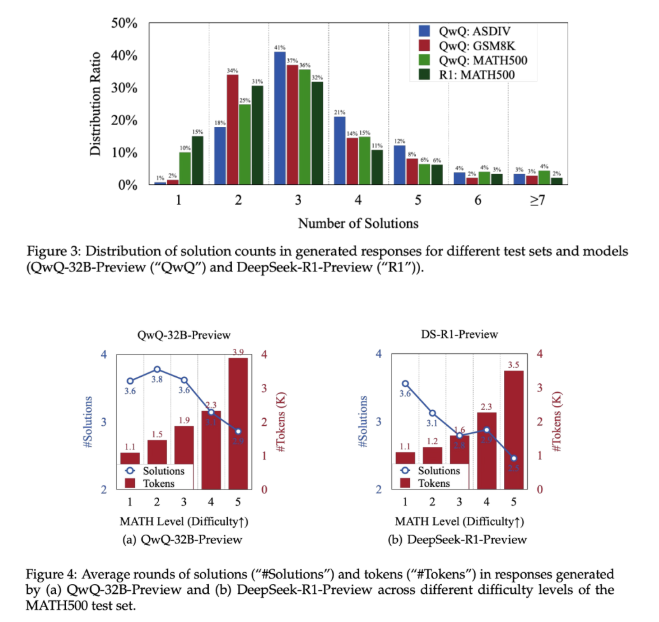

为解决这一问题,腾讯AI实验室与上海交通大学合作开展了一项新研究,深入探讨o1-like模型中的过度思考现象,并优化计算资源。研究在GSM8K、MATH500和AIME等数据集上进行了实验,发现这些模型在简单问题上倾向于生成冗余解答。为此,研究人员引入了结果效率和过程效率两个评估指标,全面评估模型在推理时的资源利用情况。

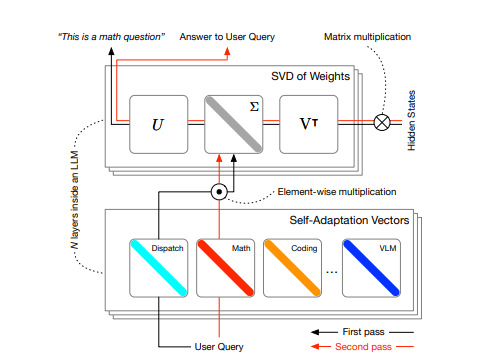

为解决过度思考问题,研究者提出了一种自我训练方法,将效率指标直接整合到模型训练过程中。此方法强调早期准确响应的重要性,减少冗余推理,同时保留模型的反思能力。研究中,第一正确解(FCS)和FCS+反思策略成为核心方法。以QwQ-32B-Preview模型为例,在MATH500数据集上的token使用量减少了48.6%。这些方法不仅节省了计算,还提高了推理的可解释性,使其能在计算资源有限的环境下部署。

实验结果显示,以效率为中心的策略显著降低了token使用量,同时保持或提高了简单任务的准确性。例如,在MATH500数据集中,FCS+反思策略使结果效率从52.3%提升至75.8%。更高的过程效率也表明推理步骤中的冗余性减少。在更具挑战性的数据集如GPQA和AIME中,优化后的模型依然保持了强大性能,同时减少了计算需求。研究结果表明,针对性训练策略能有效解决低效问题,同时在多种任务中保留模型的能力。

腾讯AI实验室与上海交通大学的这项研究强调了o1-like模型中的过度思考问题,并提出了高效利用资源的解决方案。这些新指标和训练方法的提出,对于提升先进推理模型的可扩展性和应用性具有重要意义。在人工智能系统不断演进的过程中,确保计算资源的高效使用将成为关键关注点,从而使这些技术得到更广泛的应用和可持续的使用。

项目入口:https://arxiv.org/abs/2412.21187

划重点:

🔍 研究揭示o1-like模型在简单问题上存在“过度思考”现象,导致不必要的计算资源浪费。

⚙️ 通过引入结果效率和过程效率指标,研究者优化模型的计算资源利用,提升推理的有效性。

📉 实验结果显示优化策略显著减少token使用,同时保持或提高模型在简单任务上的准确性。

暂无评论