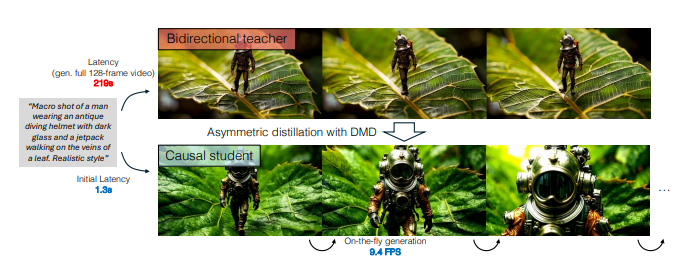

近期,DeepBeepMeep团队在GitHub上推出了Wan2.1GP,这是一款专为低端GPU用户优化的视频生成模型。该模型基于阿里巴巴的Wan2.1技术,旨在为缺乏高性能GPU资源的用户提供高效的视频生成能力。Wan2.1GP的问世标志着视频生成技术的重大突破,尤其在开源领域。

图源说明:该图片由AI生成,版权由Midjourney提供

Wan2.1GP的主要优势在于其卓越的性能和广泛的应用范围。在多项基准测试中,该模型超越了现有的开源模型及一些商业解决方案,展现出强大的竞争力。T2V-1.3B模型仅需8.19GB显存,几乎所有的消费级GPU都能运行它。使用RTX4090显卡,用户能在大约4分钟内生成5秒的480P视频,性能表现可与部分封闭源模型媲美。

Wan2.1GP不仅支持文本生成视频、图像生成视频、视频编辑等多种功能,还是首个能同时生成中英文文本的视频模型。这一特性大大拓宽了用户的应用场景。此外,该模型还内置了强大的视频变分自编码器(VAE),能高效地编码和解码任意长度的1080P视频,确保时间信息的完整性,为视频和图像生成提供了坚实基础。

为了提升用户的使用体验,Wan2.1GP进行了多项优化,包括降低内存和显存需求,支持多种配置以适应不同性能的设备。用户可通过简化的安装流程快速上手。随着版本不断更新,Wan2.1GP还加入了更多实用功能,如Tea Cache支持、Gradio界面改进等,进一步提高了生成速度和使用便捷性。

项目链接:https://github.com/deepbeepmeep/Wan2GP

重点内容:

👍 SOTA性能:Wan2.1GP在多个基准测试中表现出色,超越了现有开源和商业解决方案。

🖥️ 兼容性强:仅需8.19GB显存,支持几乎所有消费级GPU,适合低端用户。

📜 多任务支持:支持文本到视频、图像到视频等多种生成任务,并具备中英文文本生成能力。

暂无评论