在“开源周”活动的第三天,中国领先的人工智能企业DeepSeek正式发布了DeepGEMM——一款支持FP8通用矩阵乘法(GEMM)的开源库。该工具针对密集型和混合专家(MoE)矩阵运算进行优化,为DeepSeek V3和R1模型的训练和推理提供了强大的支持。这一消息通过X平台迅速发布,在技术界引起了广泛的关注。

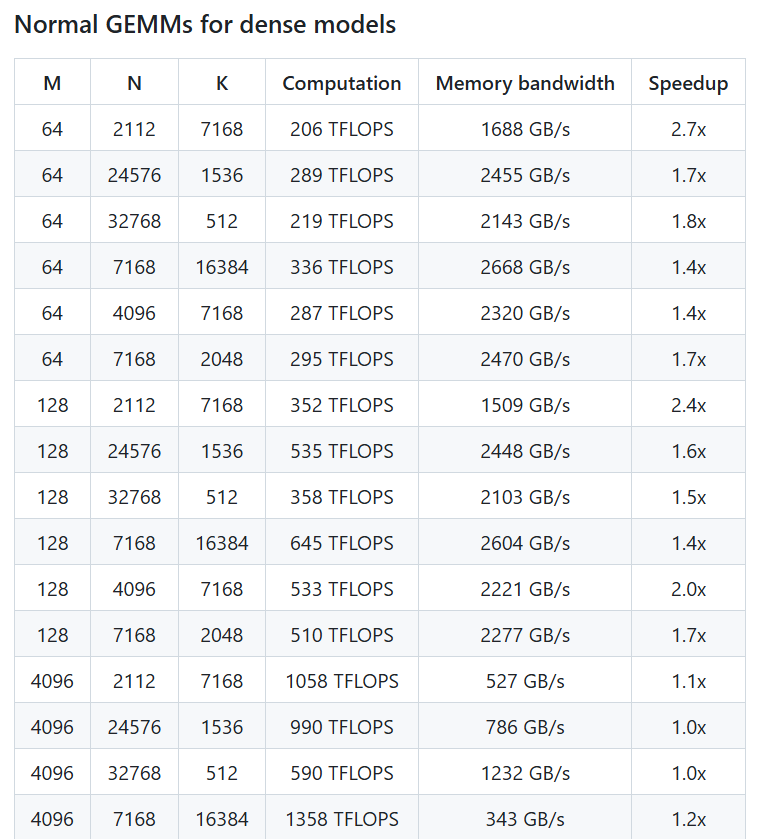

DeepSeek官方账号透露,DeepGEMM在NVIDIA Hopper GPU上能够实现超过1350+ TFLOPS的FP8计算性能。尽管其核心代码仅约300行,但它在多数矩阵尺寸上超越了经过专家调优的内核,展现了卓越的效率和简洁性。该库无需复杂的依赖,采用即时编译(Just-In-Time)技术,支持密集布局和两种MoE布局,设计简洁,便于开发者学习和应用。

在X平台上,用户@TechBitDaily评价说:“DeepGEMM的发布是DeepSeek开源周的亮点之一,其FP8性能和简洁设计给人留下了深刻印象。”另一位用户@AIObserverCN也指出,该库在MoE模型的高效训练方面具有显著优势,有望推动AI社区在Hopper架构上的创新。

DeepGEMM的发布作为开源周的一部分,体现了DeepSeek致力于AI技术透明化和社区协作的承诺。在前两天,DeepSeek已经推出了FlashMLA和DeepEP工具,分别专注于快速语言模型架构和专家并行通信。DeepGEMM的推出,进一步彰显了DeepSeek在AI基础设施构建方面的技术实力。业界人士认为,这款库不仅将提升DeepSeek自家模型的性能,还为全球开发者提供了一个高效、易用的矩阵运算工具,其未来应用前景广阔。用户现在可以通过GitHub获取DeepGEMM,探索其在AI训练与推理中的潜力。

项目地址:https://github.com/deepseek-ai/DeepGEMM

暂无评论