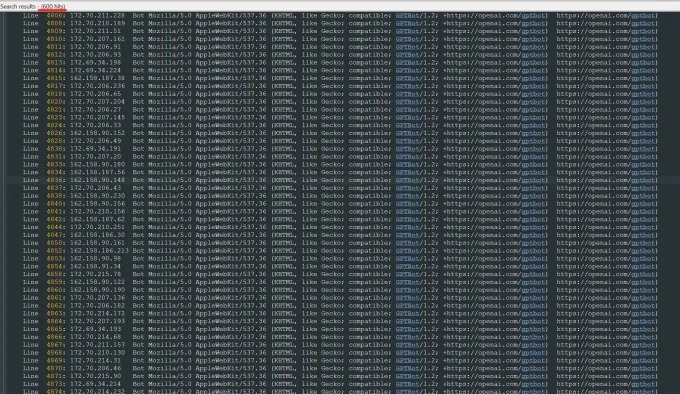

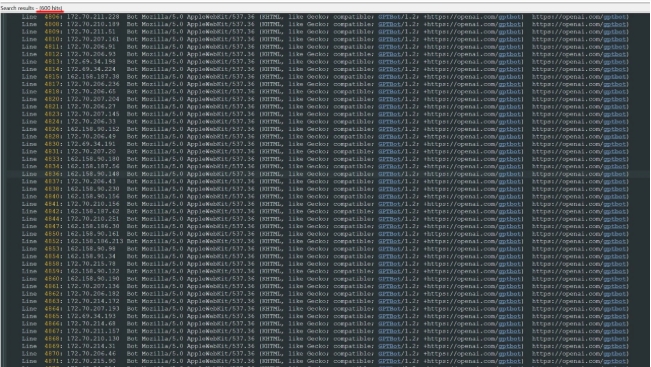

近期,Trilegangers 首席执行官 Oleksandr Tomchuk 接到警报,其公司电子商务网站遭遇瘫痪。调查发现,祸首是来自 OpenAI 的机器人,正不断尝试抓取其整个网站。该网站拥有超过65,000种产品,每种产品页面至少有三张照片。OpenAI 发送了“数万”个服务器请求,试图下载所有内容,包括数十万张照片及其详细描述。

汤姆丘克指出,OpenAI 的爬虫程序正对他们的网站进行破坏,这相当于一次 DDoS 攻击。Trilegangers 公司主要销售3D对象文件和照片,这些内容可应用于3D艺术家、游戏制作者等需要数字再现真实人类特征的用户。

Trilegangers 的网站是其核心业务。该公司用十多年的时间,建立了网络上最大的“人体数字替身”数据库,即从真实人体模型扫描而来的3D图像文件。

汤姆丘克的团队总部位于乌克兰,同时在美国佛罗里达州坦帕市获得许可。其网站的服务条款明确禁止机器人未经许可抓取图像。尽管如此,网站仍需正确配置 robot.txt 文件,明确告知 OpenAI 的机器人 GPTBot 不要打扰网站。

Robot.txt,即机器人排除协议,旨在告知搜索引擎在索引网页时不要抓取哪些内容。OpenAI 在其信息页面上表示,会尊重配置的禁止抓取标签,但警告机器人可能需要24小时才能识别更新的 robot.txt 文件。

汤姆丘克表示,如果网站未正确使用 robot.txt,OpenAI 和其他公司可能会认为可以随意抓取数据。这不是一个可选的系统。

更糟糕的是,Trilegangers 不仅在美国工作时间内被 OpenAI 的机器人强制下线,Tomchuk 预计,由于机器人的所有 CPU 和下载活动,AWS 账单也会大幅增加。

Robot.txt 并非万无一失。AI公司自愿遵守它。去年夏天,另一家AI初创公司 Perplexity 因未遵守 robot.txt 而受到 Wired 调查的关注,这一事件相当著名。

汤姆丘克表示,他找不到联系 OpenAI 并询问的方法。OpenAI 没有回应 TechCrunch 的置评请求。OpenAI 迄今未能提供其长期承诺的选择退出工具。

对于 Triplegangers 来说,这是一个特别棘手的问题。他们从事的业务中,权利问题相当严重,因为他们扫描的是真人。根据欧洲 GDPR 等法律,“他们不能随便在网上拍下任何人的照片然后使用。”

讽刺的是,OpenAI 机器人的贪婪让 Triplegangers 意识到了其自身的脆弱。Tomchuk 表示,如果它更温和地抓取数据,他永远都不会知道。

“这很可怕,因为这些公司似乎利用了一个漏洞来抓取数据,他们说‘如果你用我们的标签更新你的 robot.txt,你可以选择退出’,”汤姆丘克说,但这让企业主有责任了解如何阻止他们。

他希望其他小型在线企业知道,发现人工智能机器人是否正在窃取网站的版权资产的唯一方法就是主动寻找。他当然不是唯一一个被人工智能机器人恐吓的人。其他网站的所有者最近告诉《商业内幕》OpenAI 机器人如何破坏他们的网站并增加他们的 AWS 费用。

到2024年,这一问题将进一步恶化。数字广告公司 DoubleVerify 的最新研究发现,人工智能爬虫和抓取工具导致2024年“一般无效流量”增加86%,即并非来自真实用户的流量。

暂无评论