近期,专注于人工智能研究的Epoch AI公司推出了一款新型的互动模拟器,旨在模拟训练大型语言模型所需的计算资源。通过该模拟器的应用,研究人员们发现,尽管利用2012年的旧款显卡如GTX580来训练GPT-4是可行的,但其成本却是当下现代硬件的十倍之高。

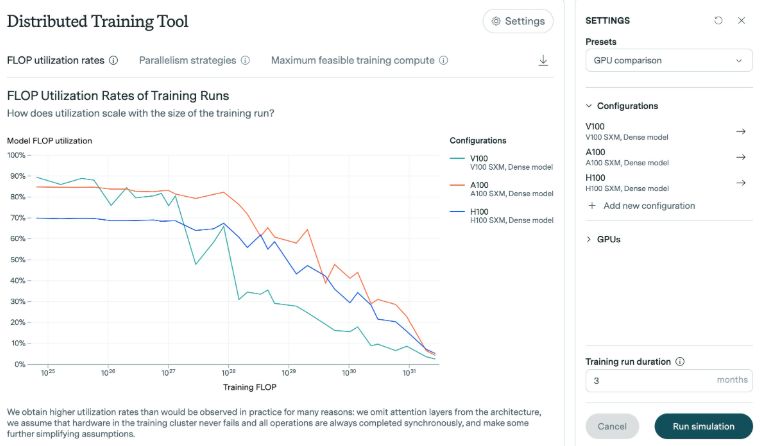

根据Epoch AI的研究,训练GPT-4模型所需的浮点运算次数介于1e25至1e26之间。为了完成这项研究,模拟器对不同显卡的效率进行了分析,特别是它们在应对模型规模扩大时的表现。研究发现,随着模型规模的增加,效率普遍会有所下降。以近期推出的H100显卡为例,它在较长时间内维持了较高的效率,而V100显卡在应对更大规模的训练时,效率的下降更为显著。

在Epoch AI的实验中,被用作测试的GTX580显卡内存仅有3GB。这款显卡曾在2012年成为训练AlexNet模型的主流设备。尽管技术不断进步,研究人员认为,使用这类老旧硬件进行大规模训练虽然可行,但所需投入的资源和成本极为巨大。

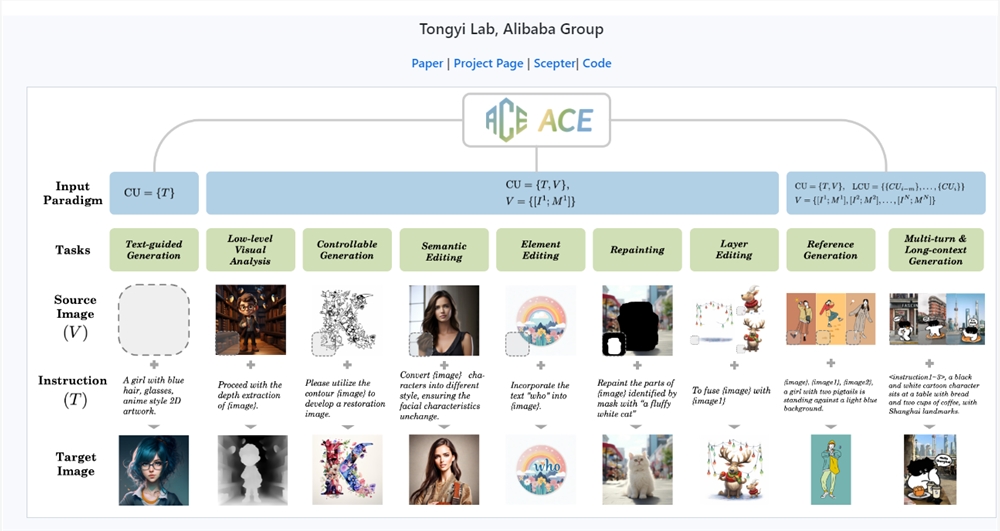

此外,该模拟器还提供了在多个数据中心进行复杂训练模拟的功能。用户可以自行设定数据中心的规模、延迟和连接带宽等参数,进而模拟在多个不同地点的训练过程。此工具还能分析现代显卡如H100和A100之间的性能差异,研究不同批量大小和多GPU训练的效果,并生成详尽的日志文件来记录模型的输出。

Epoch AI指出,开发此模拟器的目的在于深化对硬件效率提升的理解,并评估芯片出口管制带来的影响。鉴于大型训练任务在本世纪预计将有所增加,对未来的硬件需求有更深入的了解显得尤为关键。

划重点:

💻2021年推出的GTX580显卡能够以十倍成本进行GPT-4的训练,但效率不高。

📊 模拟器能够对不同GPU的性能差异进行分析,并支持跨多个数据中心的训练模拟。

🔍 该研究的目的是为了更好地理解未来硬件需求,以助力大型AI模型的训练。

暂无评论