全球首个去中心化训练的10B参数模型诞生了!

Prime Intellect团队宣布,他们完成了一项具有里程碑意义的工作:跨越美国、欧洲和亚洲的去中心化训练网络,成功训练出了一个10B参数的大模型。这标志着AI训练领域迎来了革命性的发展。

Prime Intellect团队宣布,他们完成了一项具有里程碑意义的工作:跨越美国、欧洲和亚洲的去中心化训练网络,成功训练出了一个10B参数的大模型。这标志着AI训练领域迎来了革命性的发展。

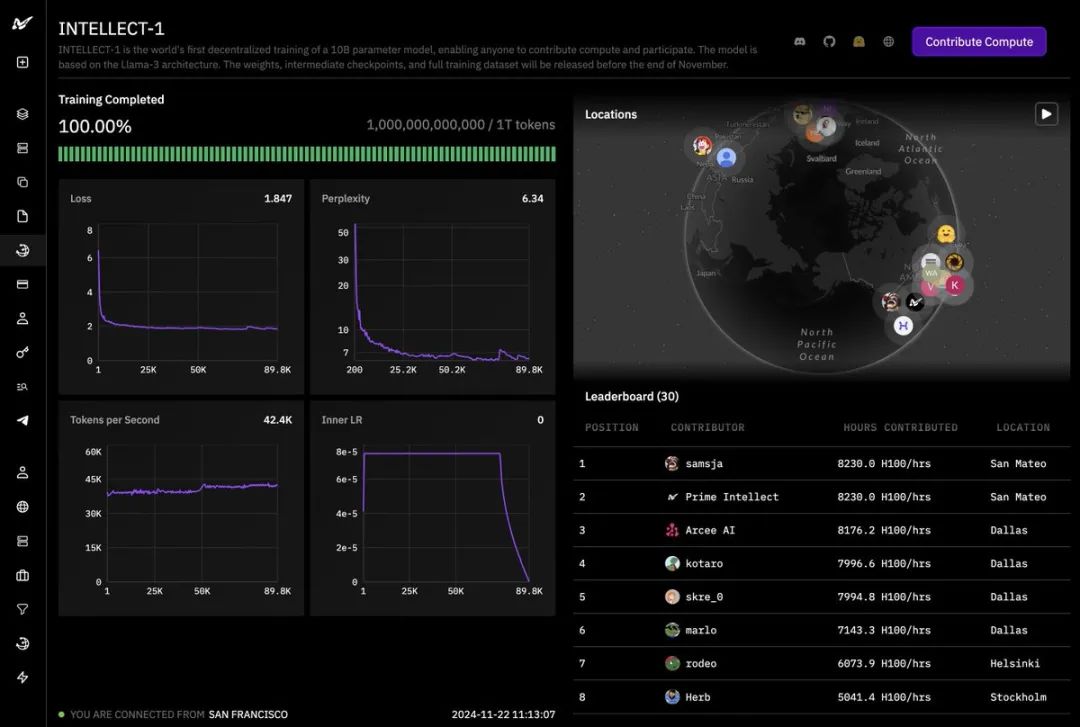

从训练面板上可以看到,这个名为INTELLECT-1的项目已经完成了1万亿(1T)tokens的训练。

损失和困惑度曲线均呈现出理想的下降趋势,且每秒生成的token数量保持稳定,这充分证明了训练过程的成功。

该项目的成功得益于众多合作伙伴的鼎力支持。

该项目的成功得益于众多合作伙伴的鼎力支持。

包括Hugging Face、SemiAnalysis、Arcee.ai、Hyperbolic Labs、Olas、Akash、Schelling AI等多家机构在此次训练中贡献了宝贵的算力资源。这种前所未有的合作模式,展示了AI领域的新型协作方式。

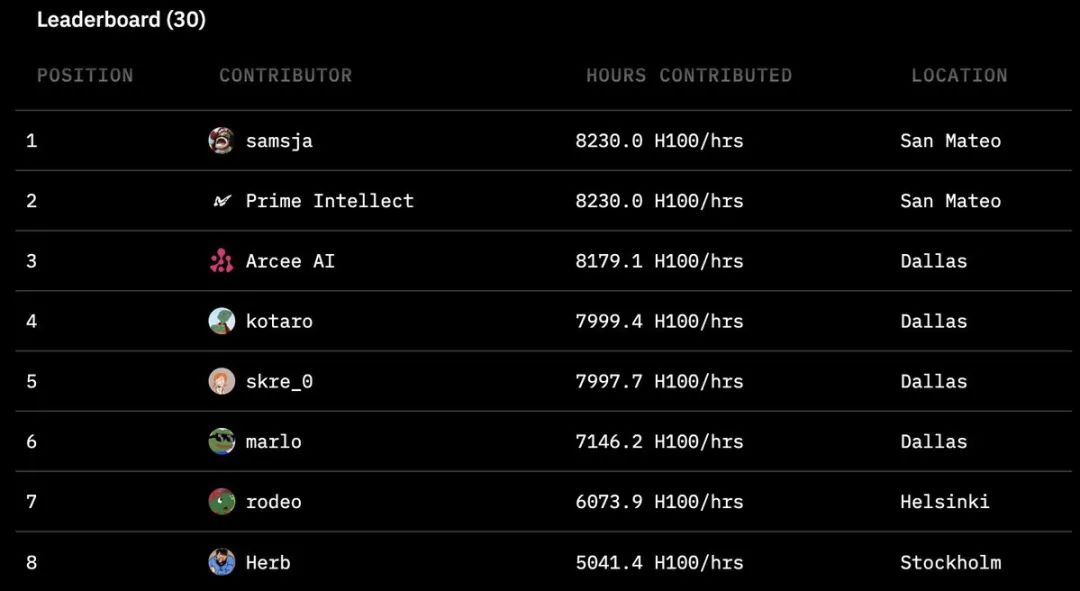

从项目排行榜中可以看出,来自全球各地的贡献者们提供了惊人的计算时间。最高的贡献者达到了8230小时,他们的参与覆盖了圣马特奥、达拉斯、赫尔辛基和斯德哥尔摩等地。这种全球化的算力协作模式,使AI训练不再局限于少数科技巨

从项目排行榜中可以看出,来自全球各地的贡献者们提供了惊人的计算时间。最高的贡献者达到了8230小时,他们的参与覆盖了圣马特奥、达拉斯、赫尔辛基和斯德哥尔摩等地。这种全球化的算力协作模式,使AI训练不再局限于少数科技巨

暂无评论