人工智能领域近年来发展迅速,尤其在大型语言模型(LLM)方面。许多模型如 Qwen 表现出色,甚至能自我检查并纠正错误。然而,并非所有模型都能自我改进。在额外计算资源和“思考”时间下,一些模型性能大幅提升,而另一些则效果有限。这引发了人们思考:究竟是什么导致了这种差异?

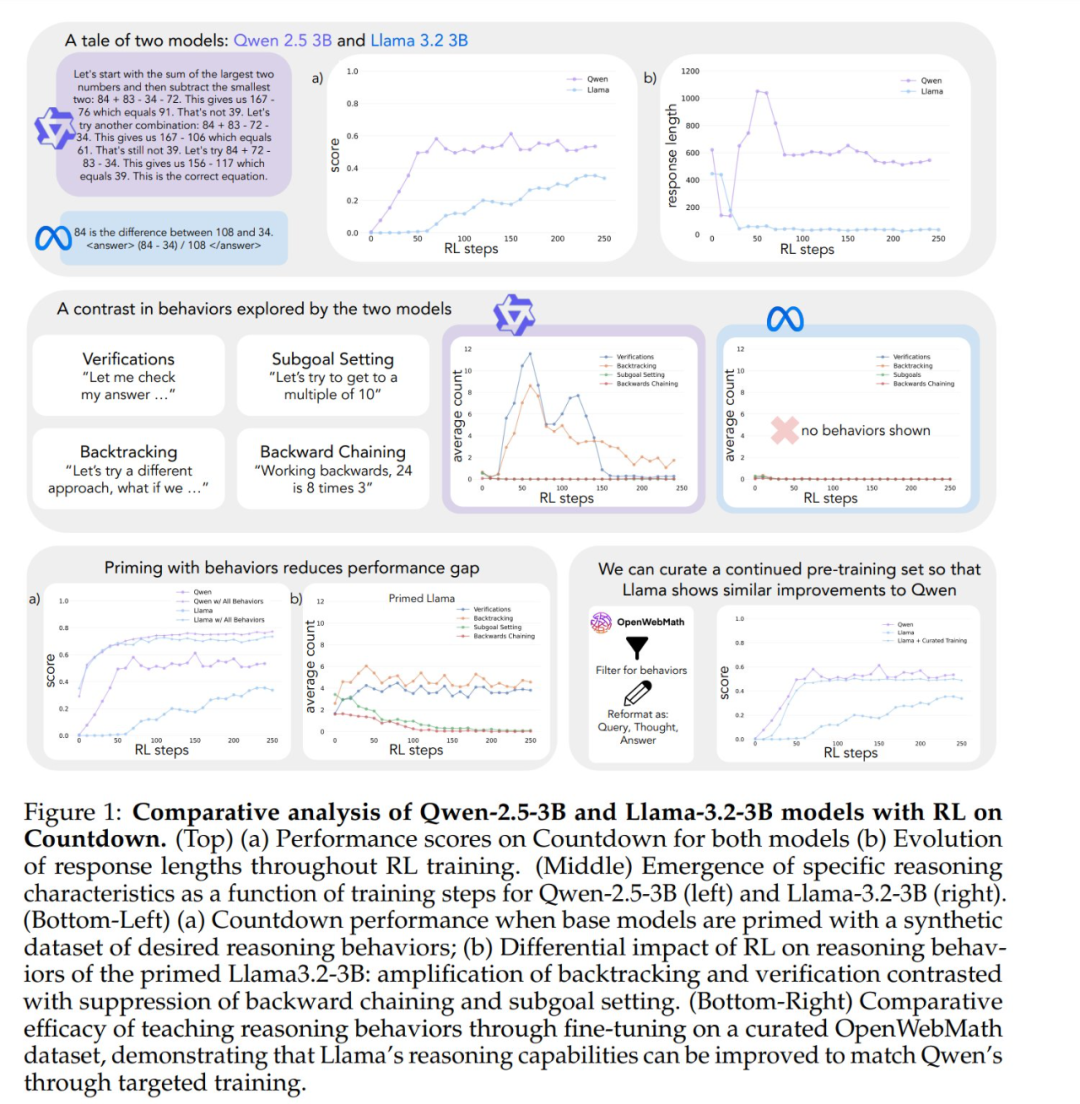

与人类面对难题时深入思考类似,一些先进的大语言模型在强化学习自我改进训练中也展现出类似推理行为。但在相同的强化学习训练下,不同模型自我改进能力存在显著差异。例如,在 Countdown 游戏中,Qwen-2.5-3B 的自我改进能力远超 Llama-3.2-3B。尽管两者初始阶段表现较弱,但在强化学习训练结束后,Qwen 准确率约 60%,而 Llama 仅为 30% 左右。这种显著差距背后隐藏着怎样的机制?

(adsbygoogle=window.adsbygoogle||[]).push({});

最近,斯坦福大学的研究揭示了大型模型自我改进能力背后的机制,揭示了基础语言模型中关键认知行为的重要性。这项研究为理解和提升 AI 系统自我改进能力提供了新视角。

这项研究发布后引起了广泛讨论。Synth Labs 的 CEO 认为,这一发现令人振奋,因为它有望被整合到任何模型中,从而提升模型性能。

四种关键认知行为

为了探究不同模型自我改进能力差异的原因,研究人员将重点放在 Qwen-2.5-3B 和 Llama-3.2-3B 这两款基础模型上。在 Countdown 游戏中进行强化学习训练后,研究人员观察到明显差异:Qwen 的问题解决能力显著提升,而 Llama-3 在相同训练过程中的提升相对有限。那么,是哪些模型属性导致了这种差异?

为了系统地研究这个问题,研究团队开发了一个框架,用于分析对解决问题至关重要的认知行为。该框架描述了四种关键的认知行为:

- 验证 (Verification): 系统性地检查错误。

- 回溯 (Backtracking): 放弃失败的方法,并尝试新的路径。

- 子目标设定 (Sub-goal Setting): 将复杂问题分解为可管理的步骤。

- 逆向思考 (Reverse Thinking): 从期望的结果反向推导至初始输入。

这些行为模式与专家级问题解决者处理复杂任务的方式高度相似。例如,数学家在进行证明时,会仔细验证每一步的推导;当遇到矛盾时,会回溯检查之前的步骤;也会将复杂的定理拆解为更简单的引理来逐步证明。

初步分析表明,Qwen 模型自然地展现出这些推理行为,尤其是在验证和回溯方面,而 Llama-3 模型则明显缺乏这些行为。基于这些观察,研究人员提出了核心假设:初始策略中的某些推理行为对于模型有效利用增加的测试时间计算至关重要。换句话说,如果 AI 模型想要在拥有更多“思考”时间时变得更“聪明”,必须首先具备一些基本的思考能力,例如检查错误、验证结果的习惯。如果模型一开始就缺乏这些基本的思考方法,即使给予再多的思考时间和计算资源,也无法有效地提升其性能。

实验验证:认知行为的重要性

为了验证上述假设,研究人员进行了一系列巧妙的干预实验。

首先,他们尝试使用包含特定认知行为(特别是回溯)的人工合成推理轨迹来引导 Llama-3 模型。结果显示,经过这种引导的 Llama-3 模型在强化学习过程中表现出显著改善,性能提升甚至可以与 Qwen-2.5-3B 相媲美。

其次,即使引导所用的推理轨迹包含错误的答案,只要这些轨迹展现出正确的推理模式,Llama-3 模型依然能够取得进步。这一发现表明,真正驱动模型自我改进的关键因素是推理行为的存在,而非答案本身的正确性。

最后,研究人员从 OpenWebMath 数据集中筛选出强调这些推理行为的内容,并利用这些数据对 Llama-3 模型进行了预训练。实验结果表明,这种有针对性的预训练数据调整能够有效地诱导出模型有效利用计算资源所需的推理行为模式。经过调整预训练的 Llama-3 模型,其性能提升轨迹与 Qwen-2.5-3B 模型表现出惊人的一致性。

这些实验结果有力地揭示了模型的初始推理行为与其自我改进能力之间存在着紧密的联系。这种联系有助于解释为什么某些语言模型能够有效地利用额外的计算资源,而另一些模型则停滞不前。深入理解这些动态变化,对于开发能够显著提升问题解决能力的 AI 系统至关重要。

Countdown 游戏与模型选择

这项研究以一个令人惊讶的观察结果开篇:来自不同模型家族、规模相近的语言模型,在通过强化学习进行训练后,展现出截然不同的性能提升能力。为了深入探究这一现象,研究人员选择了 Countdown 游戏作为主要的测试平台。

Countdown 游戏是一个数学难题,玩家需要使用加、减、乘、除四种基本运算,将一组给定的数字组合起来,以达到目标数字。例如,给定数字 25、30、3、4 和目标数字 32,玩家需要通过一系列运算得到精确的 32,例如: (30 − 25 + 3) × 4 = 32。

之所以选择 Countdown 游戏进行研究,是因为它既能考察模型的数学推理、规划和搜索策略能力,又提供了一个相对受限的搜索空间,使得研究人员能够进行深入分析。与更复杂的领域相比,Countdown 游戏降低了分析的难度,同时仍然能够有效考察复杂的推理能力。此外,与其他数学任务相比,Countdown 游戏的成功更多地依赖于问题解决能力,而非单纯的数学知识。

研究人员选择了 Qwen-2.5-3B 和 Llama-3.2-3B 这两款基础模型,以对比不同模型家族之间的学习差异。强化学习实验基于 VERL 库,并利用 TinyZero 实现。他们使用 PPO (Proximal Policy Optimization) 算法训练模型 250 步,每次提示采样 4 个轨迹。选择 PPO 算法的原因是,相较于 GRPO 和 REIN

暂无评论