近日,通义科技宣布其最新开源的通义万相大模型 Wan2.1。这款AI模型专注于高品质视频生成,凭借在复杂运动处理、真实物理规律还原、影视质感提升及指令遵循优化等方面的卓越性能,成为了创作者、开发者和企业用户在AI时代的重要选择。

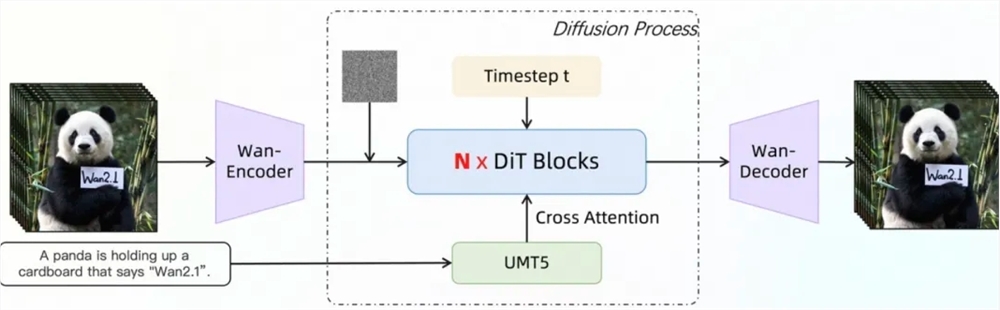

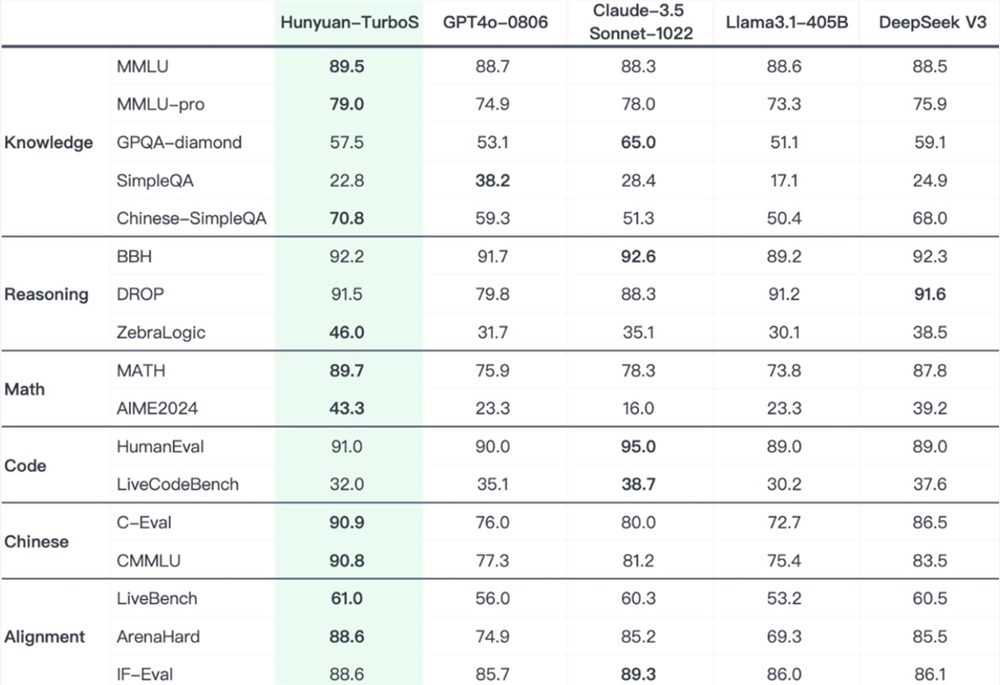

在权威评测集Vbench中,通义万相Wan2.1以总分86.22%的成绩位列第一,大幅领先Sora、Minimax、Luma、Gen3和Pika等国内外知名视频生成模型。这一成就得益于Wan2.1基于DiT和线性噪声轨迹Flow Matching范式,通过一系列技术创新,显著提升了生成能力。其自研的3D因果VAE模块实现了256倍无损视频隐空间压缩,并通过特征缓存机制支持任意长度视频的高效编解码,同时降低了推理时内存占用29%。此外,Wan2.1在单个A800GPU环境下的视频重建速度比现有最先进方法快2.5倍,展现出强大的性能优势。

Wan2.1的视频Diffusion Transformer架构通过Full Attention机制有效建模长时程时空依赖,生成高质量且时空一致的视频。其训练策略采用6阶段分步训练法,从低分辨率图像数据预训练逐步过渡到高分辨率视频数据训练,并通过高质量标注数据微调,确保模型在不同分辨率和复杂场景下的优秀表现。在数据处理方面,Wan2.1设计了四步数据清洗流程,重点关注基础维度、视觉质量和运动质量,以从杂乱的数据集中筛选出高质量且多样化的数据,促进有效训练。

在模型训练和推理效率优化方面,Wan2.1采用了多种策略。训练阶段,针对文本、视频编码模块和DiT模块,分别采用不同的分布式策略,并通过高效的策略切换避免计算冗余。显存优化方面,采用分层的显存优化策略,结合PyTorch显存管理机制解决显存碎片问题。推理阶段,使用FSDP和2D CP的组合方法进行多卡分布式加速,并通过量化方法进一步提升性能。

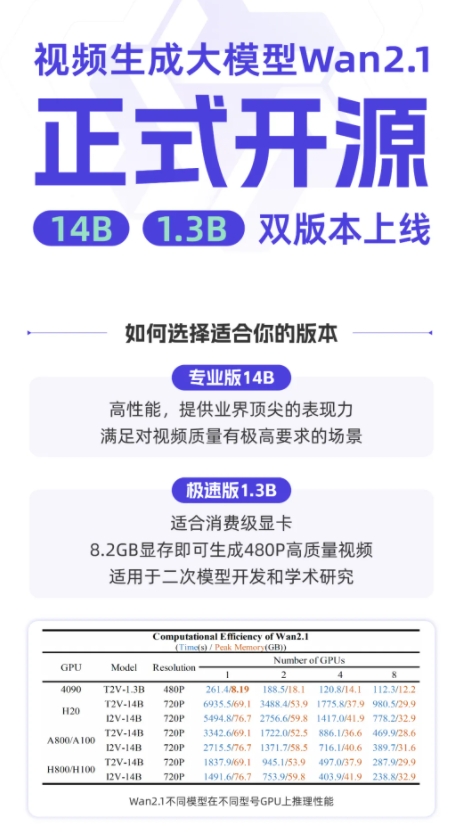

目前,通义万相Wan2.1已在GitHub、Hugging Face和魔搭社区等平台开源,支持多种主流框架。开发者和研究者可以通过Gradio快速体验,或利用xDiT并行加速推理提升效率。同时,该模型正在加速接入Diffusers和ComfyUI,以简化一键推理与部署流程,降低开发门槛,为用户提供灵活的选择,无论是快速原型开发还是高效生产部署,都能轻松实现。

暂无评论