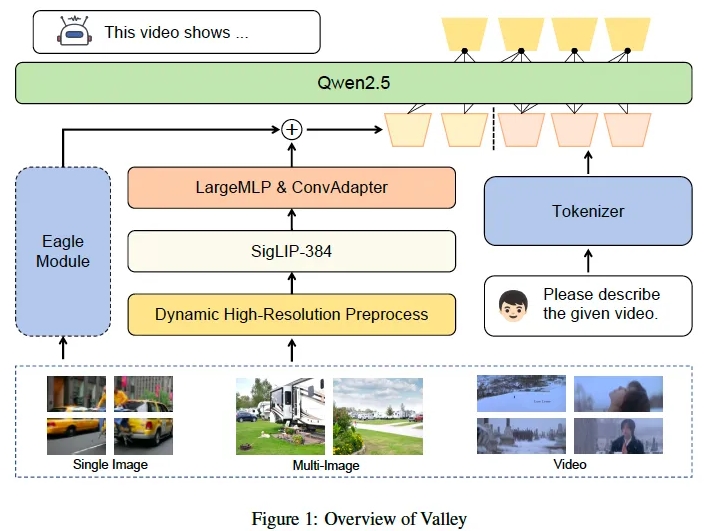

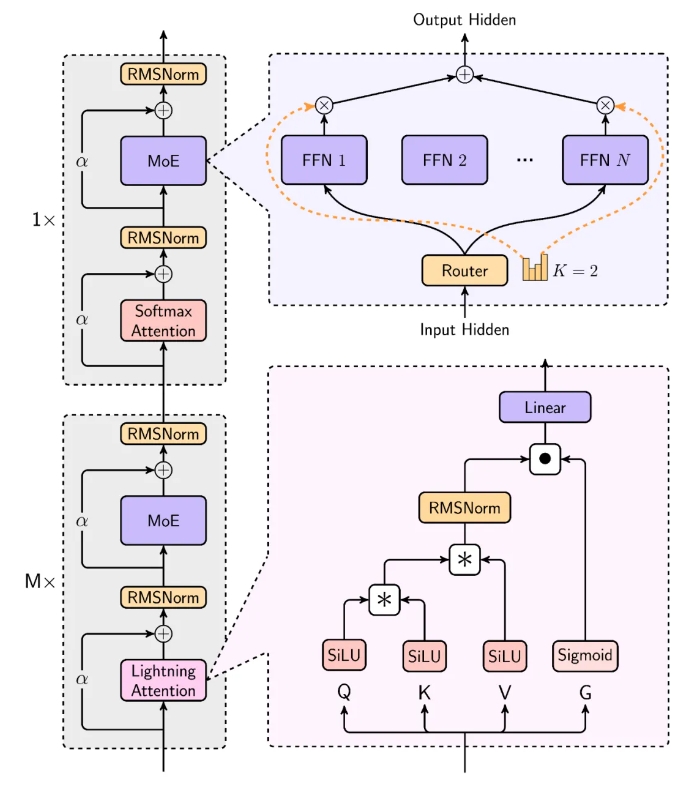

近期,阿里巴巴达摩院发布了一款新型多模态大型语言模型——Valley2。这款模型针对电商场景进行设计,运用可扩展的视觉-语言架构,旨在增强各领域的性能,并拓宽电商与短视频应用的范围。Valley2的核心采用了Qwen2.5作为LLM主干,结合SigLIP-384视觉编码器,通过MLP层和卷积技术进行高效的特征转换。模型创新性地引入了大视觉词汇、卷积适配器(ConvAdapter)和Eagle模块,显著提升了处理多样化真实世界输入的灵活性和训练推理效率。

Valley2的数据来源包括OneVision风格数据、针对电商和短视频领域的数据,以及用于复杂问题解决的链式思维(CoT)数据。其训练过程分为文本-视觉对齐、高质量知识学习、指令微调和链式思维后训练四个阶段。在公开基准测试中,Valley2表现出色,尤其在MMBench、MMStar、MathVista等基准上取得了高分,在Ecom-VQA基准测试中也超越了其他同规模模型。

面向未来,阿里巴巴达摩院计划推出一个融合文本、图像、视频和音频模态的全能模型,并采用基于Valley的多模态嵌入训练方法,以支持检索和探测等下游应用。

Valley2的问世标志着多模态大型语言模型领域的重要突破,展示了通过结构优化、数据集构建和训练策略改进来提升模型性能的潜力。

模型链接:

https://www.modelscope.cn/models/bytedance-research/Valley-Eagle-7B

代码链接:

https://github.com/bytedance/Valley

论文链接:

https://arxiv.org/abs/2501.05901

暂无评论