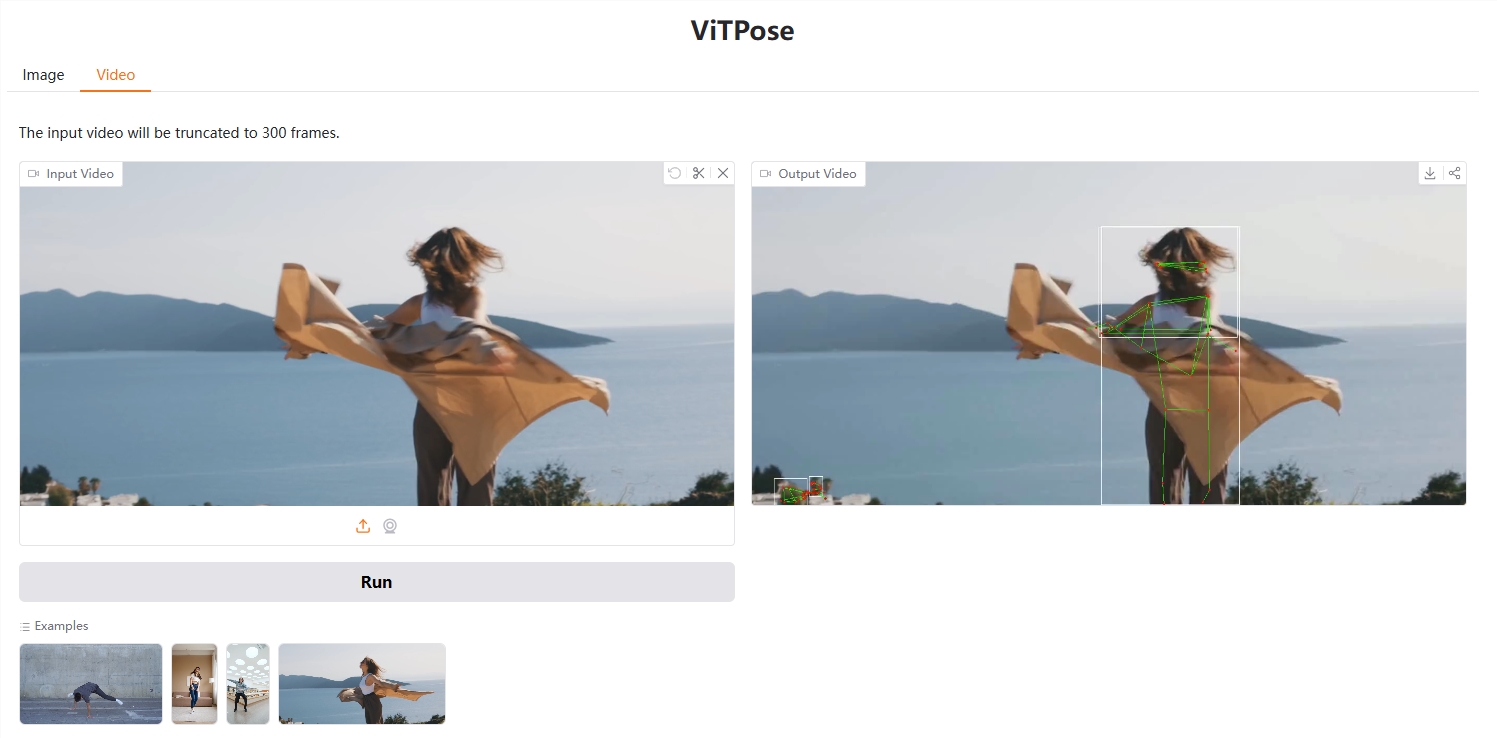

ViTPose是一款开源的动作预测模型,在人体姿态识别方面表现卓越,就像能精准捕捉您的动作。此模型的最大优势在于其简洁与高效,它摒弃了复杂的网络架构,直接运用了视觉Transformer技术。

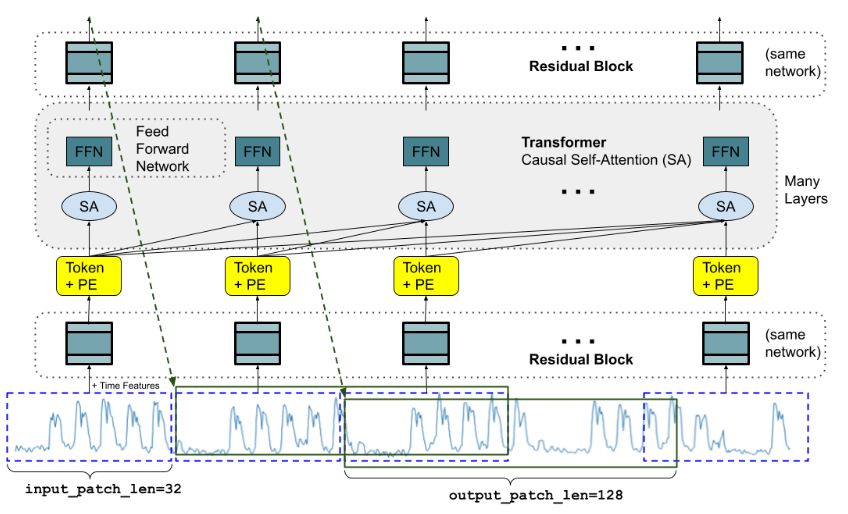

ViTPose的核心技术是采用纯粹的视觉Transformer,这为模型提供了一个强大的“骨骼”,能有效地提取图像中的关键特征。与需要借助复杂卷积神经网络(CNN)的其它模型不同,ViTPose的结构相对简单,只是通过层层叠加多个Transformer。

ViTPose模型可根据需求调整规模,就像一把可伸缩的尺子,您可以通过增加或减少Transformer层的数量来控制模型大小,从而在性能与速度之间取得平衡。此外,您还可以调整输入图片的分辨率,ViTPose均能适应。它还能同时处理多个数据集,可用于识别不同姿势的数据。

尽管结构简单,ViTPose在人体姿态估计领域表现非凡。在MS COCO这一知名数据集上,ViTPose取得了优异的成绩,甚至超越了某些更复杂的模型。这证明了简单模型也能具有强大功能。ViTPose的另一特点是将“知识”从大型模型转移到小型模型,如同经验丰富的教师将知识传授给学生,使小模型也能具备大型模型的实力。

ViTPose的代码和模型均开源,意味着任何人都可以免费使用,并在此基础上进行研究与开发。

ViTPose是一款既简单又强大的工具,助力计算机理解人类动作。其优点在于简单、灵活、高效且易于学习,使其成为人体姿态估计领域极具潜力的基线模型。

该模型利用Transformer层处理图像数据,并通过轻量级解码器预测关键点。解码器可以使用简单的反卷积层或双线性插值来上采样特征图。ViTPose不仅在标准数据集上表现优秀,在处理遮挡和不同姿势的情况下也表现卓越。它可用于人体姿态估计、动物姿态估计以及面部关键点检测等多种任务。

demo: https://huggingface.co/spaces/hysts/ViTPose-transformers

模型: https://huggingface.co/collections/usyd-community/vitpose-677fcfd0a0b2b5c8f79c4335

暂无评论