AI驱动的文本转图像(T2I)生成模型,如DALLE3、Adobe Firefly3等,表现出色,在多种实际应用中展现巨大潜力。然而,这些模型往往拥有数十亿参数,对内存的需求极高,这在资源受限的移动设备等平台上部署时构成巨大挑战。

为解决这一难题,ByteDance和POSTECH的研究人员致力于开发T2I模型的极低位量化技术。在众多模型中,FLUX.1-dev因其高性能和易于获取的特点,成为研究的热点。

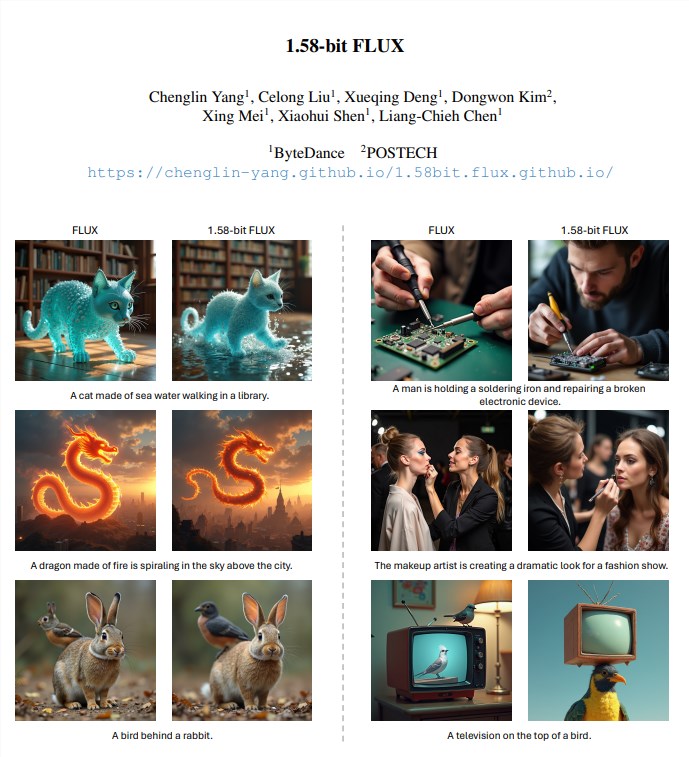

研究人员采用1.58位量化技术,对FLUX模型中的视觉转换器权重进行压缩,仅保留{-1,0,+1}三个数值。这种方法无需依赖图像数据,仅依靠FLUX.1-dev模型的自监督即可完成。与BitNet b1.58方法不同,它并非从头训练大型语言模型,而是作为T2I模型的后训练量化解决方案。

采用此方法,模型存储空间减少了7.7倍,实现了从16位精度的压缩。此外,研究人员还开发了一个针对低位计算优化的定制内核,使推理内存使用量减少了超过5.1倍,并降低了推理延迟。

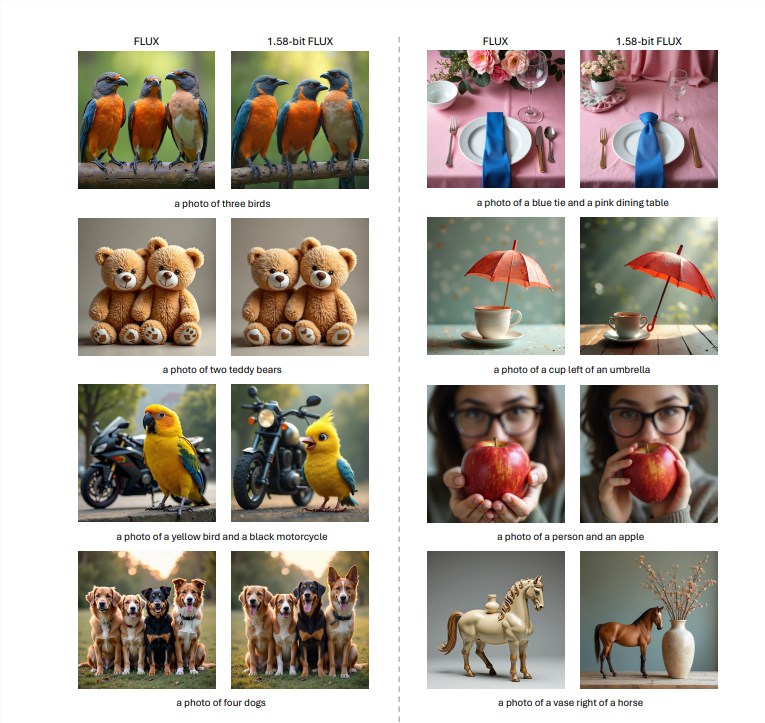

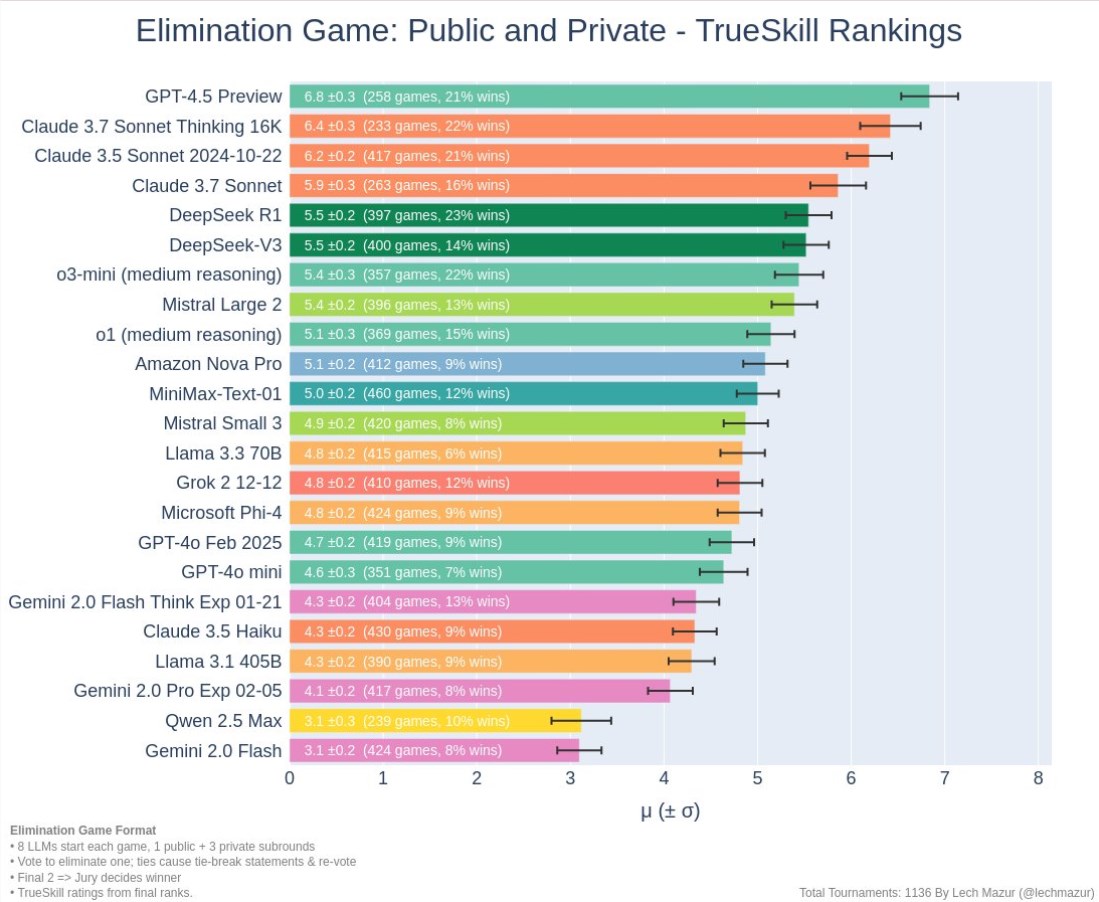

在GenEval和T2I Compbench基准测试中,1.58位FLUX在保持与全精度FLUX模型相当的生成质量的同时,显著提高了计算效率。

具体来说,研究人员将FLUX模型中99.5%的视觉转换器参数(总计119亿)量化为1.58位,从而大幅降低了存储需求。

实验结果表明,1.58位FLUX在T2I CompBench和GenEval数据集上的性能与原始FLUX模型相当。在推理速度方面,1.58位FLUX在低性能GPU(如L20和A10)上表现出更显著的改进。

总体而言,1.58位FLUX的推出,标志着在实现高质量T2I模型在内存和延迟受限的设备上实际部署方面取得重要进展。

尽管1.58位FLUX在速度改进和高分辨率图像细节渲染方面仍有待提升,但其提高模型效率和降低资源消耗的潜力巨大,为未来研究提供了新的思路。

主要改进总结:

模型压缩:模型存储空间减少了7.7倍。

内存优化:推理内存使用量减少了5.1倍以上。

性能保持:在GenEval和T2I Compbench基准测试中,1.58位FLUX保持了与全精度FLUX模型相当的性能。

无需图像数据:量化过程无需访问任何图像数据,仅依赖模型自身的自监督。

定制内核:采用了为低位计算优化的定制内核,提升了推理效率。

项目页:https://chenglin-yang.github.io/1.58bit.flux.github.io/

论文地址:https://arxiv.org/pdf/2412.18653

模型地址:https://huggingface.co/papers/2412.18653

暂无评论