(adsbygoogle=window.adsbygoogle||[]).push({});

我们的R系列中最小的模型提供卓越的速度、效率和质量,能够在普通GPU和边缘设备上构建强大的AI应用程序。

今天,我们非常高兴地发布Command R7B,这是我们为企业开发的大语言模型(LLM)R系列中体积最小、速度最快、最新的模型。Command R7B在其开放权重模型类别中提供了业界领先的性能,具备处理对用户重要的真实世界任务的能力。该模型专为需要优化速度、成本效益和计算资源的开发者和企业设计。

与R系列中的其他模型相同,Command R7B提供了128k的上下文长度,并在多个关键业务应用场景中表现出色。它融合了强大的多语言支持、引用验证的检索增强生成(RAG)、推理、工具使用和智能体行为等功能。由于其紧凑体积和高效性,它可以在低端GPU、MacBook甚至CPU上运行,大幅降低将AI应用程序投入生产的成本。

小体积带来的高性能

一款全面的模型

Command R7B在标准化和可外部验证的基准测试中表现出色,如HuggingFace Open LLM排行榜。与其他同类开放权重模型相比,Command R7B在所有任务上平均排名第一,表现优异。

HuggingFace排行榜评估结果。竞争对手的数据来源于官方排行榜。Command R7B的结果是我们根据官方HuggingFace提供的提示和评估代码计算得出的。

数学、代码和推理任务的效率提升

Command R7B的一大重点是提高在数学与推理、代码编写和多语言任务上的性能。特别是,该模型在常见的数学和代码基准测试中,能够匹配或超过同类开放权重模型的表现,而所使用的参数更少。

模型在数学和代码基准测试中的表现。所有数据均来自内部评估,标有星号的数字来自外部报告的结果,这些结果较高。我们使用MBPPPlus的基础版本,LBPP是跨六种语言的平均值,SQL是三个数据集的平均值(仅限较高和超高难度的SpiderDev和Test部分、BirdBench以及一个内部数据集),COBOL是内部开发的数据集。

使用NTREX数据集评估的文档翻译质量(通过语料库spBLEU指标)。

一流的RAG、工具使用和智能体

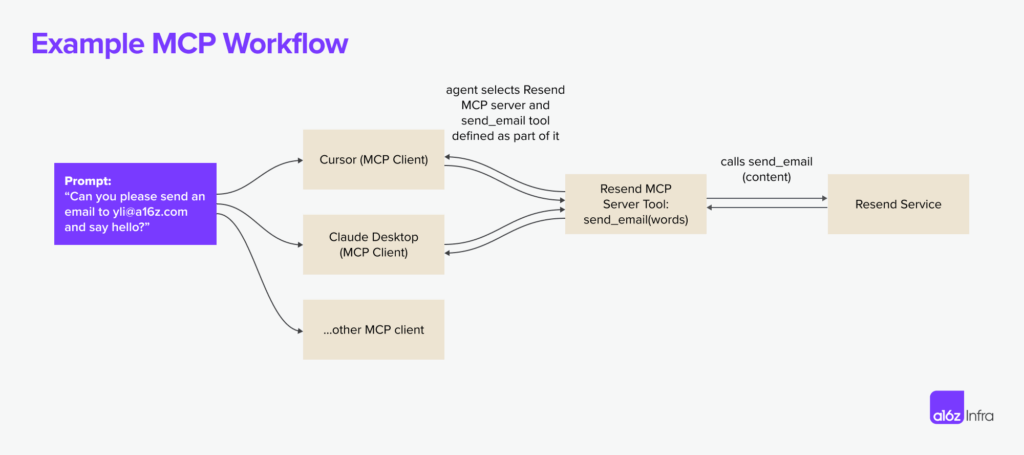

在处理核心业务用例如RAG、工具使用和AI智能体方面,Command R7B优于其他同类开放权重模型。它是那些希望基于内部文档和数据构建成本效益模型的企业的理想之选。与我们的其他R系列模型相同,我们的RAG提供了本地内联引用,显著降低了幻觉现象,并使事实核查变得更简单。

在ChatRAGBench(10个数据集平均)、BFCL-v3、StrategyQA、Bamboogle和Tooltalk-hard上的性能评估。方法学和更多细节请见下面的脚注[1]。

在工具使用方面,与同类规模模型相比,Command R7B在业界标准的Berkeley Function-Calling Leaderboard上表现更强。这表明Command R7B在现实世界多样化和动态环境中,特别擅长工具使用,并且能够避免不必要地调用工具,这是实际应用中工具使用的重要考量。Command R7B的多步工具使用能力使其能够支持快速且高效的AI智能体。

针对企业用例的优化

我们的模型经过优化,以满足企业在实际部署AI系统时所需的能力。R系列模型在效率与强大性能之间提供了无与伦比的平衡。这意味着确保它们在人类评估中表现优秀,这是质量评估的金标准。Command R7B在关于RAG用例的盲评头对头测试中,优于同类规模的开放权重模型,这些用例涉及客户关心的AI助手构建,如客服、人力资源、合规性和IT支持等职能。

在人类评估中,Command R7B与Gemma 2 9B在949个企业RAG用例的样本上进行对比测试。所有示例均由专门训练的人工标注员至少进行三次盲标注,评估流畅性、忠实度和回答实用性。

高效且快速

Command R7B的紧凑体积确保较小的服务占用空间,适合快速原型开发和迭代。它在高吞吐量的实时用例中表现卓越,如聊天机器人和代码助手。它还能够大幅降低部署基础设施成本,如消费者级GPU和CPU,从而支持设备端推理。

在此过程中,我们未妥协于企业级安全和隐私标准,以确保客户数据的安全。

快速入门

Command R7B今天可以在Cohere Platform上使用,同时也可以通过HuggingFace访问。我们非常高兴能够发布该模型的权重,为AI研究社区提供更广泛的前沿技术访问。

| Cohere API 定价 | 输入 Token | 输出 Token |

|---|---|---|

| Command R7B | $0.0375 / 1M | $0.15 / 1M |

[1] 对话式RAG:在10个数据集的ChatRAGBench基准上进行的平均性能测试,测试生成回答在多种环境中的能力,包括对话任务、处理长输入、分析表格以及在金融环境中提取和操作数据信息。我们改进了评估方法,使用PoLL判别器集成(Verga等,2024),结合Haiku、GPT3.5和Command R,提供了更高的一致性(Fleiss’ kappa=0.74,相较于原始版本的0.57,基于两万个人工评定)。工具使用:2024年12月12日BFCL-v3基准测试的表现。所有可用分数均来自公开排行榜,其余使用官方代码库进行内部评估。对于竞争者,我们报告其BFCL‘prompted’或‘function-calling’分数中的较高者。我们报告的包括总体得分、实时子集得分(测试工具在现实世界中多样化和动态环境中的使用)和无关子集得分(测试模型如何避免不必要地调用工具)。REACT Agent/多步:我们评估了LangChain REACT智能体在连接互联网后,如何分解复杂问题并制定成功执行研究计划的能力,使用Bamboogle和StrategyQA。Bamboogle使用PoLL集成进行评估,StrategyQA通过评估模型是否按照格式指令,最终判断回答为‘Yes’或‘No’来进行。我们使用Chen等(2023)和Press等(2023)的测试集。ToolTalk挑战模型执行复杂推理,并主动向用户询问信息,以完成复杂的用户任务,如账户管理、发送电子邮件和更新日历。ToolTalk-hard使用官方ToolTalk库的软成功率进行评估。ToolTalk要求模型公开一个函数调用API,而Gemma 2 9B则没有此功能。

暂无评论