在年初,谷歌推出了第六代TPU——Trillium,这是迄今为止最强大的TPU。如今,Google Cloud的客户可以正式使用Trillium。

谷歌利用Trillium TPU训练了最新的Gemini2.0 AI模型,这是谷歌有史以来最强大的AI模型。现在,无论是大型企业还是初创公司,都可以利用这一强大、高效且可持续的基础设施。

AI超级计算机的核心:Trillium TPU

Trillium TPU是Google Cloud AI Hypercomputer的关键部分。AI Hypercomputer是一种创新的超级计算机架构,它整合了性能优化的硬件、开源软件、领先的机器学习框架和灵活的消费模型。随着Trillium TPU的推出,谷歌对AI Hypercomputer的开源软件层进行了关键性增强,包括优化XLA编译器和JAX、PyTorch、TensorFlow等流行框架,以实现AI训练、调优和服务的领先性价比。

此外,通过使用大规模主机DRAM(补充高带宽内存或HBM)的主机卸载等功能,实现了更高的效率。AI Hypercomputer能够从超过10万个Trillium芯片的部署中提取最大价值,该架构具有13Petabits/秒的双向带宽,能够将单个分布式训练作业扩展到数十万个加速器。

AI21Labs等客户已经开始使用Trillium,以更快地向其客户提供有意义的AI解决方案:

AI21Labs的首席技术官Barak Lenz表示:“在AI21,我们致力于提升Mamba和Jamba语言模型的性能和效率。作为TPU v4的长期用户,我们对Google Cloud的Trillium印象深刻。它在规模、速度和成本效率方面的进步非常显著。我们相信Trillium将在加速我们下一代复杂语言模型的开发中发挥关键作用,使我们能够为客户提供更强大、更易获取的AI解决方案。”

Trillium性能显著提升,多项指标刷新纪录

Trillium相较于前一代在以下方面实现了显著改进:

训练性能提升超过4倍

推理吞吐量提升3倍

能源效率提升67%

每个芯片的峰值计算性能提升4.7倍

高带宽内存(HBM)容量翻倍

芯片间互连(ICI)带宽翻倍

单个Jupiter网络架构中包含10万个Trillium芯片

每美元训练性能提升2.5倍,每美元推理性能提升1.4倍

这些增强功能使Trillium在各种AI工作负载中表现出色,包括:

扩展AI训练工作负载

训练大型语言模型(LLM),包括密集型模型和混合专家(MoE)模型

推理性能和集合调度

嵌入密集型模型

提供训练和推理性价比

Trillium如何在不同的工作负载中表现出色?

扩展AI训练工作负载

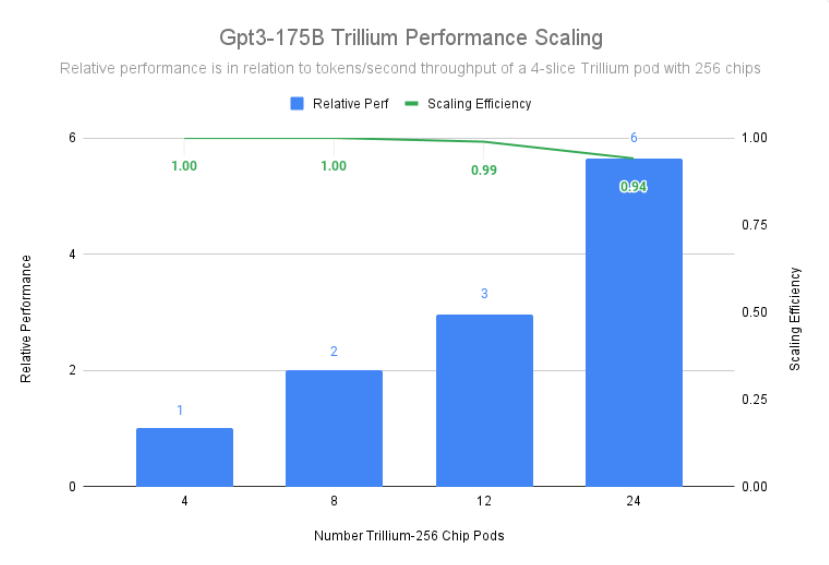

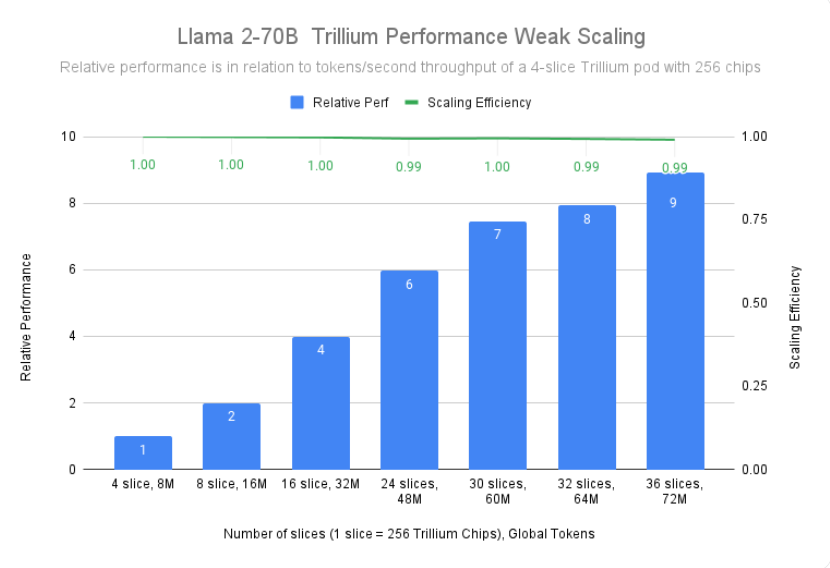

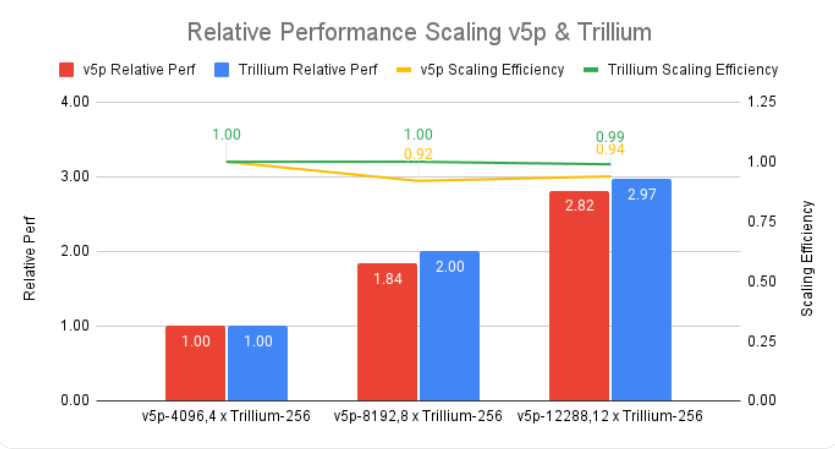

训练像Gemini2.0这样的大型模型需要大量的数据和计算。Trillium的近线性扩展能力使这些模型可以通过在多个Trillium主机之间有效且高效地分配工作负载来显著加快训练速度,这些主机通过高速芯片间互连连接在256芯片pod和我们的先进Jupiter数据中心网络中。这通过TPU多片、用于大规模训练的全栈技术实现,并通过Titanium进一步优化,Titanium是一种

暂无评论