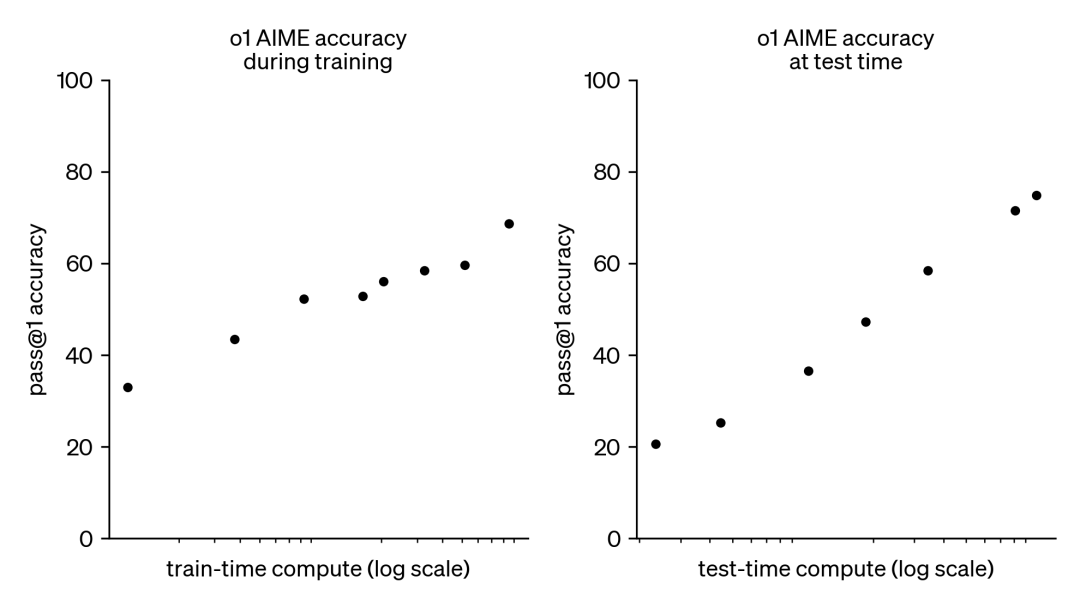

小模型凭借更长思考时间超越大模型的研究进展

小模型在给定足够的思考时间后,其性能有时可超越更大模型。通过有效的测试时计算扩展策略,如动态推理、迭代自我改进及多样性验证器树搜索,较小模型在解决复杂问题上展现出巨大潜力。HuggingFace 通过研究证明,优化小型大语言模型的思考时间可实现以较低计算资源获得更优性能,为AI模型的应用开辟了新方向。

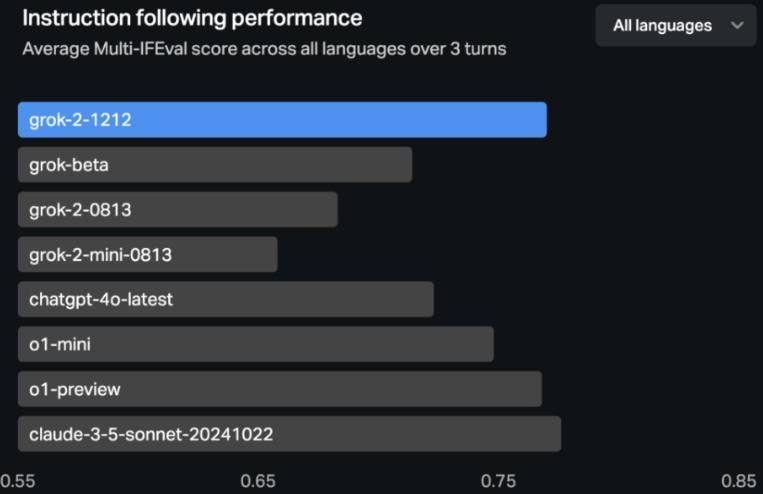

xAI升级GrokAI聊天机器人,性能提升显著,信息获取更智能

xAI升级Grok AI聊天机器人,性能提升显著,速度是前版本三倍,支持更多语言,可引用外部信息源,新增Grok按钮提供上下文,免费向X平台用户提供。

Meta发布Llama3.3:700亿参数的高效大型语言模型揭秘

Meta推出的Llama 3.3是一个具有700亿参数的大型语言模型,输入成本比前代降低10倍,指令遵循能力强于GPT-4o和Claude 3.5 Sonnet。该模型支持8种语言,性能卓越,友好部署,适合中小开发团队。新增安全机制确保性能与责任并重,累计下载超过6.5亿次,标志着开源AI的广泛应用。Llama 3.3已在Ollam模型库中上线,方便直接下载与部署。

英伟达RTX50系列显卡性能曝光,RTX5090性能提升60%-70%备受期待

英伟达RTX 50系列显卡性能大幅提升,RTX 5090预计提升60%-70%,RTX 5080提升30%-40%,中端型号提升20%-30%。市场对新显卡充满期待,虽预测数值各异,但普遍看好其性能进步。英伟达即将举办发布会,或揭晓RTX 50系列详情。

金仓数据库KingbaseESV9荣获2024年度技术卓越奖,创新性能领先业界

金仓数据库KingbaseES V9荣获2024年度IT168技术卓越奖,技术创新性能提升显著,支持多种集群架构,安全可靠,自主创新成核心竞争力。

谷歌发布第六代TPUTrillium,AI超算性能大幅提升,助力企业创新

谷歌发布第六代TPU——Trillium,为Google Cloud客户提供强大AI模型训练和推理能力,提升性能、效率与性价比,推动AI技术发展。

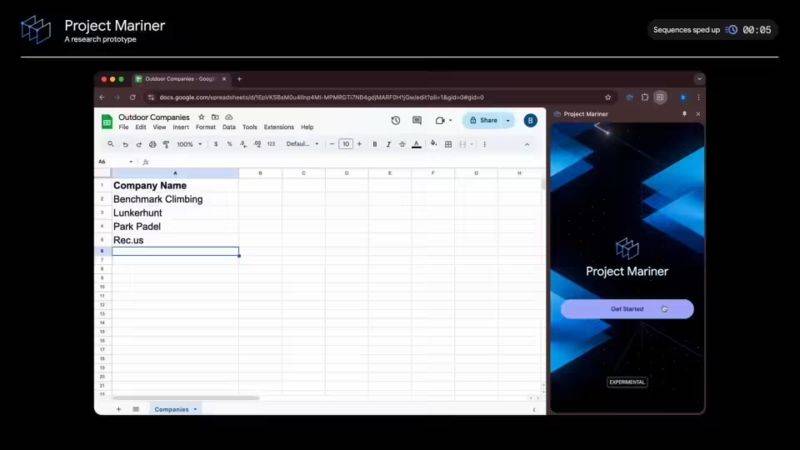

谷歌发布Mariner智能体原型,基于Gemini2.0AI模型,浏览器交互能力强大

谷歌推出基于Gemini 2.0 AI模型的智能体Mariner,具备强大浏览器交互能力,能执行复杂操作,实用价值高。在WebVoyager测试中表现优异,保护用户隐私安全,未来应用前景广阔。

谷歌发布第六代AI加速器Trillium芯片,性能提升四倍助力AI发展

谷歌发布第六代AI加速器芯片Trillium,性能提升四倍,能耗降低,推动AI训练效率,每美元训练性能提升2.5倍,可能重塑AI开发经济模型。