北京智源人工智能研究院(BAAI)近日推出了一款名为See3D的创新3D生成模型。该模型利用大规模未标注的互联网视频进行学习,实现了“观看视频,获取3D”的技术理念。See3D模型摒弃了传统依赖相机参数的方法,采用视觉条件技术,仅通过视频中的视觉线索就能生成多视角图像,这些图像具有可控的相机方向和几何一致性。这一技术避免了高成本的3D或相机标注需求,实现了高效地从网络视频中学习3D先验知识。

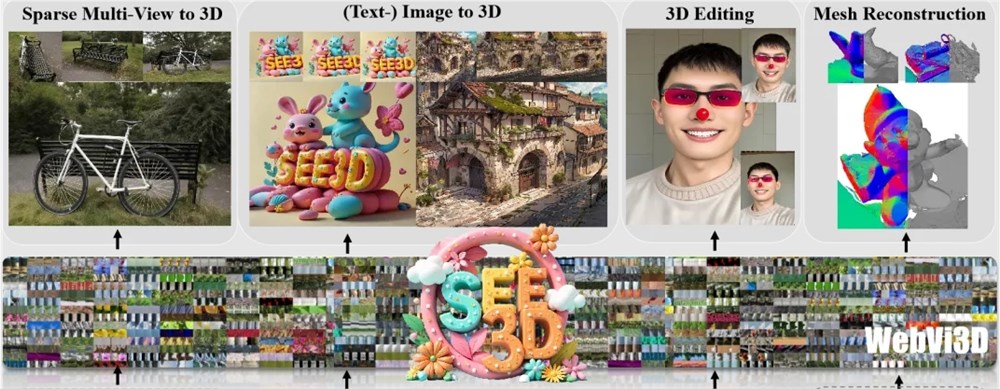

See3D模型具备从文本、单视图和稀疏视图生成3D的能力,并支持3D编辑与高斯渲染。该模型的代码和Demo已开源,供技术人员参考。See3D的应用展示包括3D互动世界的解锁、基于稀疏图片的3D重建、开放世界3D生成以及单视图3D生成,这些功能使得See3D在3D创作领域具有广泛的应用潜力。

研究的初衷是为了解决3D数据获取的限制。传统的3D数据采集既耗时又昂贵,而视频因其包含多视角关联性和相机运动信息,成为揭示3D结构的有效手段。See3D提出了一套完整的解决方案,包括数据集构建、模型训练和3D生成框架。研究团队筛选了大量视频数据,构建了包含1600万视频片段、3.2亿帧图像的WebVi3D数据集。See3D模型通过向掩码视频数据添加时间依赖噪声,生成纯2D视觉信号,支持多视图扩散模型训练,实现了无需相机参数的3D生成。

See3D的优势在于数据扩展性、相机可控性和几何一致性。其训练数据来源于丰富的互联网视频资源,构建的多视图数据集在规模上实现了显著提升。模型能够在任意复杂的相机轨迹下生成场景,并保持前后帧视图的几何一致性。

通过扩大数据集规模,See3D为3D生成技术的发展提供了新方向。我们希望这项工作能推动3D研究社区关注大规模无相机标注数据,降低3D数据采集成本,缩小与闭源3D解决方案的差距。

项目地址: https://vision.baai.ac.cn/see3d

暂无评论