在人工智能领域,后训练技术正逐步成为提高模型性能的关键手段。近期,艾伦人工智能研究所(AI2)发布了Tülu3系列模型,这是一套开源的先进语言模型,其性能足以与闭源模型GPT-4o-mini相匹敌。Tülu3不仅提供了模型数据、代码和训练配方,还包括了评估框架,旨在推进开源模型后训练技术的发展。

通常情况下,仅经过预训练的模型难以满足实际应用需求,可能会产生有害信息,且不易遵循人类指令。因此,后训练阶段,如指令微调和人类反馈学习,显得尤为关键。然而,如何优化后训练过程仍是技术挑战,因为在提升模型某项能力的同时,可能会影响其他能力。

面对这一挑战,众多企业纷纷提高后训练方法的复杂性,尝试多轮训练并结合人工与合成数据,但这些方法大多仍为闭源。与此相对的是,Tülu3系列的发布,缩小了开源模型与闭源模型之间的性能差距,为训练方法带来了新的思路。

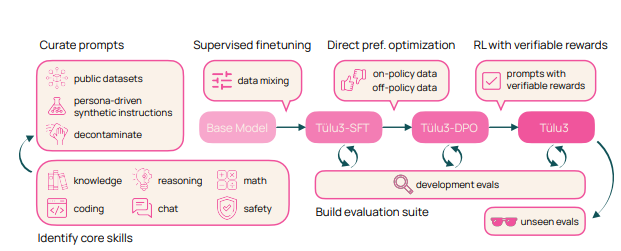

Tülu3的训练过程包括四个阶段:数据构造、监督微调、偏好调整和可验证奖励的强化学习。

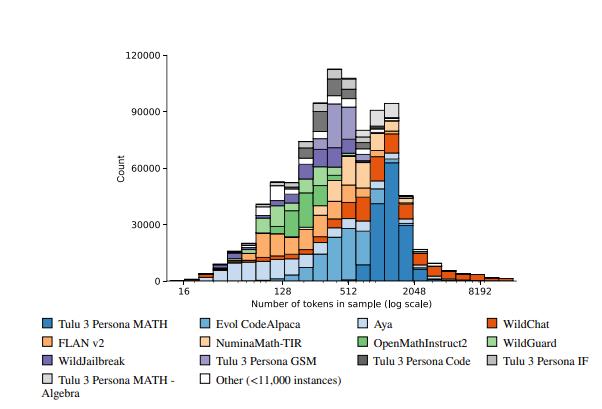

首先,研究人员专注于模型的核心技能,通过结合人工数据与合成数据来构建训练数据。

其次,进行监督式微调,确保模型在特定技能上的表现不亚于其他先进模型。

接着,采用直接偏好优化的方法进一步提升模型的整体性能。最后,创新性地引入可验证奖励强化学习,帮助模型更好地完成可验证结果的任务。

Tülu3模型基于Llama3.1构建,在推理、数学、编程和指令遵循等领域表现优异。与其他开源和闭源模型相比,Tülu3在多个基准测试中的综合能力表现突出,标志着开源后训练技术的一次重大突破。

论文链接:https://allenai.org/papers/tulu-3-report.pdf

Demo:https://playground.allenai.org/

重点摘要:

🌟 Tülu3是AI2推出的开源语言模型,性能与闭源模型GPT-4o-mini相当。

🔧 后训练技术对于提升模型在实际应用中的表现至关重要。

📊 Tülu3的训练过程创新,分为数据构造、监督微调、偏好调整和可验证奖励强化学习四个阶段。

暂无评论