在人工智能的领域中,“大力出奇迹”似乎成为了一种普遍的信念。模型越大、数据越丰富、计算能力越强,似乎就能离实现智能的理想更近一步。然而,这种快速发展的背后,也隐藏着巨大的成本与能耗压力。

为了提高人工智能训练的效率,科学家们不断寻找更为强大的优化器,这就如同教练指导运动员不断优化表现,最终达到最佳状态。AdamW作为Transformer预训练的默认优化器,多年来一直是业界的标杆。然而,面对日益庞大的模型,AdamW逐渐显得捉襟见肘。

是否存在一种方法,能够同时提升训练速度和降低能耗呢?别急,一个全华人团队正带着他们的“秘密武器”C-AdamW而来!

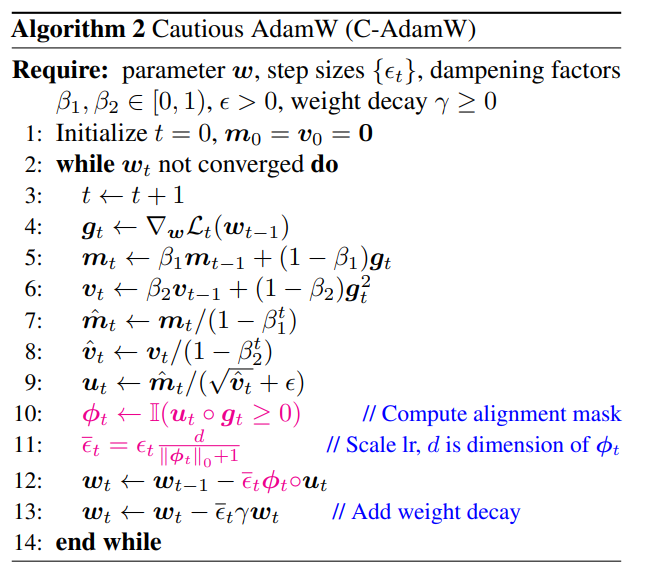

C-AdamW全称为Cautious AdamW,中文可译为“谨慎AdamW”,听起来是不是颇具“佛系”意味?没错,C-AdamW的核心理念正是“三思而后行”。

试想一下,模型的参数就像一群活泼的小朋友,总是想到处乱跑。AdamW就像一位细心的老师,努力引导他们朝正确的方向前进。但是,有时小朋友们会过于兴奋,跑错方向,反而浪费了时间和精力。

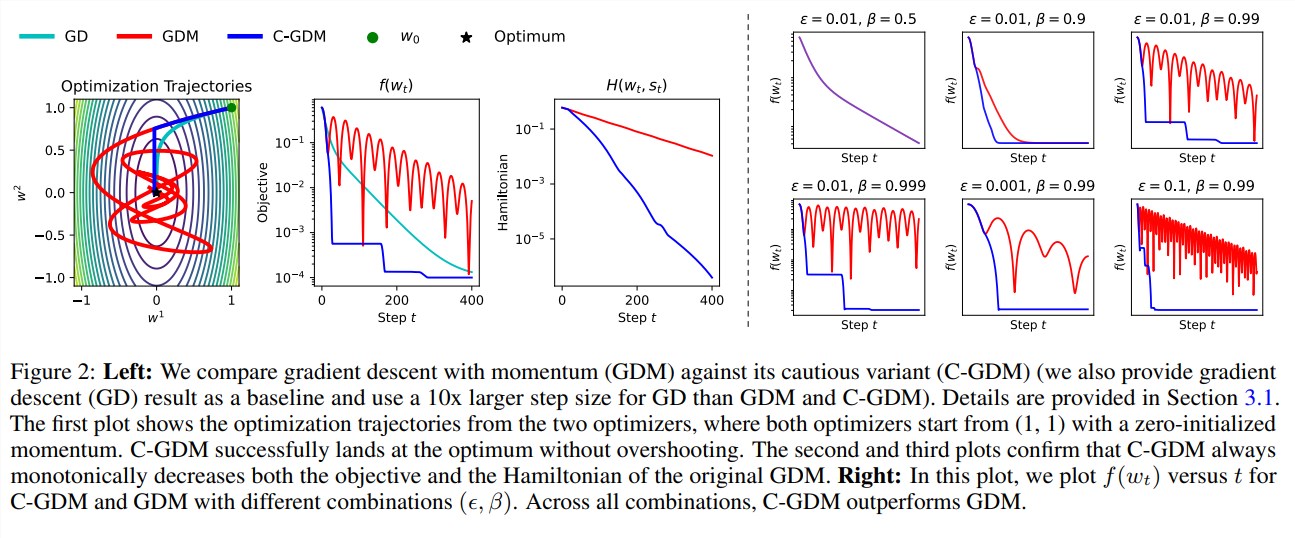

在这种情况下,C-AdamW就如同一位机智的长者,具备“火眼金睛”,能够精准判别更新方向是否正确。若方向错误,C-AdamW会果断制止,帮助模型避免在错误的道路上越走越远。

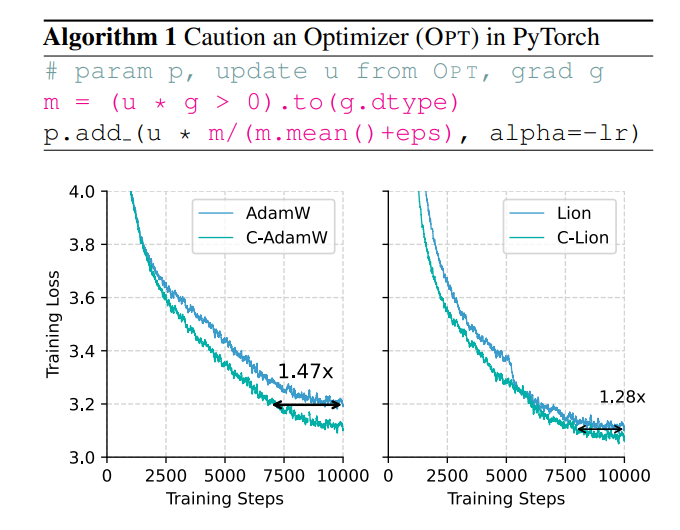

这种“谨慎”的策略确保每次更新都能有效降低损失函数,从而加快模型的收敛速度。实验结果显示,在Llama和MAE的预训练中,C-AdamW的训练速度提高了1.47倍!

更重要的是,C-AdamW几乎没有额外的计算开销,只需对现有代码进行一行简单的修改即可实现。这意味着开发者们可以轻松将C-AdamW应用于多种模型训练,享受“速度与激情”的双重体验!

C-AdamW的“佛系”特性还体现在保留了Adam的哈密顿函数,并在李雅普诺夫分析的框架下保证不破坏收敛性。这表示,C-AdamW不仅提升了速度,稳定性也得到了保障,不必担心训练崩溃等问题。

当然,“佛系”并不代表“止步不前”。研究团队表示,他们将持续探索更丰富的ϕ函数,并在特征空间而非参数空间中实现掩码,以进一步提升C-AdamW的性能。

可以预见,C-AdamW将成为深度学习领域的新宠,为大型模型的训练带来革命性的变革!

暂无评论