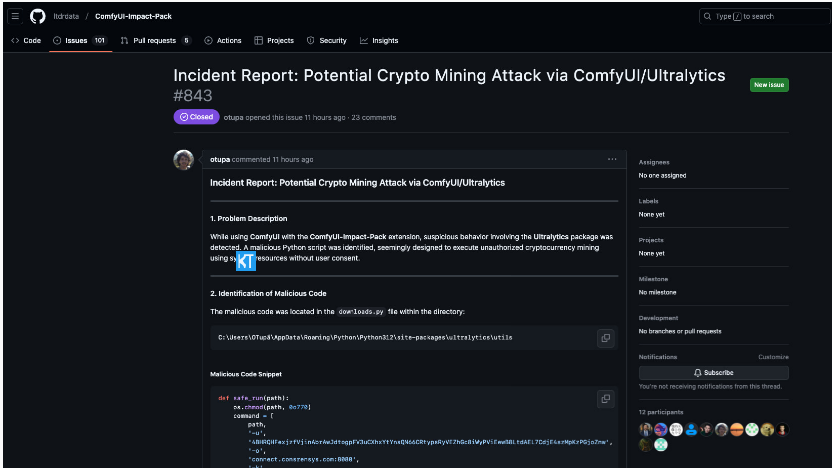

近日,谷歌发布了一款名为PaliGemma2的全新AI模型系列,该模型宣称具备通过图像分析“辨识”人类情绪的能力。这一说法迅速引起了学术界和技术伦理专家的热烈讨论和深度质疑。

基于Gemma开放模型,这款AI系统能够生成详尽的图像描述,不仅限于简单的物体识别,还试图描绘图像中人物的行为和情感。然而,多位权威专家对这项技术的科学性和潜在风险提出了严厉警告。

牛津互联网研究所的数据伦理教授桑德拉·瓦赫特直言,利用AI“解读”人类情绪犹如“向魔法八号球寻求建议”。这一比喻生动展现了情绪识别技术的荒谬性。

实际上,情绪识别的科学依据非常薄弱。心理学家保罗·埃克曼提出的六种基本情绪理论已受到后续研究的广泛质疑。不同文化背景下的人们表达情感的方式差异显著,使得创建通用的情绪识别系统几乎成为一项无法完成的任务。

玛丽女王大学的AI研究员迈克·库克直言,情绪检测在普遍意义上是不可行的。尽管人们常自信能通过观察判断他人情绪,但这种能力实际上远比想象中复杂且不可靠。

更令人担忧的是,这类AI系统往往带有严重偏见。研究表明,面部分析模型可能对不同肤色的人群产生不同的情绪判断,这将进一步加剧社会歧视。

尽管谷歌声称对PaliGemma2进行了全面测试,并在某些基准测试中表现优异,但专家们对此仍持怀疑态度。他们认为,有限的测试无法全面评估这项技术可能带来的伦理风险。

最危险的是,这种开放模型可能被滥用于就业、教育、执法等关键领域,对弱势群体造成实际伤害。正如瓦赫特教授所警告的,我们可能面临一个可怕的“失控”未来:人们的就业、贷款和教育机会将由一个不可靠的AI系统的“情绪判断”决定。

在人工智能飞速发展的今天,我们既要重视技术创新,也不能忽视伦理和安全。PaliGemma2的出现,再次提醒我们要对AI技术保持清醒和批判性的审视。

暂无评论