豆包大模型团队官方公众号透露,在北交大与中国科学技术大学的共同研究推动下,豆包大模型团队研发的“VideoWorld”视频生成实验模型已正式对外开源。

该模型最显著的特点是,它摆脱了传统语言模型的束缚,仅通过视觉信息便能认知和理解世界。这一创新灵感源自李飞飞教授在TED演讲中提出的“幼儿无需语言也能理解真实世界”的观点。

“VideoWorld”通过分析处理海量视频数据,展现出强大的推理、规划和决策能力。实验表明,即便在参数量仅为300M的情况下,该模型也能取得显著成效。与依赖语言或标签数据的现有模型不同,VideoWorld能够独立进行知识学习,尤其在折纸、打领结等复杂任务中,提供了更为直观的学习途径。

为了验证模型的有效性,研究团队设置了围棋对战和机器人模拟操控两种实验环境。围棋作为策略性极强的游戏,能够有效检验模型的规则学习和推理能力;而机器人任务则评估模型在控制和规划方面的表现。在训练阶段,模型通过观看大量视频演示数据,逐步提升对未来画面的预测能力。

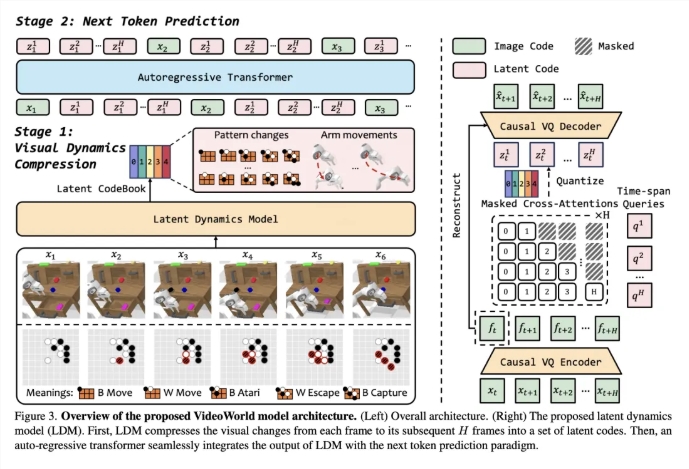

为了提升视频学习的效率,团队引入了一种潜在动态模型(LDM),旨在压缩视频帧之间的视觉变化,提取关键信息。这一方法减少了冗余信息,提高了模型对复杂知识的学习效率。通过这一创新,VideoWorld在围棋和机器人任务中表现出色,甚至达到了专业五段围棋的水平。

论文链接:https://arxiv.org/abs/2501.09781

代码链接:https://github.com/bytedance/VideoWorld

项目主页:https://maverickren.github.io/VideoWorld.github.io

划重点:

🌟 “VideoWorld”模型仅凭视觉信息实现知识学习,无需依赖语言模型。

🤖 模型在围棋和机器人模拟任务中展现出卓越的推理和规划能力。

🔓 该项目代码与模型已开源,欢迎各界人士参与体验与交流。

暂无评论