Meta AI近期重磅推出了名为SPIRIT LM的基础多模态语言模型,能够灵活融合文本与语音,为音频和文本的多模态任务开辟了新的可能性。

SPIRIT LM基于一个具有70亿参数的预训练文本语言模型,通过持续训练文本和语音单元,成功扩展到语音模态。它不仅可以理解和生成文本,像传统的大型文本模型一样,还能理解和生成语音,并且能够将文本与语音结合,创造出多种令人惊叹的效果。例如,用户可以利用它进行语音识别,将语音转换为文字;也可以进行语音合成,把文字转换为语音;更可以执行语音分类,识别一段语音所传达的情感。

更为惊人的是,SPIRIT LM特别擅长“情感表达”。它能够识别和生成多种语调和风格的语音,使得AI的声音听起来更自然,更具情感色彩。想象一下,SPIRIT LM生成的语音不再是冰冷的机械音,而是如同真人般,充满了各种情绪的表现!

为了让AI更加“声情并茂”,Meta的研究人员专门开发了两个版本的SPIRIT LM:

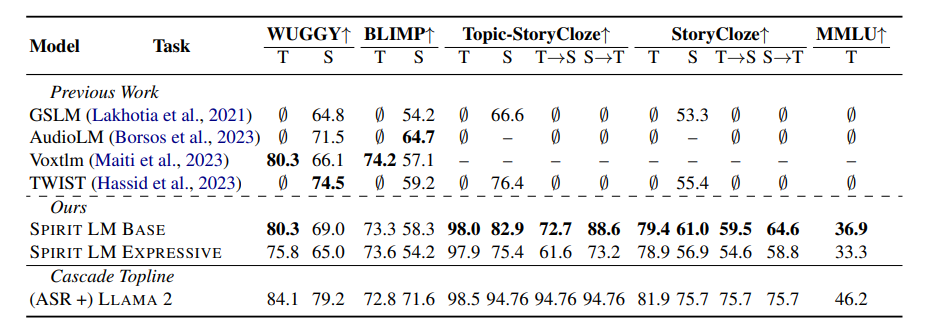

“基础版”(BASE):专注于语音的音素信息,即语音的基本构成。

“表达版”(EXPRESSIVE):除了包含音素信息外,还融入了音调和风格信息,让AI的声音更加生动和富有表现力。

那么,SPIRIT LM是如何实现这些功能的呢?

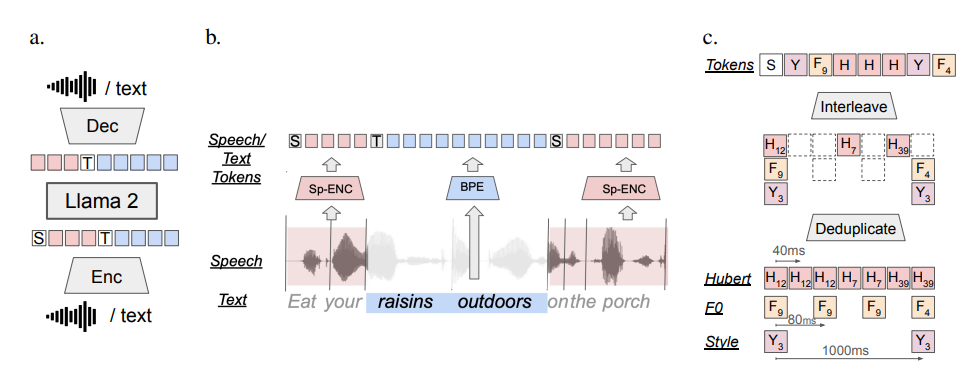

简而言之,SPIRIT LM的基础是Meta之前发布的强大文本模型LLAMA2。研究人员将大量文本与语音数据输入LLAMA2,并采用特别的“交错训练”方法,使LLAMA2能够同时学习文本与语音的规律。

为了评估SPIRIT LM的“情感表达”能力,Meta的研究团队设计了一个新的测试基准——“语音-文本情感保留基准”(STSP)。该基准包含表达不同情感的语音和文本提示,用于验证AI模型是否能够准确识别和生成相应情感的语音和文本。测试结果显示,SPIRIT LM的“表达版”在情感保留方面表现优异,是目前首个能够跨模态保留情感信息的AI模型!

当然,Meta的研究人员也坦诚道,SPIRIT LM仍有许多需改进之处。例如,当前只支持英语,未来需要扩展至其他语言;另外,SPIRIT LM的模型规模尚且不够,未来仍需扩大模型规模,以提高性能。

SPIRIT LM标志着Meta在AI领域的一次重大进展,为我们打开了进入“声情并茂”AI世界的大门。相信不久的将来,我们将看到更多基于SPIRIT LM开发的有趣应用,使AI不仅能够沟通交流,还能够像人类一样,表达情感,进行更自然、更亲密的互动!

项目地址:https://speechbot.github.io/spiritlm/

论文地址:https://arxiv.org/pdf/2402.05755

暂无评论