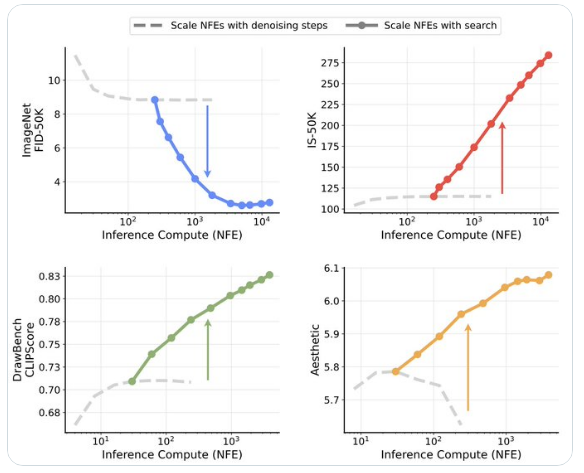

近期,由纽约大学、麻省理工学院和谷歌的研究人员共同提出了一种创新性框架,该框架致力于克服扩散模型在推理时间扩展上的限制。这一研究突破性地超越了仅通过增加去噪步骤的传统方法,为提高生成模型的性能提供了新的解决方案。

该框架主要从两个方向进行探索:一方面,通过验证器提供反馈;另一方面,通过算法寻找更优的噪声候选。研究团队以256×256分辨率的预训练SiT-XL模型为基础,在维持250个固定去噪步骤的同时,巧妙地引入了额外用于搜索操作的计算资源。

在验证系统方面,研究采用了两个Oracle Verifier:Inception Score(IS)和Fréchet Inception Distance(FID)。IS基于预训练的InceptionV3模型,选取分类概率最高的结果;而FID则致力于将预先计算的ImageNet Inception特征统计与实际图像之间的差异最小化。

实验结果表明,这一框架在多个基准测试中均表现出色。在DrawBench测试中,LLM Grader的评估表明,搜索验证方法能够持续提升样本质量。特别是ImageReward和Verifier Ensemble在各项指标上均取得了显著进步,这得益于它们精确的评估能力以及与人类偏好的高度一致性。

这项研究不仅验证了基于搜索的计算扩展方法的有效性,还揭示了不同验证器存在的固有偏差,为未来开发更专业的视觉生成任务验证系统提供了方向。这一发现对于提升AI生成模型的整体性能具有深远意义。

暂无评论