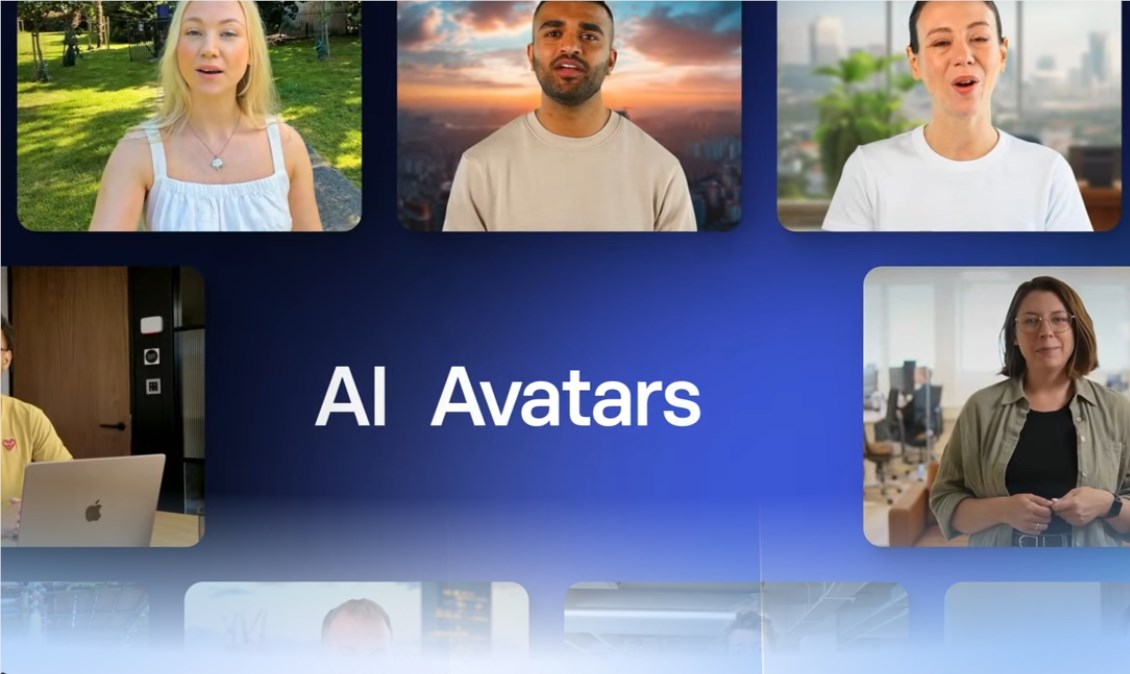

近期,字节跳动的研究团队成功研发了一款名为 OmniHuman 的人工智能系统。该系统能够将静态照片转换成生动逼真的视频,展现人物的表情、动作和语言。这一革命性技术的出现,有望对数字娱乐和通讯领域产生深远影响。

OmniHuman 能够生成全身动作视频,不仅能够展现人物的面部表情,还能捕捉到手势和全身动态。与以往只能生成面部或上半身的AI模型相比,这一技术实现了质的飞跃。其核心在于,它通过“全条件”训练方法,融合文本、音频和人体动作等多种输入,使AI从更广泛、更丰富的数据集中学习。

研究团队透露,OmniHuman 经过超过18700小时的人类视频数据训练,取得了显著的进步。通过引入多种条件信号,如文本、音频和姿势,这项技术不仅提高了视频生成的质量,还有效减少了数据浪费。

在一篇发表在arXiv的论文中,研究人员指出,尽管近年来人类动画的端到端技术取得了显著进展,但现有方法在扩大应用规模方面仍存在局限性。

OmniHuman 的应用前景广阔,可用于制作演讲视频、乐器演奏演示等。经过测试,该技术在多个质量基准上均优于现有系统,展现出其卓越的性能。在AI视频生成技术竞争日益激烈的背景下,谷歌、Meta和微软等公司也在积极研发类似技术。

尽管OmniHuman为娱乐制作、教育内容创作及数字通讯带来了变革的可能,但也引发了关于合成媒体潜在误用的担忧。研究团队将在即将召开的计算机视觉会议上展示他们的研究成果,具体时间和会议尚未公布。

论文链接:https://arxiv.org/pdf/2502.01061

划重点:

🌟 OmniHuman 是一款新型AI,能够将单张照片转化为逼真的全身视频。

📊 该技术经过18700小时的人类视频数据训练,结合多种输入信号以提升生成效果。

⚖️ 尽管具有广泛应用潜力,但也引发了关于合成媒体可能被滥用的担忧。

暂无评论