在大模型(Large Language Model,LLM)迅猛发展的当下,模型训练与推理的成本问题日益受到学术界和业界的关注。近期,腾讯混元团队公布了一项重要研究成果,深入解析了低比特浮点量化训练的“Scaling Laws”,即浮点数量化训练的规模法则。该研究的核心目标是,通过降低模型精度,研究如何在保持性能的前提下,大幅度降低计算和存储成本。

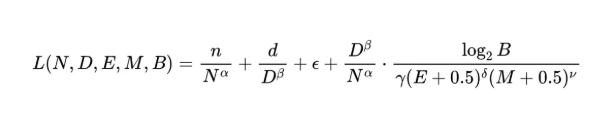

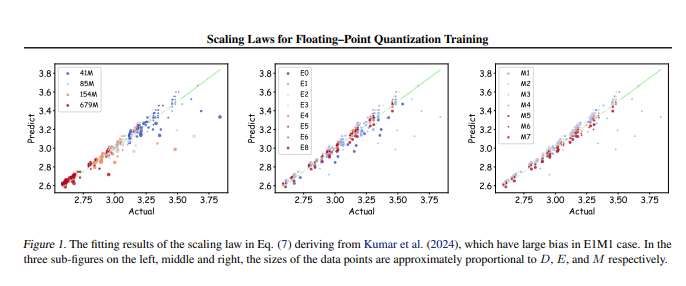

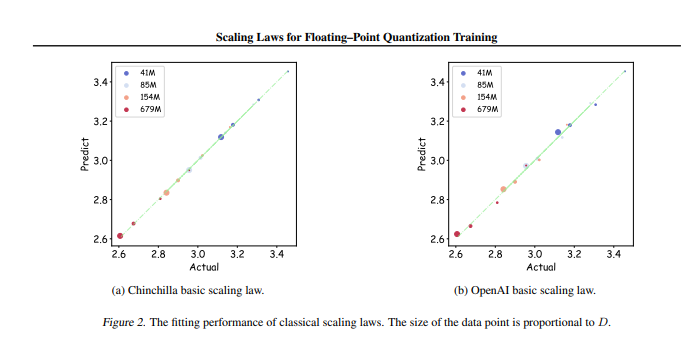

研究团队对366组不同参数规模和精度的浮点数量化训练进行了实验,系统分析了影响训练效果的多种因素,包括模型大小(N)、训练数据量(D)、指数位(E)、尾数位(M)以及量化粒度(B)。通过这些实验,研究人员总结出了一套统一的Scaling Law,揭示了在不同精度下,如何有效配置训练数据和模型参数,以实现最佳训练效果。

值得一提的是,研究指出,在任意低精度的浮点数量化训练中,存在一个“极限效果”,即在特定数据量下,模型的性能将达到最优,超过此数据量可能会导致效果下降。此外,研究还发现,理论上最佳性价比的浮点数量化训练精度应在4到8比特之间,这对于开发高效的LLM具有重要意义。

该研究不仅填补了浮点数量化训练领域的空白,还为硬件制造商提供了参考,帮助他们优化不同精度下的浮点运算能力。最终,这项研究为大模型训练实践提供了明确的方向,确保在资源有限的情况下,仍能实现高效的训练效果。

论文地址:https://arxiv.org/pdf/2501.02423

暂无评论