450美元的价格听起来并不算低。然而,当考虑到这是32B推理模型的全部训练成本时,情况就不同了。

是的,到了2025年,推理模型的开发变得越来越简单,成本也在迅速下降,达到了我们之前无法想象的水平。

(adsbygoogle=window.adsbygoogle||[]).push({});

最近,加州大学伯克利分校天空计算实验室的研究团队NovaSky发布了Sky-T1-32B-Preview。有趣的是,团队表示:「Sky-T1-32B-Preview的训练成本不到450美元,这表明可以经济、高效地复制高级推理能力。」

- 项目主页:https://novasky-ai.github.io/posts/sky-t1/

- 开源地址:https://huggingface.co/NovaSky-AI/Sky-T1-32B-Preview

根据官方信息,这款推理模型在多个关键基准测试中与OpenAI o1的早期版本相当。

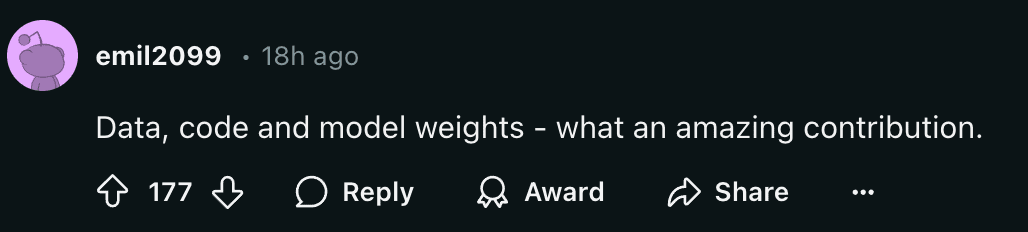

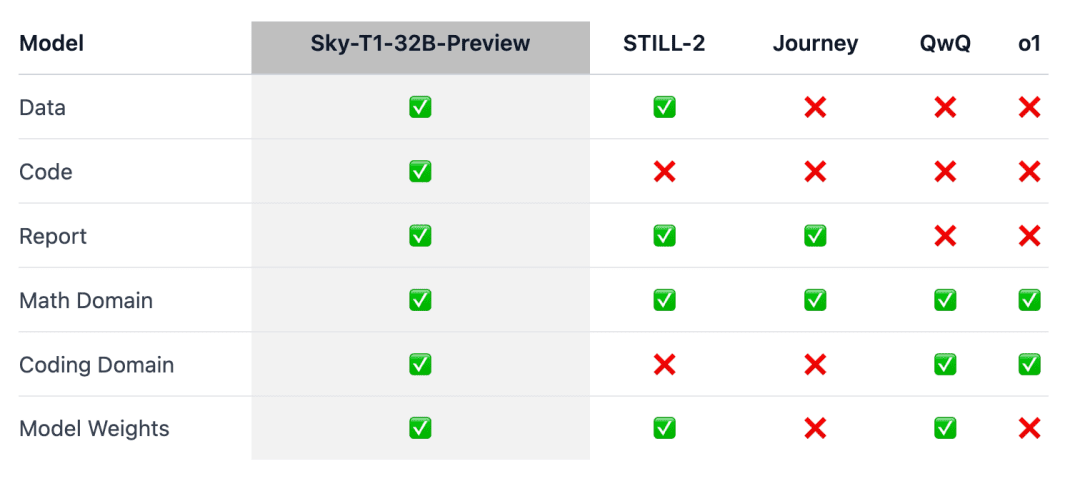

Sky-T1似乎是第一个真正开源的推理模型,因为团队发布了训练数据集以及必要的训练代码,任何人都可以从头开始复制。

大家惊叹:「数据、代码和模型权重,这是多么惊人的贡献。」

不久前,训练一个具有同等性能的模型的价格通常高达数百万美元。通过合成训练数据或由其他模型生成的训练数据,成本得到了大幅降低。

此前,一家AI公司Writer发布的Palmyra X 004几乎完全基于合成数据进行训练,开发成本仅为70万美元。

想象一下,未来我们可以在Nvidia Project Digits AI超级计算机上运行此程序,该超级计算机售价3000美元(对于超级计算机来说相当便宜),可以运行多达2000亿个参数的模型。而未来,不到1万亿个参数的模型将由个人在本地运行。

2025年的大模型技术演进正在加速,这种感觉确实强烈。

模型概述

擅长推理的o1和Gemini 2.0 flash thinking等模型通过产生长长的内部思维链,解决了复杂的任务,并取得了其他方面的进步。然而,技术细节和模型权重却无法获取,这对学术界和开源社区的参与构成了障碍。

为此,在数学领域出现了一些训练开放权重推理模型的显著成果,如Still-2和Journey。与此同时,加州大学伯克利分校的NovaSky团队一直在探索各种技术,以发展基础模型和指令调整模型的推理能力。

在Sky-T1-32B-Preview这项工作中,团队不仅在数学方面取得了有竞争力的推理性能,而且在同一模型的编码方面也取得了有竞争力的推理性能。

为确保这项工作能「惠及更广泛的社区」,团队开源了所有细节(如数据、代码、模型权重),使社区能够轻松复制和改进:

- 基础设施:在单一存储库中构建数据、训练和评估模型;

- 数据:用于训练Sky-T1-32B-Preview的17K数据;

- 技术细节:技术报告及wandb日志;

- 模型权重:32B模型权重。

技术细节

数据整理过程

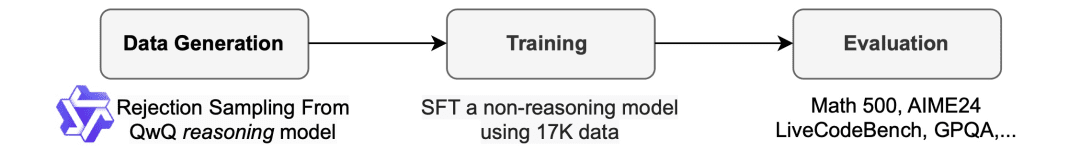

为了生成训练数据,团队使用了QwQ-32B-Preview,这是一个开源模型,其推理能力与o1-preview相当。团队对数据混合进行了整理,以涵盖需要推理的不同领域,并采用拒绝采样程序来提高数据质量。

然后,团队受到Still-2的启发,用GPT-4o-mini将QwQ trace重写为结构规整的版本,以提高数据质量并简化解析。

他们发现,解析的简便性对推理模型尤其有利。它们被训练成以特定格式做出响应,而结果往往难以解析。例如,在APPs数据集上,如果不重新格式化,团队只能假设代码是写在最后一个代码块中的,而QwQ只能达到约25%的准确率。但是,有时代码可能写在中间,经过重新格式化后,准确率会提高到90%以上。

拒绝采样。根据数据集提供的解决方案,如果QwQ样本不正确,团队就会将其丢弃。对于数学问题,团队会与ground truth解决方案进行精确匹配。对于编码问题,团队执行数据集中提供的单元测试。团队的最终数据包含来自APPs和TACO的5k编码数据,以及来自AIME、MATH和NuminaMATH数据集的Olympiads子集的10k数学数据。此外,团队还保留了来自STILL-2的1k科学和谜题数据。

训练

团队使用训练数据来微调Qwen2.5-32B-Instruct,这是一个不具备推理能力的开源模型。该模型采用3个epoch、学习率1e-5和96的批大小进行训练。使用DeepSpeed Zero-3 offload(根据Lambda Cloud的定价约为450美元),在8个H100上用19个小时完成模型训练。团队使用了Llama-Factory进行训练。

评估结果

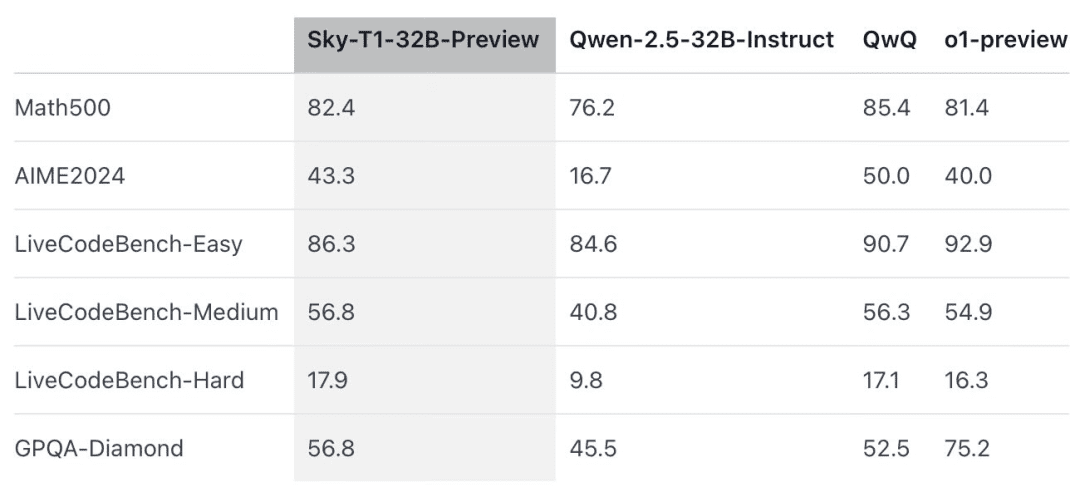

Sky-T1在MATH500(「竞赛级」数学挑战)上的表现优于o1的早期预览版本,还在一组来自LiveCodeBench(一种编码评估)的难题上击败了o1的预览版本。然而,Sky-T1不如GPQA-Diamond上的o1预览版,后者包含博士毕业生应该了解的物理、生物和化学相关问题。

不过,OpenAI的o1 GA版本比o1的预览版更强大,并且OpenAI预计将在未来几周发布性能更佳的推理模型o3。

值得重视的新发现

模型大小很重要。团队最初尝试在较小的模型(7B和14B)上进行训练,但观察到的改进不大。例如,在APPs数据集上训练Qwen2.5-14B-Coder-Instruct在LiveCodeBench上的性能略有提高,从42.6%提高到46.3%。然而,在手动检查较小模型(小于32B的模型)的输出时,团队发现它们经常生成重复内容,从而限制了它们的有效性。

数据混合很重要。团队最初使用Numina数据集(由STILL-2提供)中的3-4K个数学问题训练32B模型,AIME24的准确率从16.7%显著提高到43.3%。然而,将APPs数据集生成的编程数据纳入训练过程时,AIME24的准确率下降到36.7%。这可能意味着,这种下降是由于数学和编程任务所需的推理方法不同。

编程推理通常涉及额外的逻辑步骤,如模拟测试输入或内部执行生成的代码,而数学问题的推理往往更为直接和结构化。为了解决这些差异,团队使用NuminaMath数据集中具有挑战性的数学问题和TACO数据集中复杂的编程任务来丰富训练数据。这种均衡的数据混合使模型在两个领域都表现出色,在AIME24上恢复了43.3%的准确率,同时也提高了其编程能力。

与此同时,也有研究者表示了怀疑:

对此大家怎么看?欢迎在评论区讨论。

参考链接:https://www.reddit.com/r/LocalLLaMA/comments/1hys13h/new_model_from_httpsnovaskyaigithubio/

暂无评论