生成式语言模型在从训练到实际应用的过程中遭遇众多挑战。其中,如何使模型在推理阶段达到最佳表现是一个核心问题。

目前,解决这一问题的方法,如基于人类反馈的强化学习(RLHF),主要关注提升模型的胜率,却往往忽略了推理阶段的解码策略,如Best-of-N采样和控制解码。这种训练目标与实际应用之间的差距,可能导致效率低下,影响输出的质量和可靠性。

为解决这些问题,谷歌DeepMind和谷歌研究团队开发了InfAlign,这是一个旨在与推理策略相结合的机器学习框架。InfAlign将推理方法纳入对齐过程,旨在弥合训练与应用之间的差距。它通过一种校准的强化学习方法调整基于特定推理策略的奖励函数。InfAlign对Best-of-N采样(生成多个响应并选择最佳者)和Worst-of-N(常用于安全评估)等技术特别有效,确保对齐的模型在控制环境和现实场景中都能表现出色。

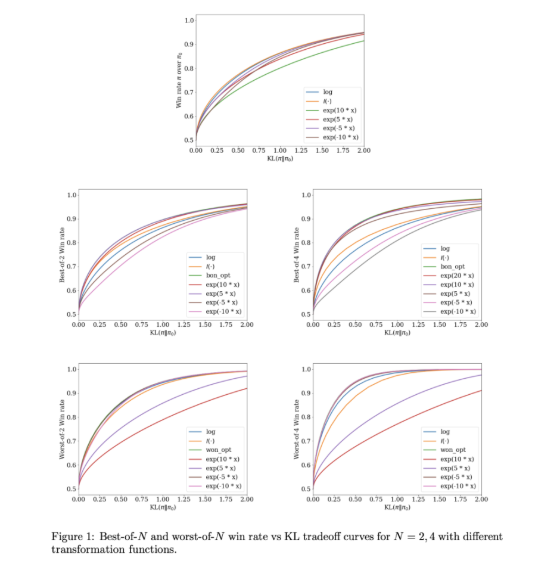

InfAlign的核心是校准与变换强化学习(CTRL)算法,该算法遵循三个步骤:校准奖励分数、根据推理策略变换这些分数、解决一个KL正则化的优化问题。通过将奖励变换定制化到特定场景,InfAlign将对齐的训练目标与推理需求相匹配。这种方法不仅提升了推理时的胜率,还保持了计算效率。此外,InfAlign增强了模型的鲁棒性,使其能够有效应对各种解码策略,并产生一致的高质量输出。

在Anthropic的有用性和无害性数据集上进行的实验验证了InfAlign的有效性。与现有方法相比,InfAlign在Best-of-N采样的推理胜率上提高了8%-12%,在Worst-of-N安全评估中则提高了4%-9%。这些改进得益于其校准的奖励变换,有效解决了奖励模型的误校准问题,确保了在不同推理场景下的一致表现。

InfAlign在生成语言模型的对齐方面代表了一项重要的进展。通过结合推理感知的策略,InfAlign解决了训练与部署之间的关键差异。其坚实的理论基础和实证结果凸显了其在全面改善AI系统对齐方面的潜力。

链接:https://arxiv.org/abs/2412.19792

划重点:

🌟 InfAlign是谷歌DeepMind开发的新框架,旨在提升语言模型在推理阶段的表现。

📈 该框架通过校准的强化学习方法,调整推理策略的奖励函数,实现训练目标与推理需求的对齐。

✅ 实验结果表明,InfAlign在多项任务中显著提高了模型的推理胜率,展现出良好的适应性和可靠性。

暂无评论