于2024年12月19日的发布会上,智源研究院携手腾讯正式发布了LongBench v2,这是一款针对评估大语言模型(LLMs)在真实世界长文本多任务中的深度理解和推理能力而设计的基准测试。该平台旨在促进长文本模型在理解和推理方面的进展,并应对当前长文本大语言模型应用中遇到的挑战。

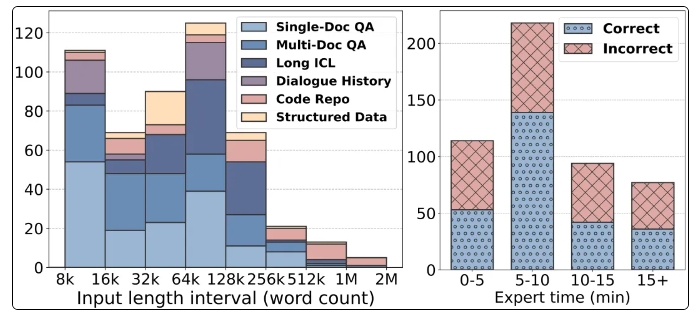

LongBench v2的显著特点是支持更长的文本长度,从8k到2M个词不等,并包含503个具有挑战性的四选一选择题,难度颇高,即使是人类专家在15分钟内的平均准确率也仅有53.7%。此外,基准测试涵盖了六个主要任务类别,包括单文档问答、多文档问答、长文本语境学习等,确保了其在广泛的应用场景中的适用性。

为确保评估的可靠性,LongBench v2的所有问题均采用多项选择题形式,并经过严格的人工标注和审核流程。在数据收集阶段,招募了来自顶尖大学的标注员,以保证问题的质量和难度。LongBench v2对原始Bradley-Terry统计算法进行了改进,通过引入控制变量,降低了混淆因素的影响,使得模型排名更加科学和精准。

在评估结果方面,研究团队对10个开源LLMs和6个闭源LLMs进行了测试,发现引入控制变量后,模型的表现显著提升。特别是GPT-4o模型在增加更多推理步骤后,在多文档问答和长文本语境学习等任务上表现出色,突显了推理能力的重要性。

LongBench v2的发布不仅为大语言模型的评估提供了新的工具,还为未来的研究指明了方向,强调了提升模型自身理解和推理能力的重要性。智源研究院与腾讯的合作,标志着AI技术领域的进一步发展,我们期待这一基准测试能够推动长文本理解和推理技术的进步。

主页:https://longbench2.github.io

论文:https://arxiv.org/abs/2412.15204

数据与代码:https://github.com/THUDM/LongBench

暂无评论