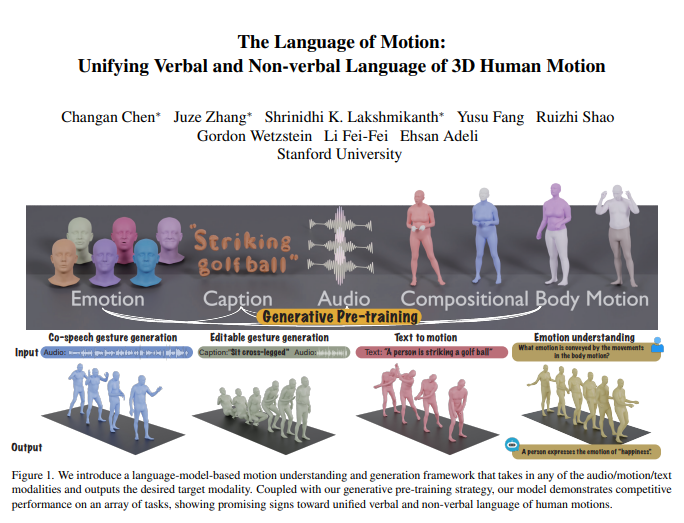

李飞飞团队研发了一款创新的多模态模型,该模型不仅能理解还能生成人类动作。通过融合语言模型,实现了口头和非口头语言的统一处理。这一研究成果让机器不仅能理解人类指令,还能解读动作中的情绪,从而提升了人机交互的自然度。

该模型的核心是其多模态语言模型框架,可接收音频、动作和文本等多种输入,并输出相应模态的数据。采用生成式预训练策略,模型在多个任务上展现了优异表现。例如,在协同语音手势生成方面,该模型不仅提升了技术水平,还减少了训练所需的数据量。此外,模型还拓展了新应用场景,如可编辑手势生成和通过动作预测情绪。

人类交流本质上是多模态的,涉及言语和非言语线索,如语音、面部表情和身体姿势。该模型能够理解这些多模态行为,对于在游戏、电影和虚拟现实等领域创建自然交流的虚拟角色至关重要。然而,现有动作生成模型往往只限于特定输入模态,无法充分利用数据的多样性。

模型利用语言模型统一口头和非口头语言的原因主要有三:

1. 语言模型能够自然地连接不同模态。

2. 语音具有高度语义性,处理如笑话反应等任务需要强大的语义推理能力。

3. 语言模型通过广泛预训练获得了强大的语义理解能力。

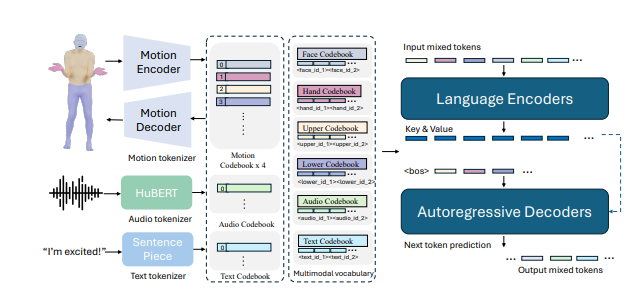

为实现这一目标,研究团队首先对身体进行分区(面部、手部、上半身、下半身),并对每个部分进行动作标记。结合文本和语音标记器,任何模态的输入都可转化为一系列标记,供语言模型使用。模型采用两阶段训练流程:先进行预训练,实现模态与身体动作对齐以及音频和文本对齐;然后针对下游任务进行训练,使模型能够遵循各种任务指令。

在BEATv2协同语音手势生成基准测试中,该模型表现卓越,远超现有模型。预训练策略的效果也得到了验证,尤其是在数据稀缺情况下,展现了强大的泛化能力。通过后训练,模型不仅能遵循音频和文本提示,还能实现从动作数据中预测情绪等新功能。

技术细节方面,模型采用模态特定标记器处理各种输入模态。具体来说,模型训练了一个组合身体运动VQ-VAE,将面部、手部、上半身和下半身的动作转化为离散标记。这些模态特定词汇(音频和文本)被整合到一个统一的多模态词汇表中。在训练过程中,不同模态的混合标记作为输入,通过编码器-解码器语言模型生成输出。

模型还利用多模态词汇表,将不同模态数据转换为统一格式进行处理。在预训练阶段,模型通过执行模态间转换任务,学习不同模态之间的对应关系。例如,模型可以学习将上身动作转换为下身动作,或将音频转换为文本。此外,模型还会通过随机屏蔽动作帧来学习动作的时间演变。

在后训练阶段,模型使用配对数据进行微调,执行协同语音手势生成或文本到动作生成等下游任务。为使模型遵循自然人类指令,研究人员构建了一个多任务指令遵循模板,将音频到动作、文本到动作和情绪到动作等任务转化为指令。模型还具备编辑手势的能力,可根据文本和音频提示生成协同的全身体动作。

最后,模型还实现了从动作预测情绪的新功能。这在心理健康或精神病学等领域具有重要意义。与其他模型相比,该模型能更准确地预测动作中的情绪,展现了强大的身体语言理解能力。

研究显示,统一人类动作的口头和非口头语言对实际应用至关重要,而语言模型提供了一个强大的框架。

论文地址:https://arxiv.org/pdf/2412.10523v1

暂无评论