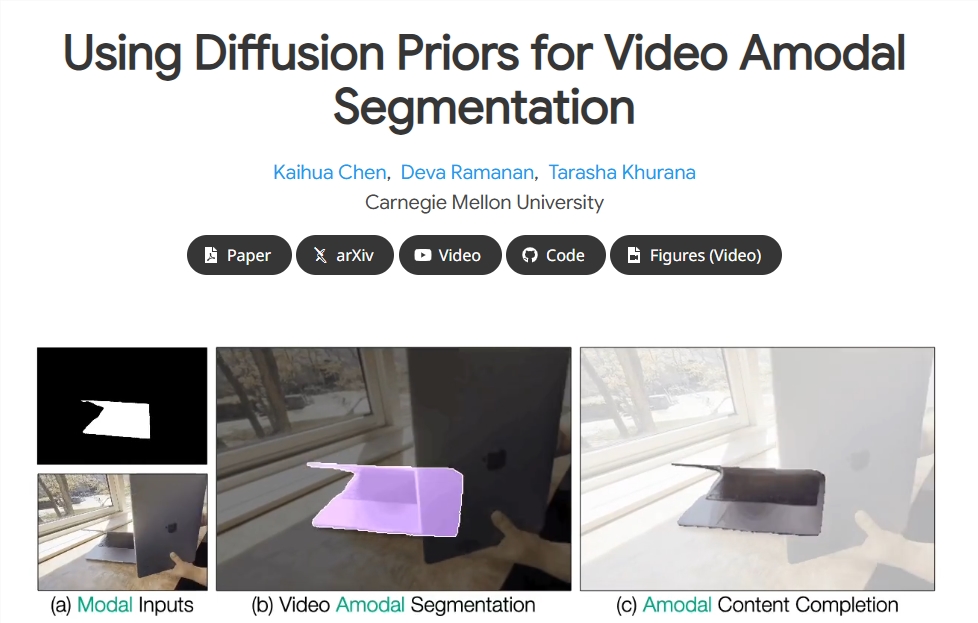

在视频分析技术中,物体的持久性是关键线索,它帮助人们理解即使物体被完全遮挡,其依然存在。然而,现有的物体分割技术大多只关注可见物体,对于不可见部分的处理则显得不足。

针对这一难题,研究人员开发了一种名为Diffusion-Vas的两阶段方法,基于扩散先验原理,旨在优化视频无模态分割和内容补全效果。该方法能够追踪视频中的目标物体,并利用扩散模型修复被遮挡的部分。

该方法的第一阶段,旨在生成物体的无模态掩码。研究人员结合可见掩码序列与伪深度图,推断出物体边界的遮挡情况。伪深度图是通过单目深度估计从RGB视频序列中获得的。这一步骤的目标是识别出场景中可能被遮挡的物体部分,进而完善物体的完整轮廓。

在第一阶段生成的无模态掩码基础上,第二阶段负责对遮挡区域进行内容补全。研究团队采用条件生成模型,利用模态RGB内容填补遮挡区域,最终生成完整的无模态RGB内容。整个流程采用了以3D UNet为骨干网络的条件潜在扩散框架,确保了生成结果的高保真度。

为了验证该方法的有效性,研究团队在四个数据集上进行了基准测试。结果显示,与多种先进方法相比,该方法在物体被遮挡区域的无模态分割准确率提高了多达13%。特别是在处理复杂场景时,该方法展现了出色的稳健性,能够有效应对剧烈的相机运动和频繁的完全遮挡。

这项研究不仅提升了视频分析的精确度,还为理解复杂场景中物体的存在性提供了新视角。未来,这项技术有望应用于自动驾驶、监控视频分析等多个领域。

项目地址:https://diffusion-vas.github.io/

划重点:

🌟 研究提出了一种新方法,通过扩散先验实现视频中的无模态分割和内容补全。

🖼️ 方法分为两阶段,首先生成无模态掩码,然后进行遮挡区域的内容补全。

📊 在多项基准测试中,该方法显著提高了无模态分割的准确性,尤其在复杂场景下表现优异。

暂无评论