艾伦人工智能研究所(AI2)近期重磅推出全新大型语言模型——OLMo232B。这款模型凭借其“完全开放”的理念,在众多专有模型中脱颖而出,成为OLMo2系列的最新力作。

OLMo232B的最大亮点是其全面开源的特性。AI2慷慨地公开了模型的所有数据、代码、权重和详细训练过程,这种透明度与一些封闭的模型形成了鲜明对比。

AI2希望通过这种开放合作模式,推动更广泛的研究和创新,让全球研究人员都能利用OLMo232B继续探索。在知识共享的时代,保守并非长久之计。

320亿参数,实力不容小觑

除了开放精神,OLMo232B在实力上也相当出色。它拥有320亿参数,相比前代有显著提升。

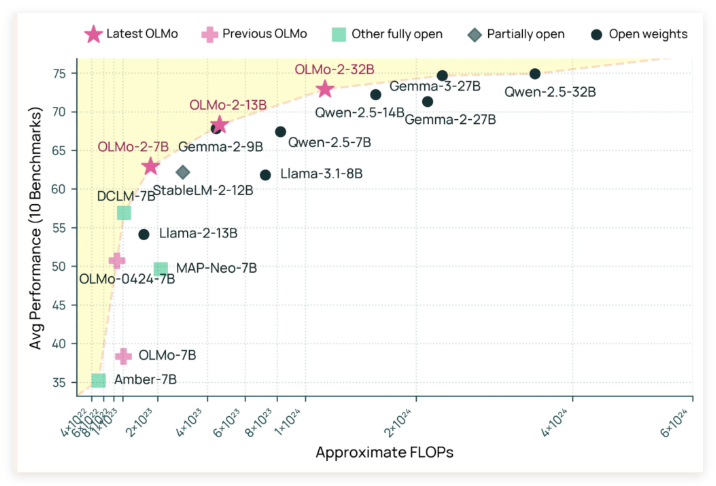

在多项学术基准测试中,OLMo232B甚至超越了GPT-3.5Turbo和GPT-4o mini,为开源AI社区注入了一剂强心针,证明了顶尖AI模型并非只有“财大气粗”的机构才能研发。

OLMo232B之所以取得如此成绩,与其精细的训练过程密不可分。训练过程分为预训练和中期训练两个阶段。预训练阶段,模型学习了约3.9万亿tokens的数据集,中期训练则专注于Dolmino数据集,提升了模型在特定领域的理解能力。

OLMo232B在训练效率方面也表现出色。它在达到与领先模型相当性能的同时,仅使用了大约三分之一的计算资源,预示着未来可能出现更多“平民级”的强大AI模型。

开放AI发展里程碑

OLMo232B的发布不仅是一款新AI模型,更是开放和可访问AI发展道路上的重要里程碑。AI2通过提供性能优异的解决方案,证明了周密的模型设计和高效的训练方法能够带来巨大突破。

OLMo232B的出现为AI研究领域带来一股清新的空气,降低了研究门槛,促进了更广泛的合作,展现了更具活力和创新性的AI发展路径。

github:https://github.com/allenai/OLMo-core

huggingface:https://huggingface.co/allenai/OLMo-2-0325-32B-Instruct

暂无评论