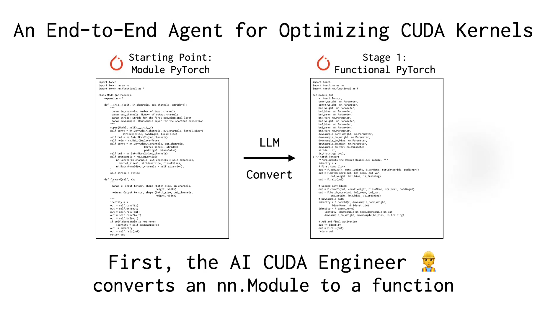

日本初创人工智能公司Sakana AI最新发布了一款名为“AI CUDA工程师”的创新型AI智能体系统。该系统旨在实现CUDA内核的自动化优化,极大提升机器学习操作的执行效率。据X平台最新资讯,该系统运用大型语言模型(LLM)驱动的代码优化技术,将PyTorch常见操作的执行速度提升了10至100倍,标志着AI技术在GPU性能优化领域的重要突破。

Sakana AI透露,CUDA内核是GPU计算的核心,通常需要丰富的专业知识和较高的技术门槛才能进行编写和优化。虽然现有的框架如PyTorch操作简便,但在性能上往往无法与手动优化的内核相提并论。“AI CUDA工程师”通过智能化的工作流程解决了这一难题:它不仅能够将PyTorch代码自动转换为高效的CUDA内核,还能利用进化算法进行性能调优,甚至能够融合多个内核以进一步提高运行效率。

用户@shao__meng将这一技术形象地比喻为“为AI开发装上了自动变速箱”,使普通代码能够“自动升级为赛车级性能”。另一位用户@FinanceYF5也在帖子中指出,该系统的推出展示了AI自优化的巨大潜力,未来有望为计算资源的使用效率带来革命性的提升。

Sakana AI凭借“AI Scientist”等项目已在业界崭露头角,此次“AI CUDA工程师”的发布进一步彰显了公司在AI自动化领域的雄心。公司宣称,该系统已成功生成并验证了超过17,000个CUDA内核,涵盖了多种PyTorch操作,并提供公开数据集,为研究人员和开发者提供了宝贵资源。业界人士认为,这一技术不仅降低了高性能GPU编程的门槛,还可能推动人工智能模型的训练和部署效率实现新飞跃。

信息来源:https://x.com/FinanceYF5/status/1892856847780237318

暂无评论