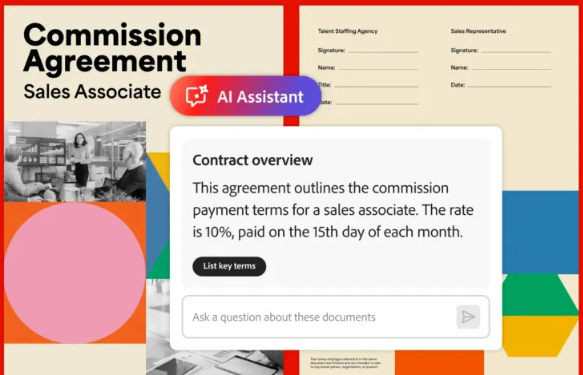

人工智能企业Anthropic近期推出了一种名为“体质分类器”的新安全技术,旨在防御语言模型遭受恶意攻击。这项技术特别针对“通用越狱”现象——即尝试绕过所有安全措施的一种系统性攻击手段,以防止AI模型产生有害信息。

为了检验该技术的实用性,Anthropic开展了一次大规模的测试。他们招募了183名测试者,要求他们在两个月内尝试破解其安全防御系统。测试者需通过提出特定问题,试图诱导AI模型Claude3.5回答被禁止的十个问题。尽管提供了高达15,000美元的奖金以及约3,000小时的测试时间,但所有测试者均未能成功绕过Anthropic的安全措施。

**挑战中的成长**

Anthropic早期版本的“体质分类器”存在两个问题:一是将过多无害请求误判为危险请求,二是计算资源消耗巨大。经过改进,新版本分类器大幅降低了误判率,同时提高了计算效率。尽管如此,自动测试显示,即便改进后的系统成功阻止了超过95%的越狱尝试,但仍需额外23.7%的计算能力。相比之下,未受保护的Claude模型有86%的越狱尝试得以成功。

**基于合成数据的训练**

“体质分类器”的核心在于使用预定义的规则(即“宪法”)来辨别允许和禁止的内容。系统通过生成多语言、多风格的合成训练示例,训练分类器识别可疑输入。这种方法不仅提高了系统的准确性,还增强了其对抗多样化攻击的能力。

尽管取得了显著进步,Anthropic的研究人员承认,该系统并非完美无缺。它可能无法应对所有类型的通用越狱攻击,且未来可能出现新的攻击方式。因此,Anthropic建议将“体质分类器”与其他安全措施结合使用,以提供更全面的保护。

**公开测试与未来展望**

为了进一步检验系统的强度,Anthropic计划于2025年2月3日至10日期间发布公开演示版本,邀请安全专家尝试破解。测试结果将在后续更新中公布。这一举措不仅展示了Anthropic对技术透明度的承诺,也为AI安全领域的研究提供了宝贵的数据。

Anthropic的“体质分类器”代表了AI模型安全防护领域的重要进展。随着AI技术的快速发展,如何有效防止模型被滥用已成为行业关注的焦点。Anthropic的创新为这一挑战提供了新的解决方案,同时也为未来的AI安全研究指明了方向。

暂无评论