一篇专注于医疗AI评测的研究论文揭露了微软意外地透露了业界多个顶级大语言模型的参数规模。该论文发布于12月26日,不仅揭示了OpenAI、Anthropic等公司模型的参数数据,还引发了行业对模型架构和技术实力的广泛讨论。

据论文披露,OpenAI的o1-preview模型有约300B参数,GPT-4o约200B,而GPT-4o-mini仅有8B参数。这与英伟达年初公布的GPT-4采用1.76T MoE架构的描述形成鲜明对比。此外,论文还透露了Claude3.5Sonnet的参数规模约为175B。

这不是微软首次在论文中意外泄露模型参数信息。去年10月,微软曾在另一篇论文中披露GPT-3.5-Turbo的20B参数规模,但随后又在更新版本中删除了这一信息。这种反复的“泄露”行为引发了业界对其是否存在特定意图的猜测。

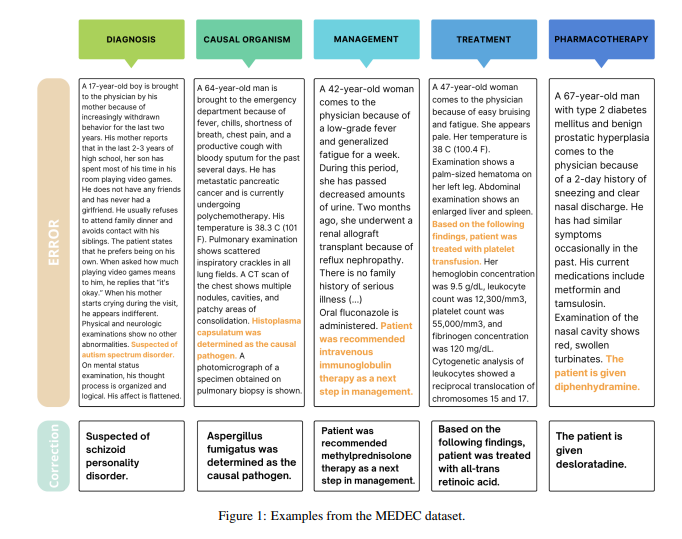

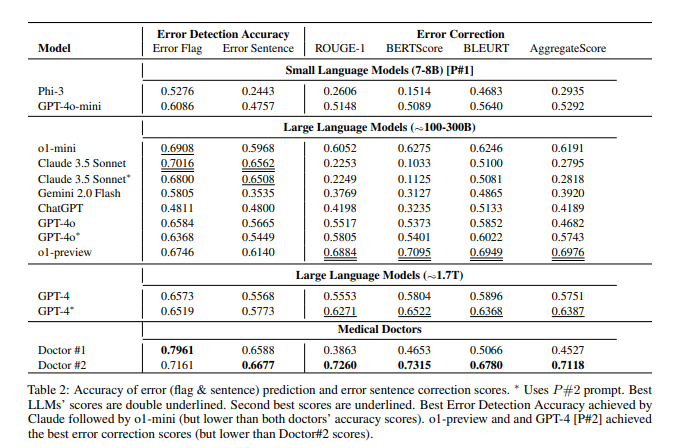

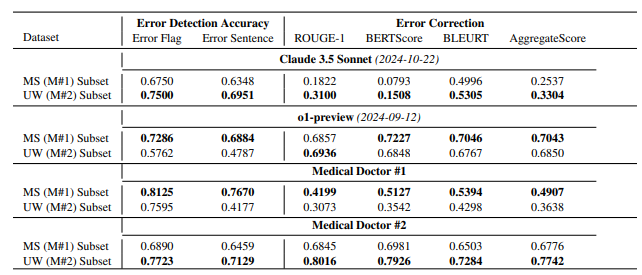

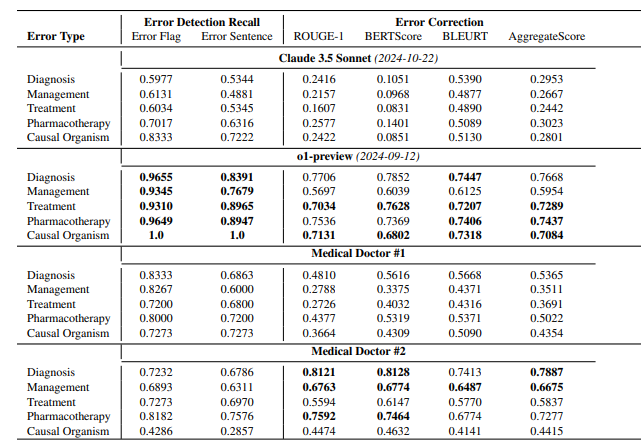

值得注意的是,这篇论文的主要目的是介绍MEDEC,一个针对医疗领域的基准测试。研究团队分析了来自三家美国医院的488份临床笔记,评估了不同模型在识别和纠正医疗文档错误方面的能力。测试结果显示,Claude3.5Sonnet在错误检测方面以70.16的得分领先其他模型。

行业对这些数据的真实性展开了热烈讨论。有观点认为,如果Claude3.5Sonnet确实以更小的参数量达到优秀性能,这将凸显Anthropic的技术实力。同时,也有分析人士通过模型定价来推测,部分参数估计具有一定的合理性。

特别值得注意的是,论文仅对主流模型参数进行了估计,却未提及谷歌Gemini的具体参数。有分析认为,这可能与Gemini使用TPU而非英伟达GPU有关,导致难以通过token生成速度进行准确估算。

随着OpenAI逐渐淡化开源承诺,模型参数等核心信息可能会继续成为业界持续关注的焦点。这次意外的泄露再次引发了人们对AI模型架构、技术路线以及商业竞争的深入思考。

参考资料:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

暂无评论