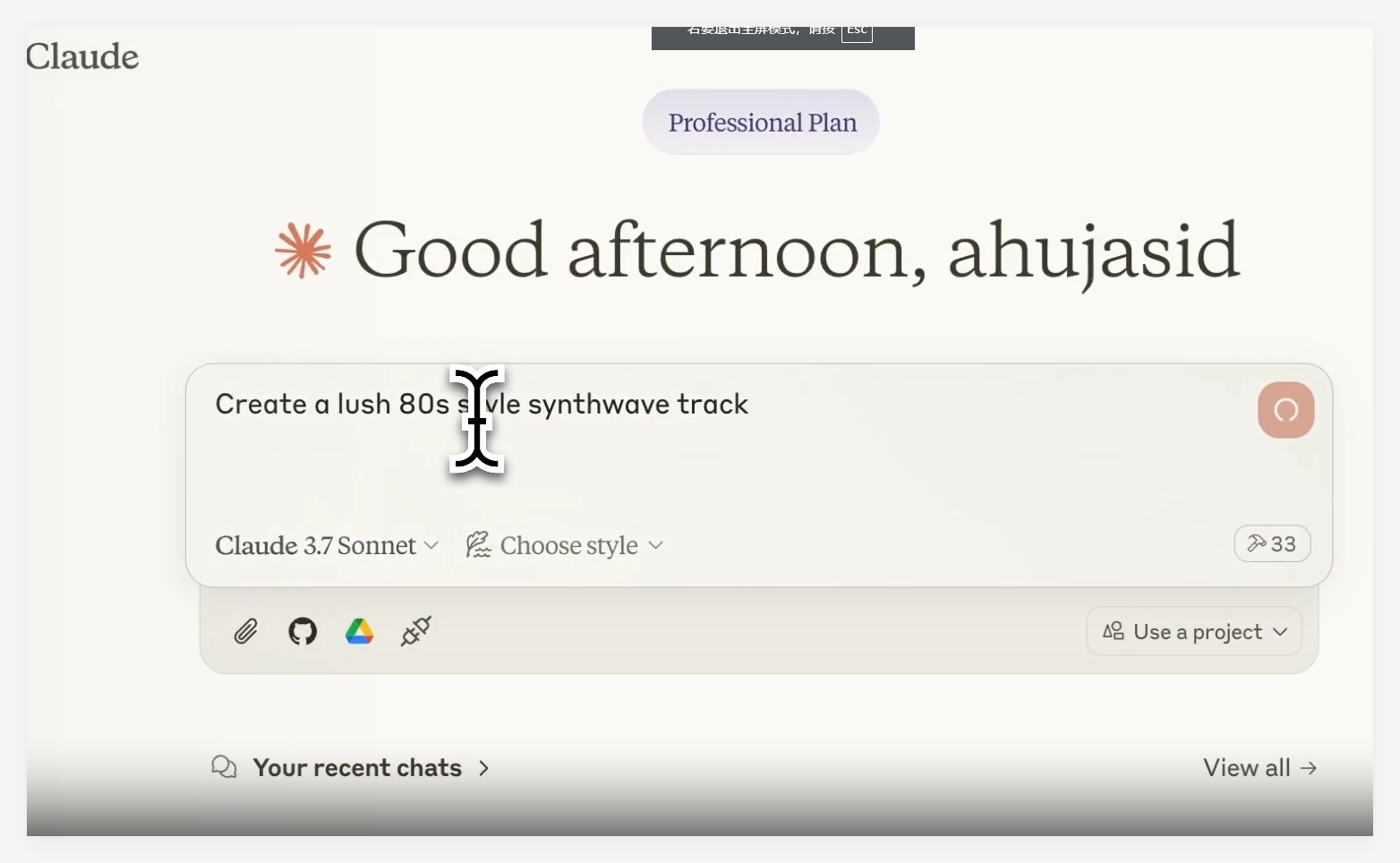

TechCrunch最近揭露,谷歌正在利用Anthropic公司的Claude AI模型来衡量自家Gemini AI模型的性能,这一举动在业界引发了关于合规性的热议。

据悉,TechCrunch查阅了内部文件,发现谷歌Gemini项目的承包商正在对比Gemini与Claude的回答,以此评估两者的准确性和质量。在此过程中,承包商需要在30分钟内决定哪个AI模型的回答更胜一筹。报道还指出,在谷歌用于比较AI模型的平台上,Claude的回答中出现了对自身的引用。在安全性方面,Claude似乎比Gemini更为严格,有时会拒绝被认为不安全的提示,或给出更为谨慎的回答。例如,Gemini的一个回答因涉及“裸体和束缚”内容而被标记为“重大的安全违规”。

Anthropic的服务条款明确指出,未经批准,不得使用Claude来构建竞争产品或训练竞争AI模型。谷歌DeepMind的发言人证实,他们确实会为了评估目的比较不同模型的输出,但否认使用Anthropic的模型来训练Gemini。值得注意的是,谷歌也是Anthropic的主要投资者。

谷歌DeepMind的发言人Shira McNamara表示:“按照行业标准实践,我们有时会比较模型输出作为评估过程的一部分。然而,任何关于我们使用Anthropic模型来训练Gemini的说法都是不准确的。”

📜 谷歌使用Anthropic的Claude AI评估Gemini,可能违反服务条款。

🔐 Claude在安全性方面的表现似乎比Gemini更为严格。

💼 谷歌DeepMind否认使用Anthropic模型训练Gemini,同时确认了评估模型输出的做法。

暂无评论